- 紹介

-

新世代のファイアウォール・ソリューションは、綿密なセキュリティ機能により、ビジネス・アプリケーションとデータを包括的に保護します。

新世代のファイアウォール・ソリューションは、綿密なセキュリティ機能により、ビジネス・アプリケーションとデータを包括的に保護します。 アプリケーションの容量と可用性を向上

アプリケーションの容量と可用性を向上 あらゆる業務ワークロードに対応するスループットと容量の多様性

あらゆる業務ワークロードに対応するスループットと容量の多様性 データのバックアップと復元を瞬時に、安全に、データの整合性を保ちながら行います。

データのバックアップと復元を瞬時に、安全に、データの整合性を保ちながら行います。 ビジネスコストを最大90%削減

ビジネスコストを最大90%削減 包括的なスキャン能力、詳細な分析、およびセキュリティホールの評価を提供して、ビジネスアプリケーションシステムの情報セキュリティを強化します

包括的なスキャン能力、詳細な分析、およびセキュリティホールの評価を提供して、ビジネスアプリケーションシステムの情報セキュリティを強化します 迅速な拡張性を備えた先進の仮想サーバーサービス

迅速な拡張性を備えた先進の仮想サーバーサービス FPT CloudとCyRadarの連携製品であるこのファイアウォールサービスは、Webアプリケーションを強力に保護します

FPT CloudとCyRadarの連携製品であるこのファイアウォールサービスは、Webアプリケーションを強力に保護します 3D レンダリング、AI、ML 用の仮想サーバーと統合

3D レンダリング、AI、ML 用の仮想サーバーと統合 今すぐ独占的な先行予約を確保し、 NVIDIAの強力なテクノロジー によって駆動される

今すぐ独占的な先行予約を確保し、 NVIDIAの強力なテクノロジー によって駆動される

AI開発のための オールインクルーシブスタックへの 優先アクセスを手に入れましょう! 今すぐ独占的な先行予約を確保し、 NVIDIAの強力なテクノロジー によって駆動される

今すぐ独占的な先行予約を確保し、 NVIDIAの強力なテクノロジー によって駆動される

AI開発のための オールインクルーシブスタックへの 優先アクセスを手に入れましょう! 3D レンダリング、AI、ML 用の仮想サーバーと統合

3D レンダリング、AI、ML 用の仮想サーバーと統合 迅速な拡張性を備えた先進の仮想サーバーサービス

迅速な拡張性を備えた先進の仮想サーバーサービス ビジネスコストを最大90%削減

ビジネスコストを最大90%削減 独立したインフラで強力なパフォーマンス

独立したインフラで強力なパフォーマンス サービスは、すべてのサイズでAPIを初期化、維持、管理、保護します

サービスは、すべてのサイズでAPIを初期化、維持、管理、保護します

FPT Kubernetes Engineでアプリケーションを迅速に作成、管理、展開するソリューションを提供します

FPT Kubernetes Engineでアプリケーションを迅速に作成、管理、展開するソリューションを提供します コンテナ画像の保存、管理、デプロイ、セキュリティ保護が容易

コンテナ画像の保存、管理、デプロイ、セキュリティ保護が容易

スマート管理サービス

スマート管理サービス 企業向けの仮想コンピューターサービス

企業向けの仮想コンピューターサービス いつでも、どこでも、どんなプラットフォームでものシステム監視ソリューション

いつでも、どこでも、どんなプラットフォームでものシステム監視ソリューション 高度なGPU処理と統合されたKubernetesサービスにより、高パフォーマンスのアプリケーション開発を加速

高度なGPU処理と統合されたKubernetesサービスにより、高パフォーマンスのアプリケーション開発を加速 サービスとして提供され、クラウドでのMongoDBデータベースのデプロイ、監視、バックアップ、復旧、拡張をサポートする

サービスとして提供され、クラウドでのMongoDBデータベースのデプロイ、監視、バックアップ、復旧、拡張をサポートする "サービスとして提供され、クラウドでのMySQLデータベースのデプロイ、監視、バックアップ、復旧、拡張をサポートする

"サービスとして提供され、クラウドでのMySQLデータベースのデプロイ、監視、バックアップ、復旧、拡張をサポートする サービスとして提供され、クラウドでのPostgreSQLデータベースのデプロイ、監視、バックアップ、復旧、拡張をサポートする

サービスとして提供され、クラウドでのPostgreSQLデータベースのデプロイ、監視、バックアップ、復旧、拡張をサポートする サービスとして提供され、クラウドでのRedisデータベースのデプロイ、監視、バックアップ、復旧、拡張をサポートする

サービスとして提供され、クラウドでのRedisデータベースのデプロイ、監視、バックアップ、復旧、拡張をサポートする アプリケーションの容量と可用性を向上

アプリケーションの容量と可用性を向上 FPT CloudとCyRadarの連携製品であるこのファイアウォールサービスは、Webアプリケーションを強力に保護します

FPT CloudとCyRadarの連携製品であるこのファイアウォールサービスは、Webアプリケーションを強力に保護します 包括的なスキャン能力、詳細な分析、およびセキュリティホールの評価を提供して、ビジネスアプリケーションシステムの情報セキュリティを強化します

包括的なスキャン能力、詳細な分析、およびセキュリティホールの評価を提供して、ビジネスアプリケーションシステムの情報セキュリティを強化します 新世代のファイアウォール・ソリューションは、綿密なセキュリティ機能により、ビジネス・アプリケーションとデータを包括的に保護します。

新世代のファイアウォール・ソリューションは、綿密なセキュリティ機能により、ビジネス・アプリケーションとデータを包括的に保護します。 無制限のストレージ、安全で保証されたパフォーマンス、継続的で高いデータ検索ニーズ

無制限のストレージ、安全で保証されたパフォーマンス、継続的で高いデータ検索ニーズ あらゆる業務ワークロードに対応するスループットと容量の多様性

あらゆる業務ワークロードに対応するスループットと容量の多様性 - 価格表

- パートナー

- イベント

全ての資料

Managed GPU Cluster (Kubernetes)

Ollama は、パーソナル コンピューターまたはサーバー上で大規模言語モデル (LLM) を実行、管理、およびカスタマイズできるオープンソース ツールであり、Llama、DeepSeek、Mistral などのさまざまなモデルをサポートしています。Open-WebUIは、Ollama との対話のために特化したオープンソースのWebインターフェイスで、LLM モデルの管理と使用においてユーザーフレンドリーで簡単なUXを提供します。

このドキュメントでは、ユーザーが簡単に使用できるように、Ollama と Open-WebUI を使用して DeepSeek-R1 モデルを FPT マネージド GPU クラスターにデプロイする手順について説明します。

ステップ1:Open-WebUIのソースコードと既存のスクリプトをクローンします。

> git clone https://github.com/open-webui/open-webui

> cd open-webui/kubernetesステップ2: スクリプトを実行して、ollamaとopen-webuiを展開します。フォルダ内には、namespace、ollama statefulSet、ollama サービス、open-webui デプロイメント、open-webui サービスなど、デプロイに必要なすべてのファイルが含まれています。

> cd kubernetes

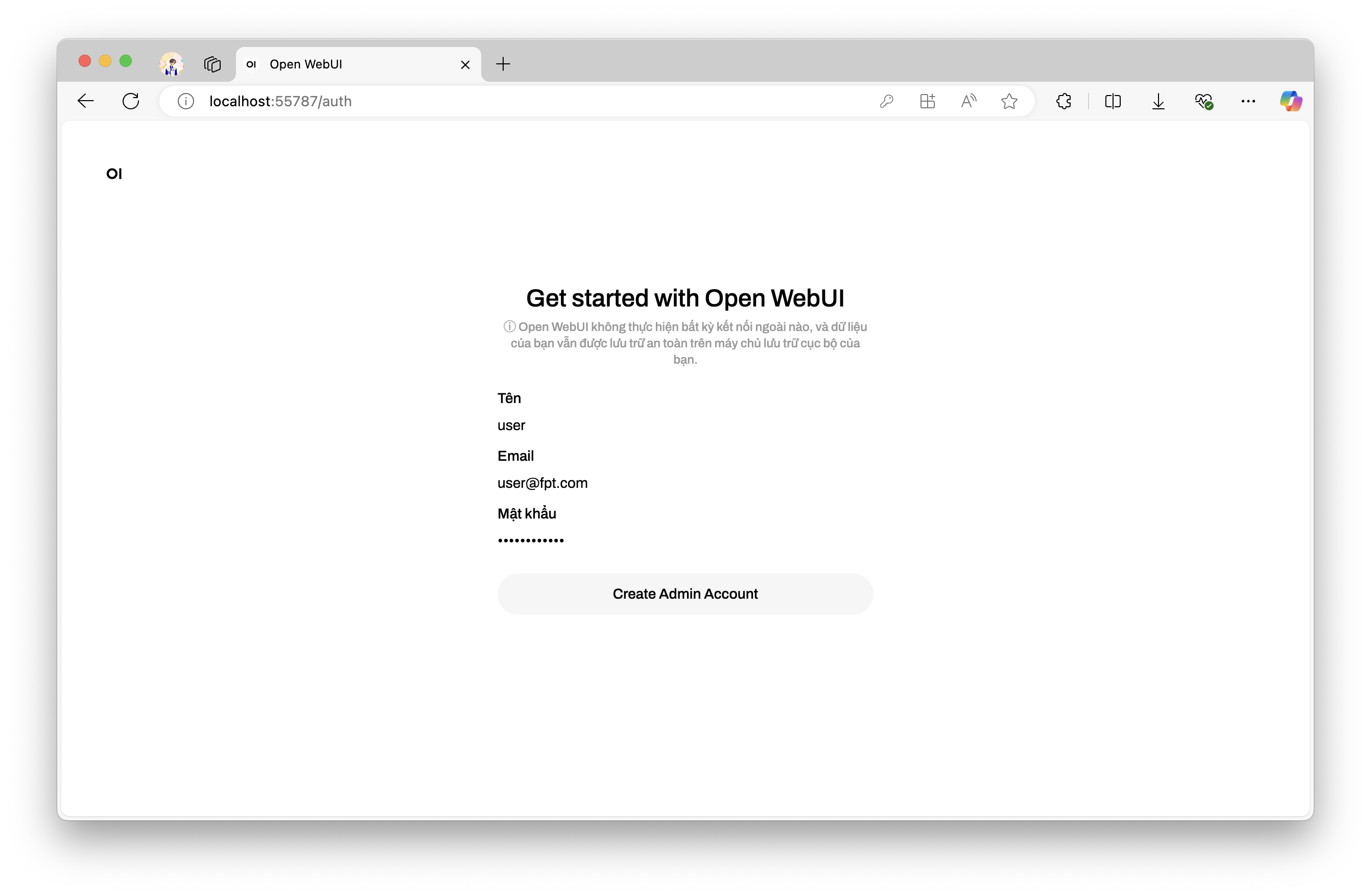

> kubectl apply -f ./kubernetes/manifestステップ3: 転送されたポート(例: http://localhost:52433.)でブラウザーでopen-webuiにアクセスします。 OpenWebUIを初めてインストールして使用する場合、ユーザーは名前、電子メール、パスワードの情報を設定する必要があります。

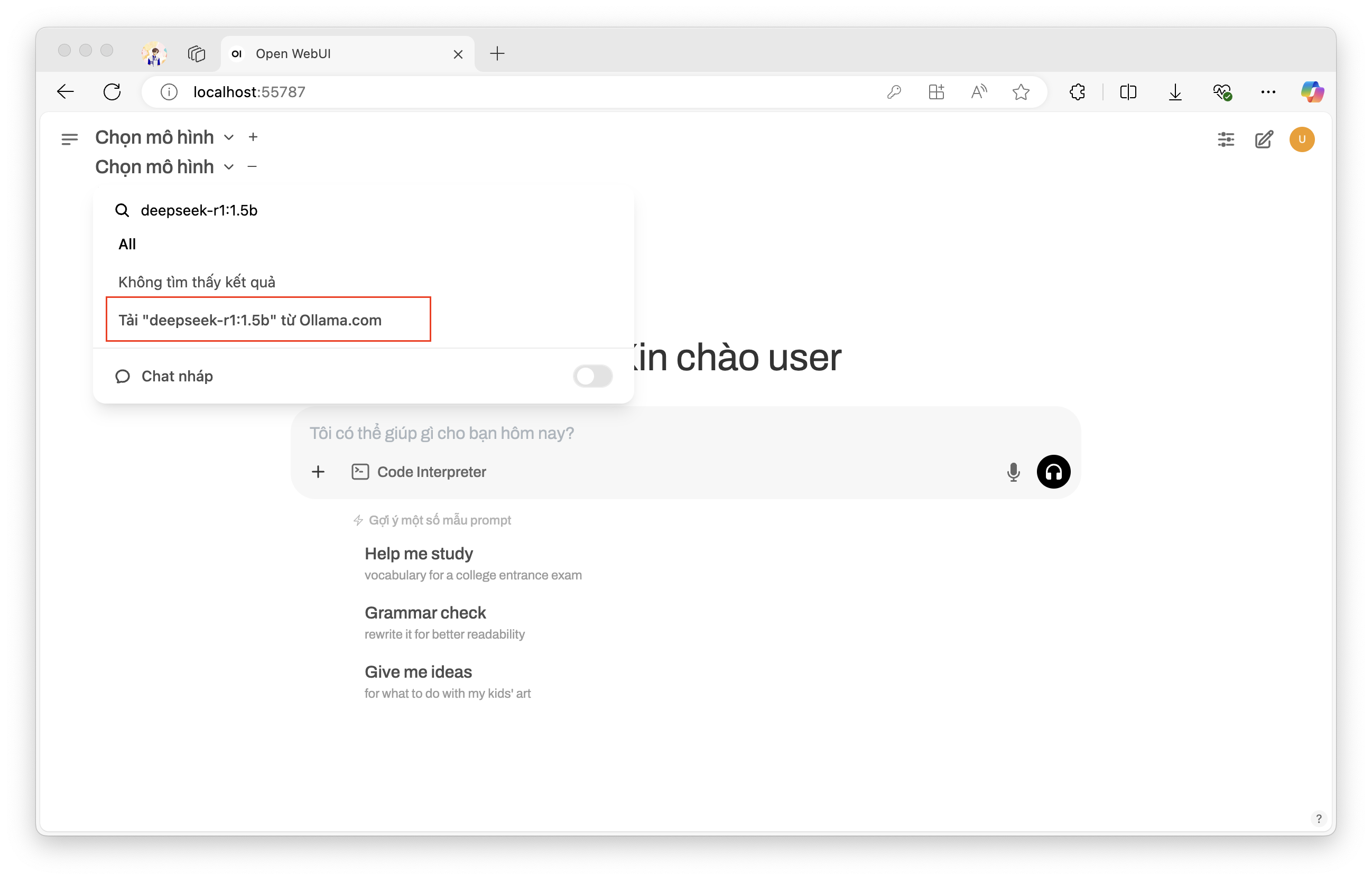

ステップ4: インストールが完了したら、ユーザーは使用するモデルを選択します。例として、DeepSeek-R1 モデル (バージョン 1.5b) をインストールします。

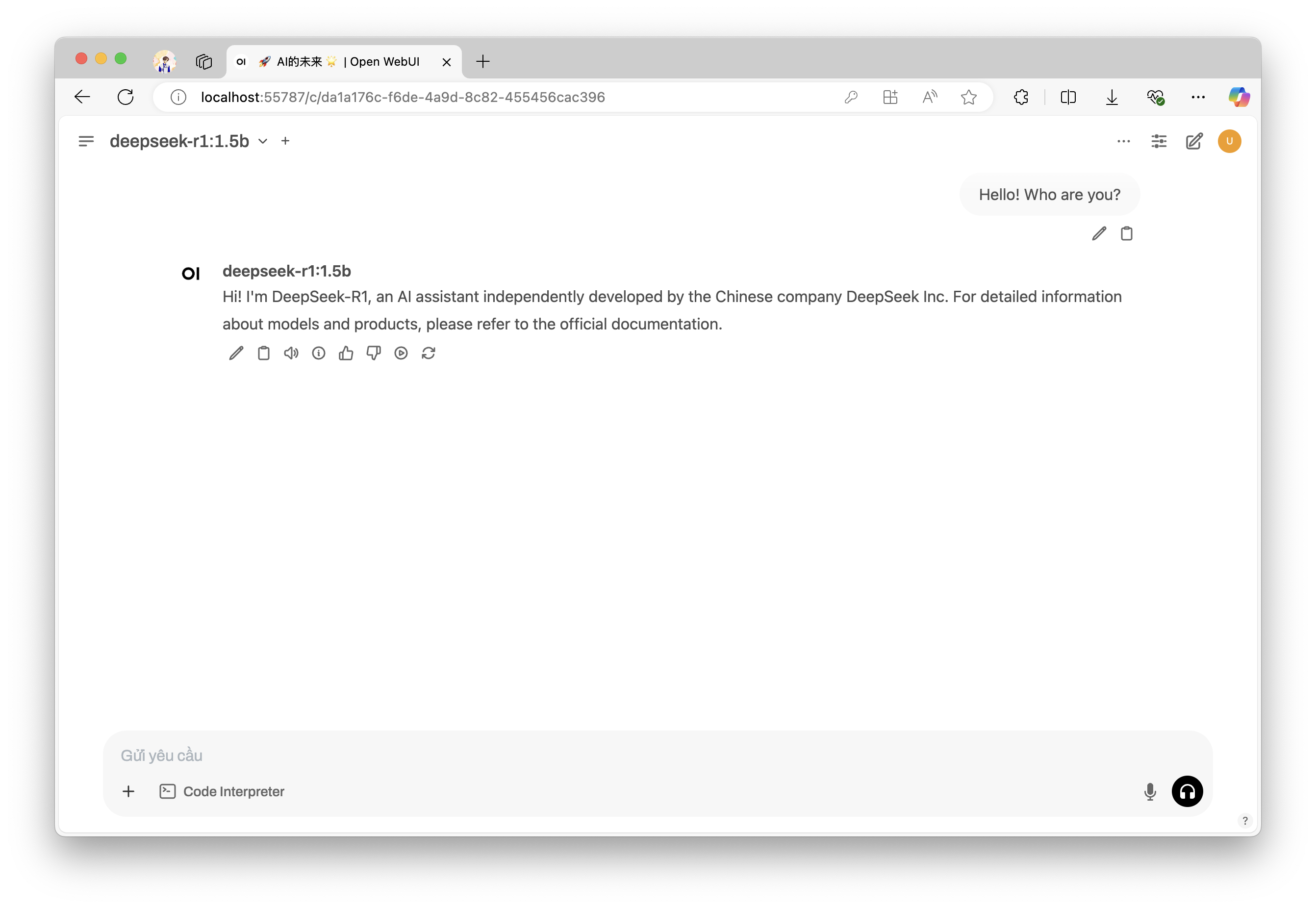

ステップ 5: モデルがダウンロードされて実行されたら、ユーザーはインターフェースでモデルと簡単に対話できます。