AI Factory Playbook: Hướng dẫn Developer phát triển ứng dụng GenAI an toàn và hiệu quả

AI Factory Playbook: Hướng dẫn Developer phát triển ứng dụng GenAI an toàn và hiệu quả

Xem nhanh

Tại NVIDIA AI Day, ông Phạm Vũ Hùng – Solutions Architect & Senior Consultant của FPT Smart Cloud, Tập đoàn FPT đã có bài chia sẻ với chủ đề “AI Factory Playbook: Hướng dẫn Developer phát triển ứng dụng GenAI an toàn và hiệu quả”.

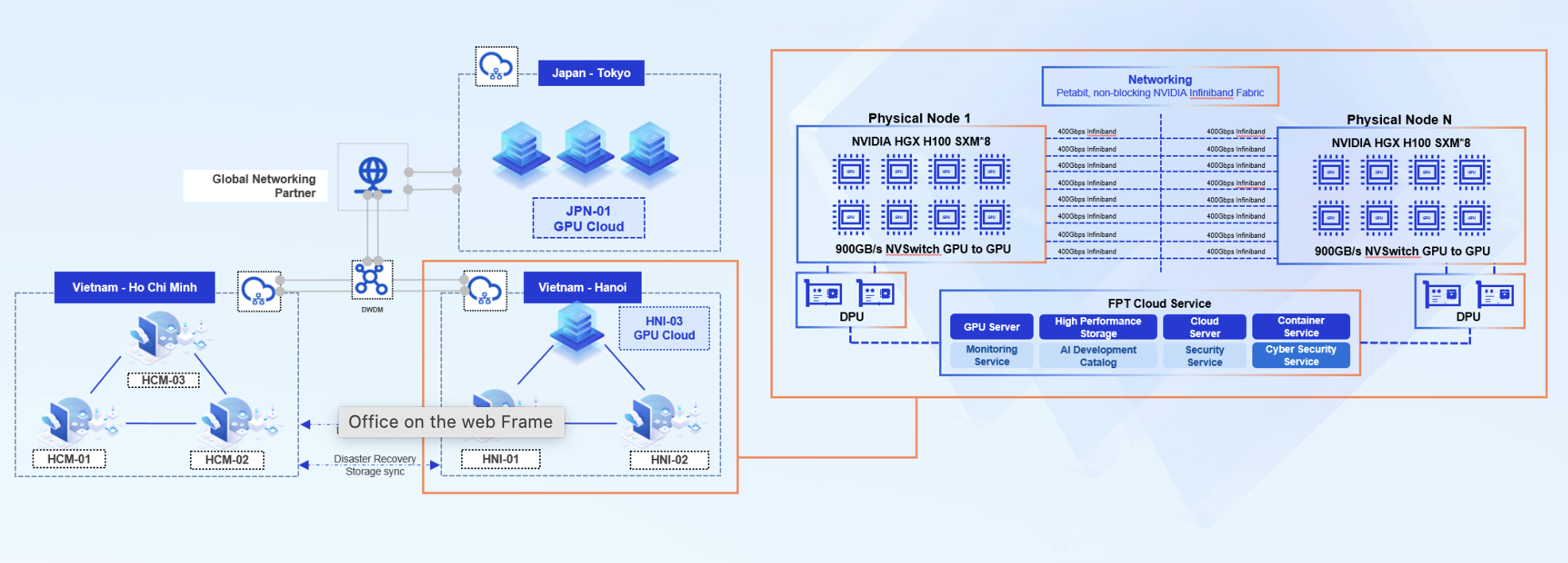

Trong phần trình bày, ông Hùng mang đến góc nhìn về cách hiện thực hóa quy trình phát triển AI toàn trình, bao gồm từ việc xây dựng mô hình Generative AI cho đến triển khai AI Agent trong doanh nghiệp, trên nền tảng GPU Cloud H100/H200 của NVIDIA và hạ tầng AI Factory do FPT phát triển trong nước.

Một vài điểm đáng chú ý trong phần chia sẻ:

- Phát triển AI toàn diện trong môi trường an toàn: quy trình khép kín từ huấn luyện GenAI đến triển khai AI Agent ngay tại data center trong nước.

- Tăng tốc với NVIDIA H100/H200 GPU: rút ngắn đáng kể thời gian training và inference.

- Xây dựng & tinh chỉnh GenAI bằng dữ liệu riêng: tạo ra mô hình chính xác hơn, đáp ứng nhu cầu đặc thù của doanh nghiệp.

Xây dựng AI/ML Stack

- GPU Container: Được thiết kế cho các tác vụ thử nghiệm, đi kèm tính năng giám sát, ghi log và sổ tay cộng tác (collaborative notebooks). Nhà phát triển có thể dễ dàng chia sẻ dữ liệu, viết mã, kiểm thử đơn vị (unit test) và thực thi trong một môi trường linh hoạt cao.

- GPU Virtual Machine: Máy ảo đa năng, tối ưu cho cả huấn luyện và suy luận, với tùy chọn cấu hình linh hoạt (từ 1 đến 8 GPU mỗi VM, dung lượng bộ nhớ GPU lên tới 141GB).

- GPU Cluster: Hạ tầng có khả năng mở rộng, hỗ trợ huấn luyện phân tán và suy luận quy mô lớn. Tích hợp NVLink, công nghệ chia sẻ GPU như MIG/MPS/Time-slice, cùng các tiện ích bảo mật nâng cao như nhật ký kiểm toán (audit logs) và CIS benchmarks.

- AI Notebook: Môi trường JupyterLab được quản lý, cài sẵn các thư viện AI/ML cần thiết. Nhà phát triển có thể bắt tay ngay vào lập trình trên GPU cấp doanh nghiệp mà không mất thời gian thiết lập, đồng thời tiết kiệm chi phí lên tới 70% so với môi trường notebook truyền thống.

- FPT AI Studio: Nền tảng MLOps no-code/low-code, tích hợp pipeline dữ liệu, các chiến lược tinh chỉnh (SFT, DPO, continual training), theo dõi thí nghiệm và quản lý mô hình. Giao diện kéo-thả trực quan cho phép nhà phát triển tinh chỉnh mô hình nhanh chóng và lưu trữ trong kho mô hình tập trung.

- FPT AI Inference: API sẵn sàng sử dụng với mức giá token cạnh tranh, giúp nhà phát triển triển khai mô hình đã tinh chỉnh một cách nhanh chóng và tiết kiệm chi phí.

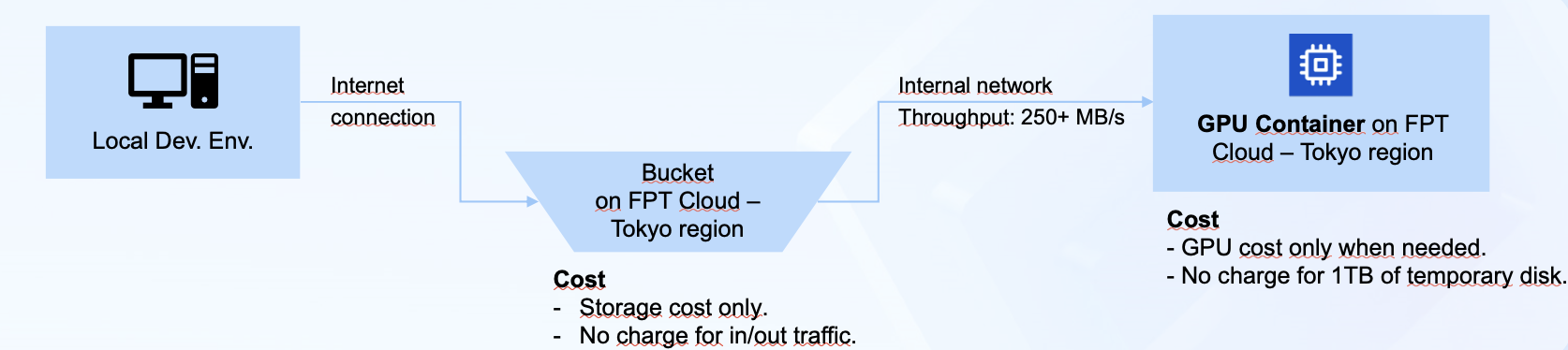

Trong phần trình bày, ông Hùng không chỉ nhấn mạnh những năng lực toàn diện của FPT AI Factory mà còn đưa ra ví dụ cụ thể từ khách hàng. Điển hình, FPT đã hợp tác với một công ty CNTT Nhật Bản để tinh chỉnh mô hình Donut (Document Understanding Transformer) trên bộ dữ liệu hơn 300GB. Bằng cách kết hợp GPU Container cùng FPT Object Storage, khách hàng có thể xử lý hiệu quả khối lượng lớn dữ liệu tài liệu, đồng thời tối ưu chi phí. Đây cũng là một ví dụ thực tiễn cho thấy doanh nghiệp có thể tận dụng hạ tầng của FPT AI Factory để triển khai các tác vụ AI trong thực tế.

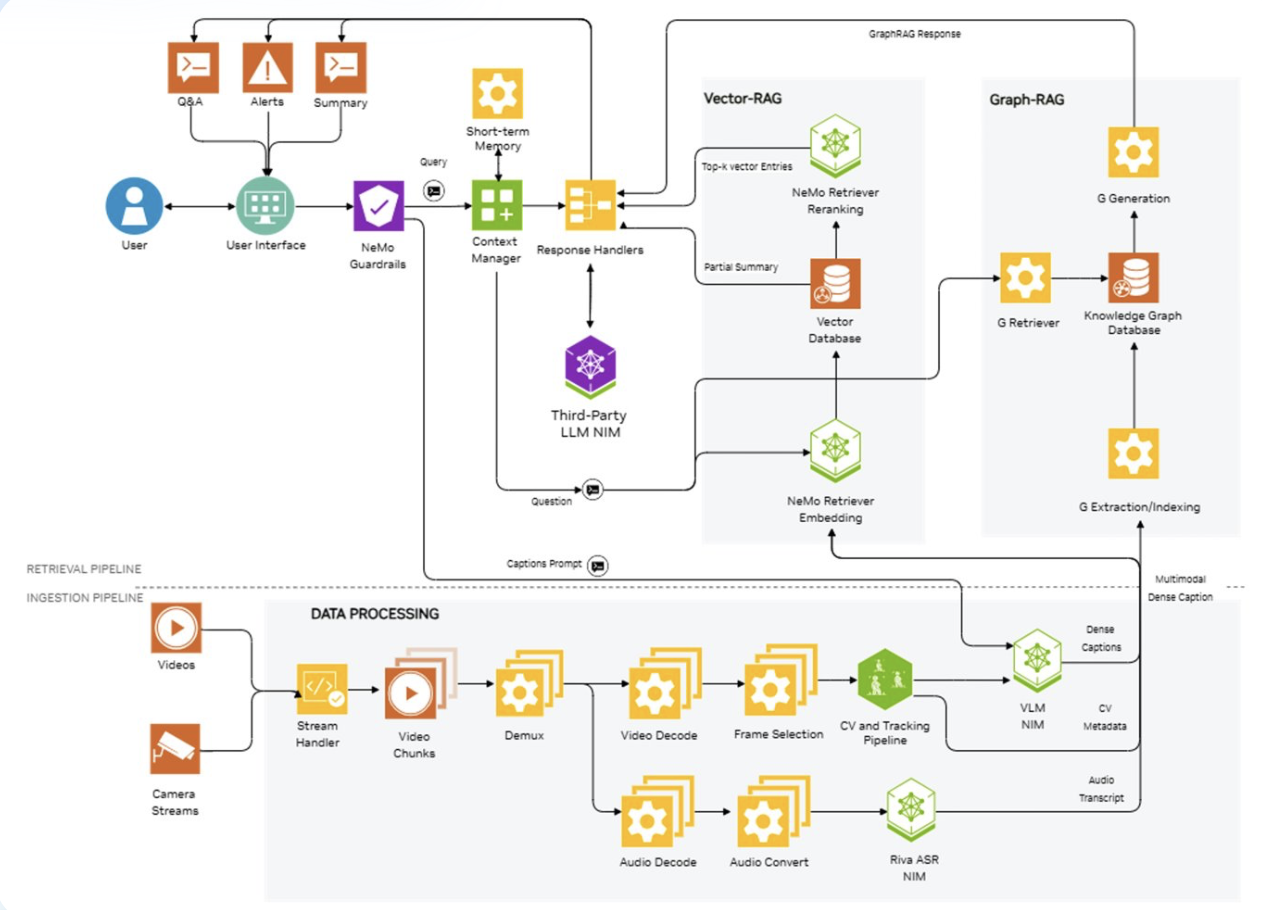

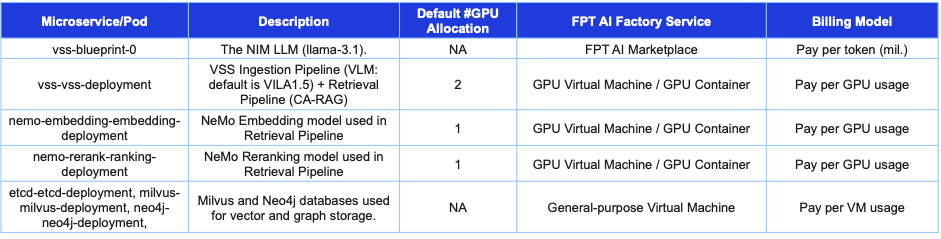

Tăng tốc triển khai giải pháp AI thực tiễn

Một trong những điểm nhấn của sự kiện là phần demo trực tiếp về AI Camera Agent được thiết kế cho bài toán tìm kiếm và tóm tắt nội dung video. Quy trình vận hành đơn giản nhưng mạnh mẽ: chỉ cần chọn một video, nhập mô tả ngắn gọn về nội dung cần tìm, và agent sẽ tự động xác định các đoạn liên quan, đồng thời tạo ra phần tóm tắt súc tích trong thời gian thực.

NVIDIA Blueprints là yếu tố then chốt giúp hiện thực hóa giải pháp này – bộ kiến trúc giải pháp và công cụ đã được kiểm chứng, cho phép thử nghiệm nhanh chóng. Thay vì mất hàng tháng để xây dựng một nguyên mẫu từ đầu, nhóm đã có thể chuyển từ ý tưởng sang bản demo hoạt động chỉ trong một ngày. Sự tăng tốc này không chỉ chứng minh tính khả thi của giải pháp mà còn mang lại cho doanh nghiệp cách nhìn cụ thể về việc AI có thể được áp dụng như thế nào cho các thách thức xử lý dữ liệu video của riêng họ.

Đặc biệt, FPT AI Factory cung cấp môi trường full-stack, bao gồm từ các thành phần hạ tầng như GPU, máy ảo (VM) và Kubernetes đến các công cụ dành cho nhà phát triển, giúp triển khai giải pháp AI một cách nhanh chóng và hiệu quả. Với kiến trúc linh hoạt cùng các mô hình sẵn sàng sử dụng, nhà phát triển thậm chí có thể xây dựng giải pháp hoàn chỉnh chỉ với một NVIDIA H100 GPU, cân bằng giữa hiệu năng, khả năng mở rộng và tối ưu chi phí.

Chẳng hạn, FPT AI Inference cung cấp thư viện mô hình sẵn dùng, cho phép nhà phát triển tích hợp ngay lập tức qua các API đơn giản. Với mức giá token cạnh tranh, đội ngũ phát triển có thể chạy các tác vụ suy luận nhanh hơn trong khi giảm đáng kể chi phí, giúp doanh nghiệp đưa ứng dụng AI ra thị trường một cách hiệu quả hơn.

Tối ưu quy trình tinh chỉnh mô hình AI

Hiện nay, nhà phát triển có thể tinh chỉnh mô hình trực tiếp trên GPU Container, điều này rất phù hợp cho mục đích thử nghiệm và phát triển nhanh. Tuy nhiên, để đưa một giải pháp vào vận hành thực tế, cần hơn cả sức mạnh tính toán - đó là khả năng tự động hóa quy trình tinh chỉnh.

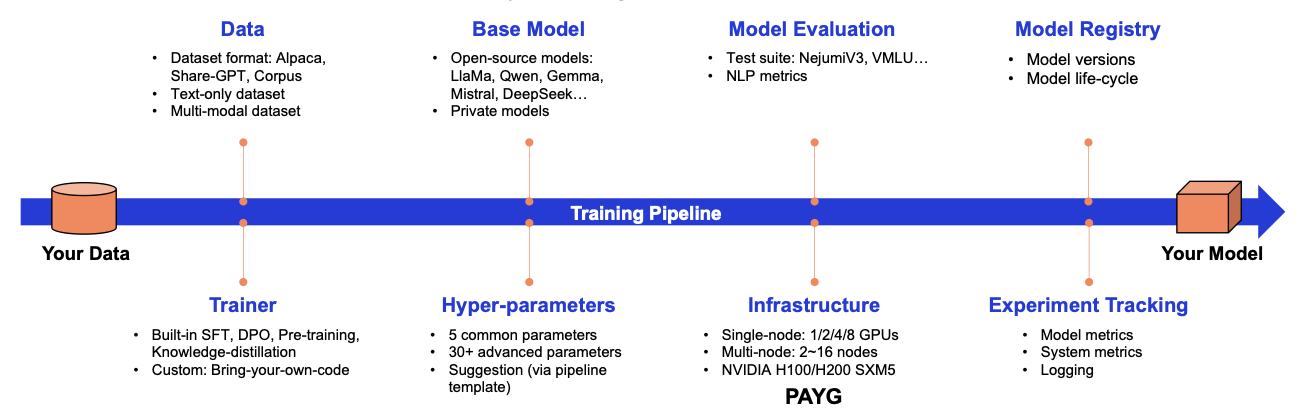

Để đáp ứng nhu cầu này, FPT AI Studio được giới thiệu, tích hợp các thành phần phổ biến trong quy trình MLOps như AI Notebook, xử lý dữ liệu (Data Processing) và nhiều chiến lược tinh chỉnh khác nhau như continual training. FPT AI Studio cho phép người dùng tích hợp dữ liệu, mô hình nền tảng và các chiến lược tinh chỉnh, với giao diện kéo-thả thân thiện, giúp xây dựng workflow nhanh chóng.

Mô hình sau khi được tinh chỉnh có thể được lưu trữ trong Model Hub - một kho trung tâm để quản lý phiên bản, chia sẻ và tái sử dụng. Sau đó, các mô hình này có thể được chuyển ngay sang FPT AI Inference để triển khai với khả năng mở rộng và độ trễ thấp trong môi trường sản xuất.

FPT AI Studio cung cấp môi trường lý tưởng để tối ưu hóa việc tinh chỉnh và triển khai mô hình. Nền tảng này vừa dễ tiếp cận cho người mới, vừa cho phép tùy chỉnh sâu cho người dùng nâng cao. Các thành phần chính của MLOps trên FPT AI Studio bao gồm:

- AI Notebook: môi trường thử nghiệm lập trình dựa trên mã nguồn.

- Các quy trình xử lý dữ liệu: xử lý dữ liệu trước khi huấn luyện và kỹ thuật tạo đặc trưng (feature engineering).

- Chiến lược tinh chỉnh bao gồm huấn luyện liên tục (continual training), thích ứng theo miền (domain adaptation) và học chuyển giao (transfer learning).

Khi một mô hình đã được tinh chỉnh trong FPT AI Studio, nó sẽ được lưu giữ trong Model Hub để dễ dàng quản lý, chia sẻ và sử dụng lại. Từ đây, mô hình có thể được chuyển trực tiếp sang FPT AI Inference, phục vụ với hiệu suất cao và độ trễ thấp trong môi trường sản xuất.

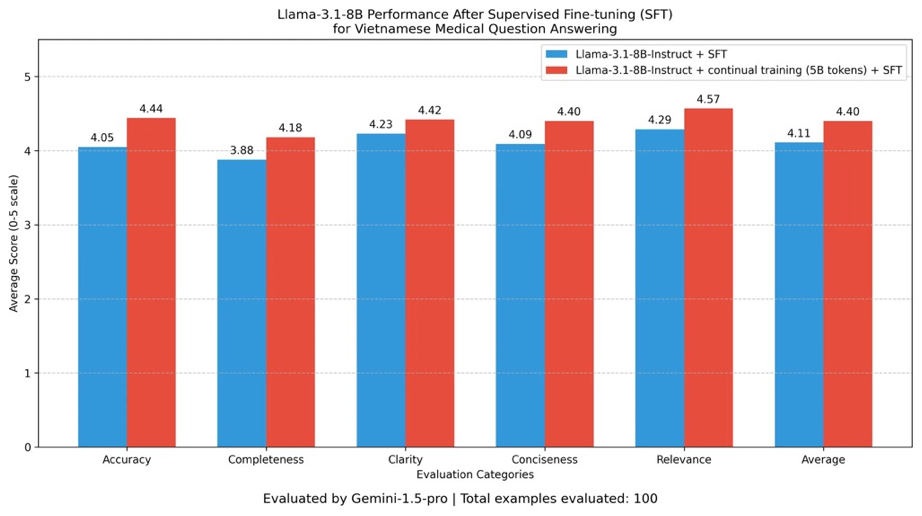

Tại buổi chia sẻ, ông Hùng đã minh họa một câu chuyện thành công về cách FPT AI Studio được ứng dụng để tùy biến một mô hình ngôn ngữ lớn phục vụ lĩnh vực y tế tại Việt Nam. Mô hình gốc được chọn là Llama-3.1-8B, cân bằng tốt giữa khả năng xử lý và hiệu suất. Nhiệm vụ đặt ra là phát triển một mô hình tối ưu cho trả lời câu hỏi y tế, yêu cầu điều chỉnh chuyên sâu theo lĩnh vực nhưng vẫn giữ nguyên năng lực suy luận tổng quát của mô hình gốc. Bộ dữ liệu sử dụng bao gồm các tài liệu y tế tiếng Việt, với mục tiêu nâng cao khả năng nhớ chính xác thông tin, độ chuyên sâu về lĩnh vực, và chất lượng phản hồi trong các tình huống hỏi đáp lâm sàng.

Cách tiếp cận thứ nhất dựa trên việc huấn luyện liên tục (continual pre-training). Sử dụng 24 NVIDIA H100 GPU trên 3 node, mô hình được huấn luyện trên bộ dữ liệu y tế qua 3 epoch, toàn bộ quy trình mất khoảng 31 giờ để hoàn tất.

Cách tiếp cận thứ hai áp dụng tinh chỉnh có giám sát với LoRA adapters, là giải pháp tiết kiệm tài nguyên hơn. Trong phương án này, chỉ sử dụng 4 NVIDIA H100 GPU trên một node, huấn luyện qua 5 epoch, với thời gian tổng cộng khoảng 3 giờ. Mặc dù yêu cầu tính toán thấp hơn, phương pháp này vẫn mang lại cải thiện đáng kể cho các tác vụ hỏi đáp chuyên ngành.

Gợi ý triển khai hiệu quả

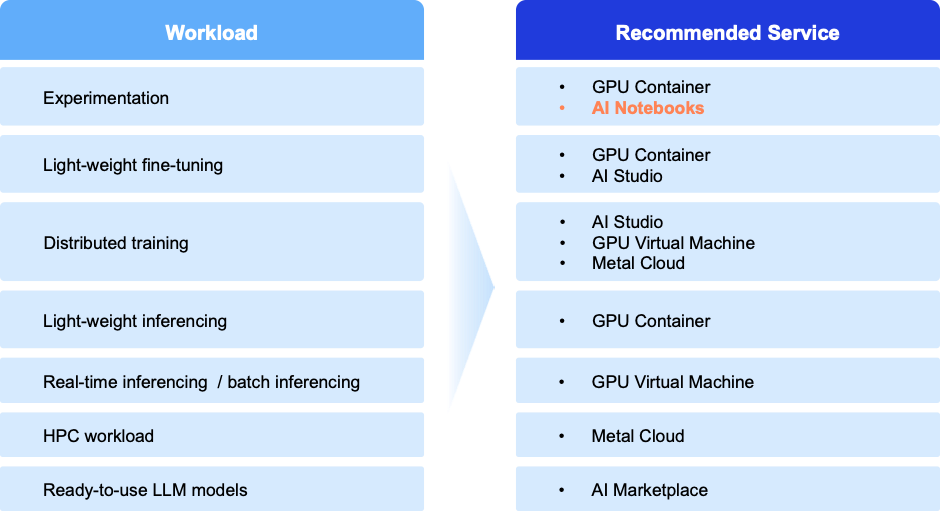

Trước tiên, điều quan trọng là lựa chọn công cụ phù hợp cho từng loại khối lượng công việc nhằm tối đa hóa cả hiệu suất lẫn hiệu quả chi phí. Với FPT AI Factory, người dùng được trang bị đầy đủ công cụ cần thiết cho mọi loại khối lượng công việc AI/ML, giúp thúc đẩy đổi mới AI nhanh hơn và hiệu quả hơn.

- Đối với giai đoạn thử nghiệm ban đầu, GPU Container hoặc AI Notebook cung cấp môi trường linh hoạt cho các nhà phát triển thử nghiệm ý tưởng và chạy nguyên mẫu nhanh.

- Khi triển khai, lựa chọn phù hợp phụ thuộc vào khối lượng công việc: GPU Container lý tưởng cho việc suy luận nhẹ, trong khi GPU Virtual Machine mang lại hiệu suất cần thiết cho suy luận thời gian thực hoặc xử lý theo lô.

- Các khối lượng công việc tính toán hiệu năng cao (HPC) đạt hiệu quả tối ưu trên Metal Cloud, cung cấp hiệu suất bare metal cho các tác vụ yêu cầu cao.

- Cuối cùng, các tổ chức muốn sử dụng mô hình sẵn sàng có thể truy cập AI Marketplace, nơi cung cấp các LLM đã được huấn luyện sẵn và dịch vụ hỗ trợ để tăng tốc quá trình áp dụng mà không cần tinh chỉnh thêm.

Thứ hai, các nhà phát triển cần tối ưu hóa khối lượng công việc huấn luyện. Việc tối ưu huấn luyện các mô hình AI sinh tạo lớn đòi hỏi kết hợp giữa kỹ thuật tận dụng phần cứng và thiết kế quy trình làm việc. Một phương pháp quan trọng là sử dụng huấn luyện chính xác hỗn hợp (mixed-precision training), áp dụng các định dạng như FP16 hoặc BF16 để tăng tốc tính toán trên NVIDIA GPU đồng thời giảm tới 50% bộ nhớ sử dụng. Điều này không chỉ rút ngắn thời gian huấn luyện mà còn duy trì độ chính xác với khả năng tự động mở rộng.

Huấn luyện phân tán cũng rất quan trọng, với các chiến lược như PyTorch DDP hoặc pipeline parallelism giúp mở rộng khối lượng công việc trên nhiều GPU hoặc node, cải thiện thông lượng và rút ngắn chu kỳ phát triển. Trong môi trường đa node, tối ưu kết nối cluster bằng NVLink hoặc InfiniBand có thể tăng tốc huấn luyện lên tới 3 lần, đảm bảo đồng bộ hiệu quả cho các tác vụ AI quy mô lớn. Quy trình dữ liệu và lưu trữ cũng cần được tối ưu, sử dụng NVIDIA DALI và khả năng I/O mở rộng để tránh nghẽn cổ chai. Cuối cùng, các công cụ đối chuẩn như kiểm thử hiệu suất GPU của FPT AI Factory và kết quả MLPerf của NVIDIA giúp xác thực cấu hình, đảm bảo mở rộng hiệu quả về chi phí cho quá trình tinh chỉnh.

Thứ ba, cần tối ưu hóa khối lượng công việc suy luận (inference) để cung cấp dịch vụ AI tạo sinh có khả năng mở rộng và độ trễ thấp. Một phương pháp hiệu quả là lượng tử hóa (quantization) và sử dụng độ chính xác thấp hơn với NVIDIA TensorRT, chuyển đổi mô hình sang FP8 hoặc INT8 để tăng thông lượng tới 1,4 lần với ít ảnh hưởng tới độ chính xác. Đối với các mô hình ngôn ngữ lớn, quản lý bộ nhớ KV cache hiệu quả cũng rất quan trọng; các kỹ thuật như PagedAttention và chunked prefill giúp giảm phân mảnh bộ nhớ và rút ngắn thời gian tạo token đầu tiên tới 2–5 lần trong môi trường nhiều người dùng.

Speculative decoding cải thiện hiệu suất bằng cách kết hợp một mô hình nháp nhỏ với mô hình chính để dự đoán nhiều token cùng lúc, mang lại thông lượng tăng 1,9–3,6 lần, đồng thời giảm độ trễ, đặc biệt hữu ích trong ứng dụng thời gian thực như tóm tắt video. Mở rộng với multi-GPU parallelism cũng đóng vai trò then chốt, giúp tăng tới 1,5 lần hiệu suất trong các tác vụ tinh chỉnh phân tán ở cluster khối lượng lớn. Cuối cùng, model distillation và pruning giúp thu gọn mô hình, giảm chi phí và độ trễ 20 - 30% mà không làm giảm chất lượng đầu ra.

Điểm nhấn chính

- Kiến trúc quy trình AI toàn diện và bảo mật: Phân tích kiến trúc của một “AI factory” trong thực tế, tập trung vào nguyên tắc thiết kế để xây dựng vòng đời phát triển an toàn trong trung tâm dữ liệu nội bộ. Khán giả sẽ nắm rõ các bước kỹ thuật để đảm bảo cách ly dữ liệu, quản lý hosting mô hình an toàn, và thiết lập lộ trình từ tinh chỉnh tới triển khai AI agent đạt chuẩn doanh nghiệp.

- Kỹ thuật thực tiễn cho vận hành LLM tăng tốc GPU: Vượt ra ngoài thông số kỹ thuật, học cách tận dụng GPU hiệu năng cao (như NVIDIA H100/H200) một cách thực tế. Phiên chia sẻ này trình bày các phương pháp tối ưu cụ thể cho cả huấn luyện và tinh chỉnh, nhằm tối đa hóa thông lượng, giảm độ trễ, và rút ngắn chu kỳ phát triển cho các ứng dụng AI sinh tạo có yêu cầu cao.