FPT AI Factory: BỘ GIẢI PHÁP AI mạnh mẽ với siêu chip NVIDIA H100 và H200

FPT AI Factory: BỘ GIẢI PHÁP AI mạnh mẽ với siêu chip NVIDIA H100 và H200

Xem nhanh

Trong thời đại trí tuệ nhân tạo (AI) đang bùng nổ, Việt Nam ghi dấu ấn mạnh mẽ trên bản đồ công nghệ toàn cầu thông qua sự hợp tác chiến lược giữa Tập đoàn FPT và NVIDIA – nhà cung cấp giải pháp điện toán hiệu năng cao hàng đầu thế giới để phát triển giải pháp FPT AI Factory, một hệ sinh thái AI toàn diện dành cho doanh nghiệp, được phát triển trên nền tảng siêu chip NVIDIA H100 và NVIDIA H200, hiện đại bậc nhất thế giới trong công nghệ chip trí tuệ nhân tạo.

Video: Ông Trương Gia Bình (Chủ tịch Tập đoàn FPT) chia sẻ hợp tác chiến lược với NVIDIA trong việc phát triển các ứng dụng AI toàn diện cho doanh nghiệp

Theo Báo Chính Phủ (2024), ông Trương Gia Bình – Chủ tịch Hội đồng Quản trị kiêm Nhà sáng lập Tập đoàn FPT – nhấn mạnh rằng FPT đang hướng đến mục tiêu nâng cao năng lực nghiên cứu và phát triển công nghệ, đồng thời xây dựng một hệ sinh thái toàn diện các sản phẩm và dịch vụ tiên tiến, dựa trên nền tảng AI và Cloud. Hệ sinh thái này bao gồm từ hạ tầng công nghệ hiện đại, đội ngũ chuyên gia hàng đầu, đến năng lực hiểu biết sâu sắc về từng lĩnh vực chuyên môn. "Chúng tôi cam kết đưa Việt Nam trở thành Trung tâm phát triển AI của thế giới".

1. Tổng quan về hai siêu chip NVIDIA H100 & H200: Bước Tiến Mới Trong Điện Toán AI

1.1 Thông tin về Chip NVIDIA H100 (GPU NVIDIA H100 Tensor Core)

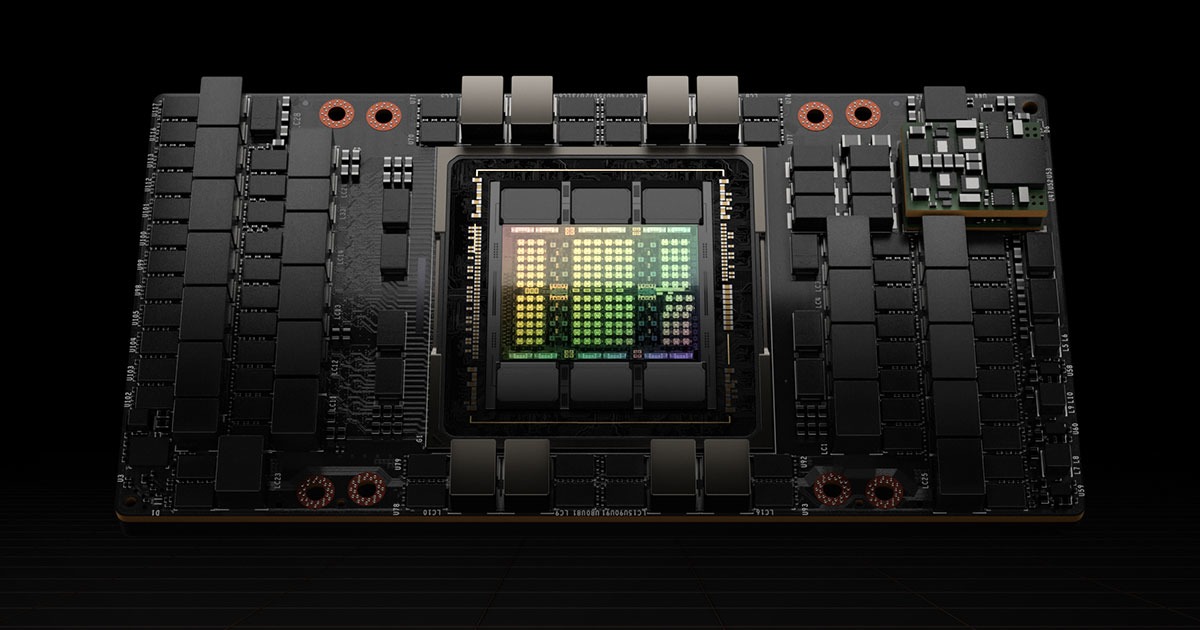

NVIDIA H100 Tensor Core GPU là một kiến trúc đột phá, được xây dựng trên nền tảng Kiến trúc Hopper™ (kiến trúc bộ xử lý đồ họa GPU do Nvidia phát triển). Đây không chỉ là một con chip xử lý đồ họa thông thường, mà là một cỗ máy được tối ưu hóa đặc biệt cho Học sâu (Deep Learning) và các ứng dụng Trí tuệ nhân tạo (Artificial Intelligence).

Siêu chip NVIDIA H100 được chế tạo bằng quy trình TSMC N4 tiên tiến, tích hợp đến 80 tỷ bóng bán dẫn. Sức mạnh xử lý của nó đến từ việc trang bị tối đa 144 bộ xử lý đa luồng (SMs - Streaming Multiprocessors), được thiết kế để xử lý các tác vụ AI phức tạp. Điểm đặc biệt là NVIDIA Hopper H100 có thể phát huy hiệu suất tối ưu khi sử dụng ổ cắm SXM5. Nhờ băng thông bộ nhớ tăng cường mà chuẩn SXM5 cung cấp, H100 mang lại hiệu năng vượt trội hơn đáng kể so với khi được triển khai qua các ổ cắm PCIe thông thường, đặc biệt quan trọng cho các ứng dụng của các doanh nghiệp đòi hỏi lượng dữ liệu lớn và tốc độ xử lý cao trong AI.

NVIDIA đã tạo ra hai phiên bản đóng gói khác nhau về yếu tố hình thức (form factor) từ chip H100 là: H100 SXM và H100 NVL nhằm đáp ứng nhu cầu của các doanh nghiệp hiện nay trên thị trường, cụ thể về ứng dụng của hai sản phẩm này:

- Phiên bản H100 SXM: Dành cho các hệ thống chuyên dụng, siêu máy tính, hoặc các trung tâm dữ liệu AI lớn muốn khai thác toàn bộ tiềm năng của GPU với khả năng mở rộng NVLink tối đa. Đây là lựa chọn lý tưởng cho các tác vụ như: huấn luyện mô hình AI lớn (LLMs, Transformer), ứng dụng HPC kết hợp AI, hoặc mô phỏng khoa học, y sinh và tài chính ở cấp độ exascale.

- Phiên bản H100 NVL: Phiên bản này tối ưu cho các máy chủ tiêu chuẩn, dễ dàng tích hợp vào hạ tầng hiện có với chi phí và độ phức tạp thấp hợp so với hệ thống SX chuyên biệt, phù hợp với các doanh nghiệp cần triển khai suy luận AI thời gian thực, xử lý dữ liệu lớn, NLP, thị giác máy tính, hoặc các ứng dụng AI trong môi trường hybrid cloud.

| Thông số kỹ thuật | H100 SXM | H100 NVL |

| FP64 | 34 teraFLOPS | 30 teraFLOP |

| Lõi Tensor FP64 (FP64 Tensor Core) | 67 teraFLOPS | 60 teraFLOP |

| FP32 | 67 teraFLOPS | 60 teraFLOP |

| Lõi Tensor TF32 * (TF32 Tensor Core*) | 989 teraFLOPS | 835 teraFLOP |

| Lõi Tensor BFLOAT16 * (BFLOAT16 Tensor Core*) | 1.979 teraFLOPS | 1.671 teraFLOPS |

| Lõi Tensor FP16 * (FP16 Tensor Core*) | 1.979 teraFLOPS | 1.671 teraFLOPS |

| Lõi Tensor FP8 * (FP8 Tensor Core*) | 3.958 teraFLOPS | 3.341 teraFLOPS |

| Lõi Tensor INT8 * (INT8 Tensor Core*) | 3.958 TOPS | 3.341 TOPS |

| Bộ nhớ GPU (GPU Memory) | 80GB | 94GB |

| Băng thông bộ nhớ GPU (GPU Memory Bandwidth) | 3,35TB/giây | 3,9TB/giây |

| Bộ giải mã (Decoders) | 7 NVDEC

7 JPEG |

7 NVDEC

7 JPEG |

| Công suất thiết kế nhiệt tối đa (TDP) | Lên đến 700W (có thể cấu hình) | 350 - 400W (có thể cấu hình) |

| GPU đa phiên bản (Multi-Instance GPUs) | Tối đa 7 MIGS @ 10GB mỗi MIGS | Tối đa 7 MIGS @ 12GB mỗi MIGS |

| Yếu tố hình thức (Form Factor) | SXM | PCIe

khe cắm kép làm mát bằng không khí |

| Kết nối (Interconnect) | NVIDIA NVLink™: 900GB/giây

PCIe Gen5: 128GB/giây |

NVIDIA NVLink: 600GB/giây

PCIe Gen5: 128GB/giây |

| Tùy chọn máy chủ (Server Options) | Đối tác NVIDIA HGX H100 và NVIDIA - Certified Systems ™ với 4 hoặc 8 GPU

NVIDIA DGX H100 với 8 GPU |

Đối tác và Hệ thống được NVIDIA chứng nhận với 1 – 8 GPU |

| NVIDIA AI Doanh nghiệp (NVIDIA AI Enterprise) | Bổ sung | Đã bao gồm |

Bảng 1.1: Bảng thông số kỹ thuật của hai form factors chip H100: H100 SXM và H100 NVL

1.2 Thông tin về Chip NVIDIA H200 (GPU NVIDIA H200 Tensor Core)

Kế thừa và phát triển từ kiến trúc Hopper™, NVIDIA H200 Tensor Core GPU là phiên bản nâng cấp mạnh mẽ của H100, được NVIDIA giới thiệu là chip AI mạnh nhất thế giới với khả năng cho ra kết quả nhanh gấp đôi H100, tại thời điểm công bố vào tháng 11 2023. H200 được thiết kế để xử lý các mô hình AI lớn hơn và phức tạp hơn nữa, đặc biệt là các mô hình AI tạo sinh và mô hình ngôn ngữ lớn (LLMs).

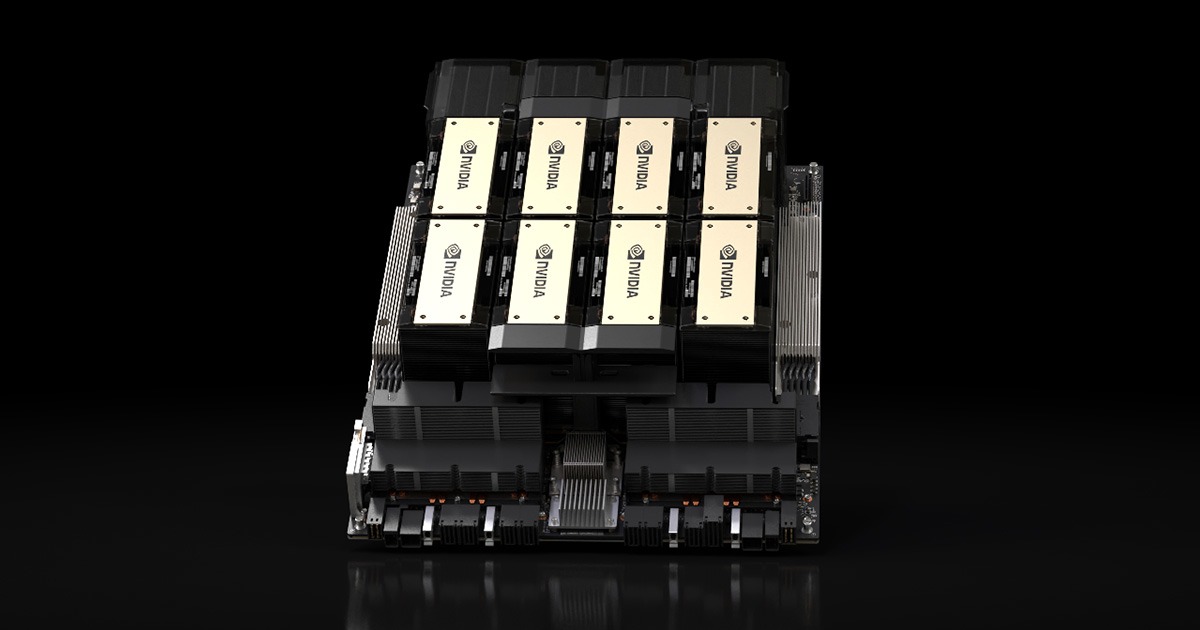

Tương tự như superchip H100, NVIDIA cũng cung cấp hai form factors khác nhau cho sản phẩm H200 Tensor Core của mình là hai phiên bản dành cho doanh nghiệp: H200 SXM và H200 NVL.

- NVIDIA H200 SXM: Được thiết kế để đẩy mạnh các tác vụ AI tạo sinh và điện toán hiệu năng cao (HPC), đặc biệt với khả năng xử lý lượng dữ liệu khổng lồ. Đây là lựa chọn lý tưởng cho các hệ thống chuyên dụng, siêu máy tính và các trung tâm dữ liệu AI lớn muốn khai thác toàn bộ tiềm năng của GPU với khả năng mở rộng NVLink tối đa. Doanh nghiệp nên sử dụng H200 SXM cho các trường hợp: huấn luyện các mô hình AI cực lớn, Ứng dụng HPC đòi hỏi nhiều bộ nhớ và triển khai AI tạo sinh (Generative AI) cấp độ doanh nghiệp.

- NVIDIA H200 NVL: Được tối ưu hóa để đưa khả năng tăng tốc AI vào các máy chủ doanh nghiệp tiêu chuẩn, dễ dàng tích hợp vào hạ tầng hiện có. Phiên bản này đặc biệt phù hợp với các doanh nghiệp có giới hạn về không gian và cần các thiết kế tủ rack tản nhiệt bằng không khí với cấu hình linh hoạt, mang lại khả năng tăng tốc cho mọi khối lượng công việc AI và HPC bất kể quy mô. Các trường ứng dụng H200 NVL trong doanh nghiệp: suy luận AI thời gian thực, triển khai AI trong môi trường hybrid cloud, xử lý dữ liệu lớn và NLP (Xử lý ngôn ngữ tự nhiên).

| Thông số kỹ thuật | H200 SXM | H200 NVL |

| FP64 | 34 TFLOPS | 30 TFLOPS |

| Lõi Tensor FP64 (FP64 Tensor Core) | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 TFLOPS | 60 TFLOPS |

| Lõi Tensor TF32² (TF32 Tensor Core²) | 989 TFLOPS | 835 TFLOPS |

| Lõi Tensor BFLOAT16² (BFLOAT16 Tensor Core²) | 1.979 TFLOPS | 1.671 TFLOPS |

| Lõi Tensor FP16² (FP16 Tensor Core²) | 1.979 TFLOPS | 1.671 TFLOPS |

| Lõi Tensor FP8² (FP8 Tensor Core²) | 3.958 TFLOPS | 3.341 TFLOPS |

| Lõi Tensor INT8² (INT8 Tensor Core²) | 3.958 TFLOPS | 3.341 TFLOPS |

| Bộ nhớ GPU (GPU Memory) | 141GB | 141GB |

| Băng thông bộ nhớ GPU (GPU Memory Bandwidth) | 4,8TB/giây | 4,8TB/giây |

| Bộ giải mã (Decoders) | 7 NVDEC

7 JPEG |

7 NVDEC

7 JPEG |

| Điện toán bảo mật (Confidential Computing) | Được hỗ trợ | Được hỗ trợ |

| Công suất thiết kế nhiệt tối đa (TDP) | Lên đến 700W (có thể cấu hình) | Lên đến 600W (có thể cấu hình) |

| GPU đa phiên bản (Multi-Instance GPUs) | Tối đa 7 MIG @18GB mỗi MIG | Tối đa 7 MIG @16,5 GB mỗi MIG |

| Yếu tố hình thức (Form Factor) | SXM | PCIe

làm mát bằng không khí khe cắm kép |

| Kết nối (Interconnect) | NVIDIA NVLink™: 900GB/giây

PCIe Gen5: 128GB/giây |

Cầu nối NVIDIA NVLink 2 hoặc 4 chiều: 900GB/giây cho mỗi GPU

PCIe Gen5: 128GB/giây |

| Tùy chọn máy chủ (Server Options) | Đối tác NVIDIA HGX™ H200 và NVIDIA-Certified Systems™ với 4 hoặc 8 GPU | Đối tác NVIDIA MGX™ H200 NVL và Hệ thống được chứng nhận NVIDIA với tối đa 8 GPU |

| NVIDIA AI Doanh nghiệp (NVIDIA AI Enterprise) | Bổ sung | Đã bao gồm |

Bảng 1.2: Bảng thông số kỹ thuật của hai form là H200 SXM và H200 NVL

1.3 So sánh chi tiết giữa hai siêu chip NVIDIA H100 và NVIDIA H200

Dựa trên thông tin về hai sản phẩm NVIDIA H100 (H100 SXM - H100 NVL) và H200 (H200 SXM - H200 NVL) mà FPT Cloud đã cung cấp, đây là bảng so sánh chi tiết giữa NVIDIA H100 & H200 mà bạn có thể tham khảo:

| Đặc điểm | NVIDIA H100 (SXM) | NVIDIA H100 (NVL) | NVIDIA H200 (SXM) | NVIDIA H200 (NVL) |

| Kiến trúc (Architecture) | Hopper™ | Hopper™ | Kế thừa và phát triển từ Hopper™ | Kế thừa và phát triển từ Hopper™ |

| Quy trình chế tạo (Manufacturing Process) | TSMC N4 (tích hợp 80 tỷ bóng bán dẫn) | TSMC N4 (tích hợp 80 tỷ bóng bán dẫn) | Phiên bản nâng cấp từ H100 | Phiên bản nâng cấp từ H100 |

| FP64 | 34 teraFLOPS | 30 teraFLOP | 34 TFLOPS | 30 TFLOPS |

| Lõi Tensor FP64 (FP64 Tensor Core) | 67 teraFLOPS | 60 teraFLOP | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 teraFLOPS | 60 teraFLOP | 67 TFLOPS | 60 TFLOPS |

| Lõi Tensor TF32 (TF32 Tensor Core) | 989 teraFLOPS | 835 teraFLOP | 989 TFLOPS | 835 TFLOPS |

| Lõi Tensor BFLOAT16 (BFLOAT16 Tensor Core) | 1.979 teraFLOPS | 1.671 teraFLOPS | 1.979 TFLOPS | 1.671 TFLOPS |

| Lõi Tensor FP16 (FP16 Tensor Core) | 1.979 teraFLOPS | 1.671 teraFLOPS | 1.979 TFLOPS | 1.671 TFLOPS |

| Lõi Tensor FP8 (FP8 Tensor Core) | 3.958 teraFLOPS | 3.341 teraFLOPS | 3.958 TFLOPS | 3.341 TFLOPS |

| Lõi Tensor INT8 (INT8 Tensor Core) | 3.958 TFLOPS | 3.341 TFLOPS | 3.958 TFLOPS | 3.341 TFLOPS |

| Bộ nhớ GPU (GPU Memory) | 80GB | 94GB | 141GB | 141GB |

| Băng thông bộ nhớ GPU (GPU Memory Bandwidth) | 3.35TB/giây | 3.9TB/giây | 4.8TB/giây | 4.8TB/giây |

| Bộ giải mã (Decoders) | 7 NVDEC, 7 JPEG | 7 NVDEC, 7 JPEG | 7 NVDEC, 7 JPEG | 7 NVDEC, 7 JPEG |

| Điện toán bảo mật (Confidential Computing) | Không có thông tin về Confidential Computing | Không có thông tin về Confidential Computing | Được hỗ trợ | Được hỗ trợ |

| TDP tối đa (Max Thermal Design Power - TDP) | Lên đến 700W (có thể cấu hình) | 350 - 400W (có thể cấu hình) | Lên đến 700W (có thể cấu hình) | Lên đến 600W (có thể cấu hình) |

| GPU đa phiên bản (MIG) | Tối đa 7 MIGs @ 10GB mỗi MIGs | Tối đa 7 MIGs @ 12GB mỗi MIGs | Tối đa 7 MIG @18GB mỗi MIG | Tối đa 7 MIG @16.5 GB mỗi MIG |

| Yếu tố hình thức (Form Factor) | SXM | PCIe, khe cắm kép làm mát bằng không khí | SXM | PCIe, khe cắm kép làm mát bằng không khí |

| Kết nối (Interconnect) | NVIDIA NVLink™: 900GB/giây; PCIe Gen5: 128GB/giây | NVIDIA NVLink: 600GB/giây; PCIe Gen5: 128GB/giây | NVIDIA NVLink™: 900GB/giây; PCIe Gen5: 128GB/giây | Cầu nối NVIDIA NVLink 2 hoặc 4 chiều: 900GB/giây cho mỗi GPU; PCIe Gen5: 128GB/giây |

| Tùy chọn máy chủ (Server Options) | Đối tác NVIDIA HGX H100 và NVIDIA-Certified Systems™ với 4 hoặc 8 GPU; NVIDIA DGX H100 với 8 GPU | Đối tác và Hệ thống được NVIDIA chứng nhận với 1–8 GPU | Đối tác NVIDIA HGX™ H200 và NVIDIA-Certified Systems™ với 4 hoặc 8 GPU | Đối tác NVIDIA MGX™ H200 NVL và Hệ thống được chứng nhận NVIDIA với tối đa 8 GPU |

| NVIDIA AI Enterprise | Bổ sung | Đã bao gồm | Bổ sung | Đã bao gồm |

Bảng 1.3: So sánh chi tiết giữa NVIDIA H100 (SXM - NVL) và NVIDIA H200 (SXM - NVL)

2. FPT hợp tác chiến lược cùng NVIDIA trong việc xây dựng các giải pháp FPT AI Factory đầu tiên tại Việt Nam

Sự kết hợp mang tầm chiến lược của công ty công nghệ hàng đầu NVIDIA và kinh nghiệm triển khai giải pháp cho các doanh nghiệp của FPT đã tạo nên một sức mạnh cộng hưởng trong việc phát triển các sản phẩm AI, tiên phong tại thị trường Việt Nam. NVIDIA không chỉ cung cấp các siêu chip GPU NVIDIA H100 và H200 mà còn chia sẻ những kiến thức chuyên sâu về kiến trúc AI. Đối với Tập đoàn FPT, FPT Smart Cloud – sẽ là đơn vị tiên phong cung cấp các dịch vụ điện toán đám mây (cloud computing) được xây dựng trên nền tảng của nhà máy AI này, giúp các doanh nghiệp Việt Nam dễ dàng tiếp cận và khai thác sức mạnh của AI.

Đặc biệt, FPT sẽ tập trung vào việc phát triển các mô hình AI tạo sinh (Generative AI Models), mang đến khả năng sáng tạo nội dung, tự động hóa quy trình và giải quyết các bài toán phức tạp mà trước đây khó có thể thực hiện.

Trong thời đại của các công nghệ trí tuệ nhân tạo AI, các doanh nghiệp B2B thuộc mọi lĩnh vực như: Tài chính, Chứng khoán, Bảo hiểm, đến Sản xuất và Giáo dục… đều đứng trước nhu cầu cấp thiết về một đối tác tin cậy để bứt phá chuyển đổi số. FPT AI Factory của FPT Cloud chính là giải pháp tối ưu, mang đến những lợi thế vượt trội sau cho doanh nghiệp của bạn:

- Cơ sở hạ tầng AI hàng đầu: Với việc sử dụng trực tiếp các siêu chip NVIDIA H100 và H200, FPT AI Factory mang đến một nền tảng điện toán AI mạnh mẽ bậc nhất, đảm bảo hiệu suất và tốc độ vượt trội cho mọi tác vụ AI.

- Hệ sinh thái dịch vụ đa dạng: FPT AI Factory không chỉ là phần cứng, mà là một hệ sinh thái toàn diện, được thiết kế để hỗ trợ doanh nghiệp từ khâu xây dựng, huấn luyện đến vận hành các giải pháp AI.

- Tối ưu chi phí: Thay vì đầu tư hàng triệu đô la vào cơ sở hạ tầng AI phức tạp, các doanh nghiệp có thể tận dụng FPT AI Factory dưới dạng dịch vụ đám mây, giúp tối ưu hóa chi phí đầu tư ban đầu và chi phí vận hành.

- Bảo mật, tuân thủ và tích hợp: FPT cam kết mang đến một môi trường AI an toàn, tuân thủ các tiêu chuẩn bảo mật quốc tế, đồng thời dễ dàng tích hợp với các hệ thống hiện có của doanh nghiệp.

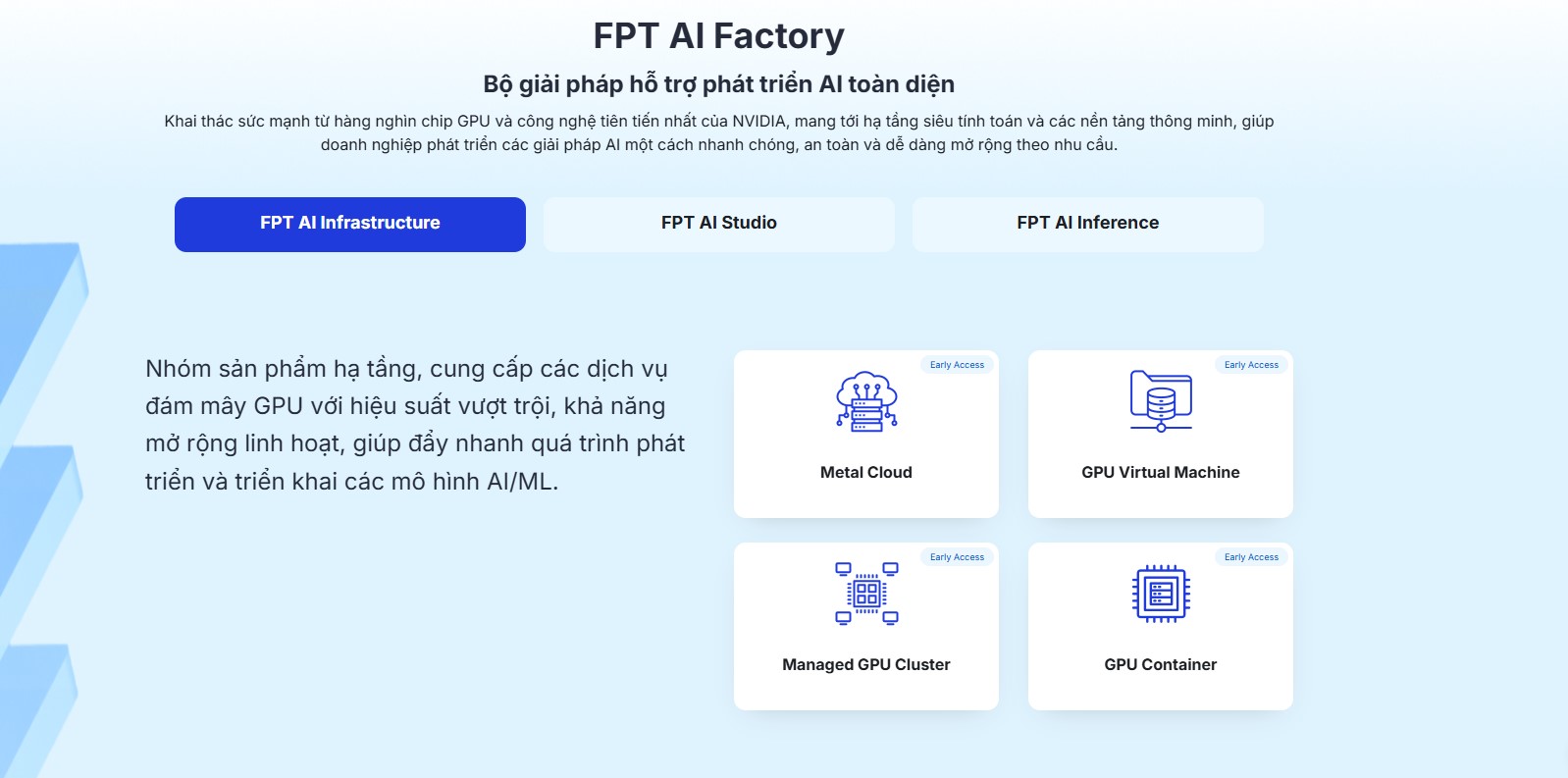

3. Kiến tạo hệ sinh thái toàn diện FPT AI Factory (FPT AI Infrastructure, FPT AI Studio và FPT AI Inference) Vững Mạnh Với Super Chip NVIDIA H100 & H200

FPT AI Factory hiện đang cung cấp bộ ba giải pháp AI được phát triển dựa trên công nghệ lõi là super chip NVIDIA H100 & NVIDIA H200 cho các doanh nghiệp bao gồm:

- FPT AI Infrastructure (Cơ sở hạ tầng AI của FPT): Đây là nhóm sản phẩm thuộc hạ tầng của doanh nghiệp.

- FPT AI Studio (Môi trường phát triển AI của FPT): Đây là nhóm sản phẩm thuộc nền tảng về công cụ và dịch vụ dành cho doanh nghiệp.

- FPT AI Inference (Suy luận AI của FPT): Đây là nhóm sản phẩm thuộc nền tảng về mô hình AI (Artificial Intelligence)/ML (Machine Learning) cho doanh nghiệp.

Video: Bộ ba giải pháp AI của FPT: FPT AI Infrastructure, FPT AI Studio và FPT AI Inference cho phép doanh nghiệp xây dựng, huấn luyện và vận hành các giải pháp AI một cách đơn giản, dễ dàng và hiệu quả

3.1 Giải pháp FPT AI Infrastructure

FPT AI Infrastructure là nền tảng cơ sở hạ tầng điện toán đám mây mạnh mẽ, được tối ưu hóa đặc biệt cho các tác vụ AI. Đây là nơi cung cấp sức mạnh tính toán vượt trội từ các GPU NVIDIA H100 và H200, cho phép doanh nghiệp xây dựng hạ tầng siêu tính toán, dễ dàng truy cập và sử dụng tài nguyên để huấn luyện các mô hình AI một cách nhanh chóng và có thể linh hoạt mở rộng theo nhu cầu của mình bằng các công nghệ như: Meta Cloud, GPU Virtual Machine, Managed CPU Cluster và GPU Container.

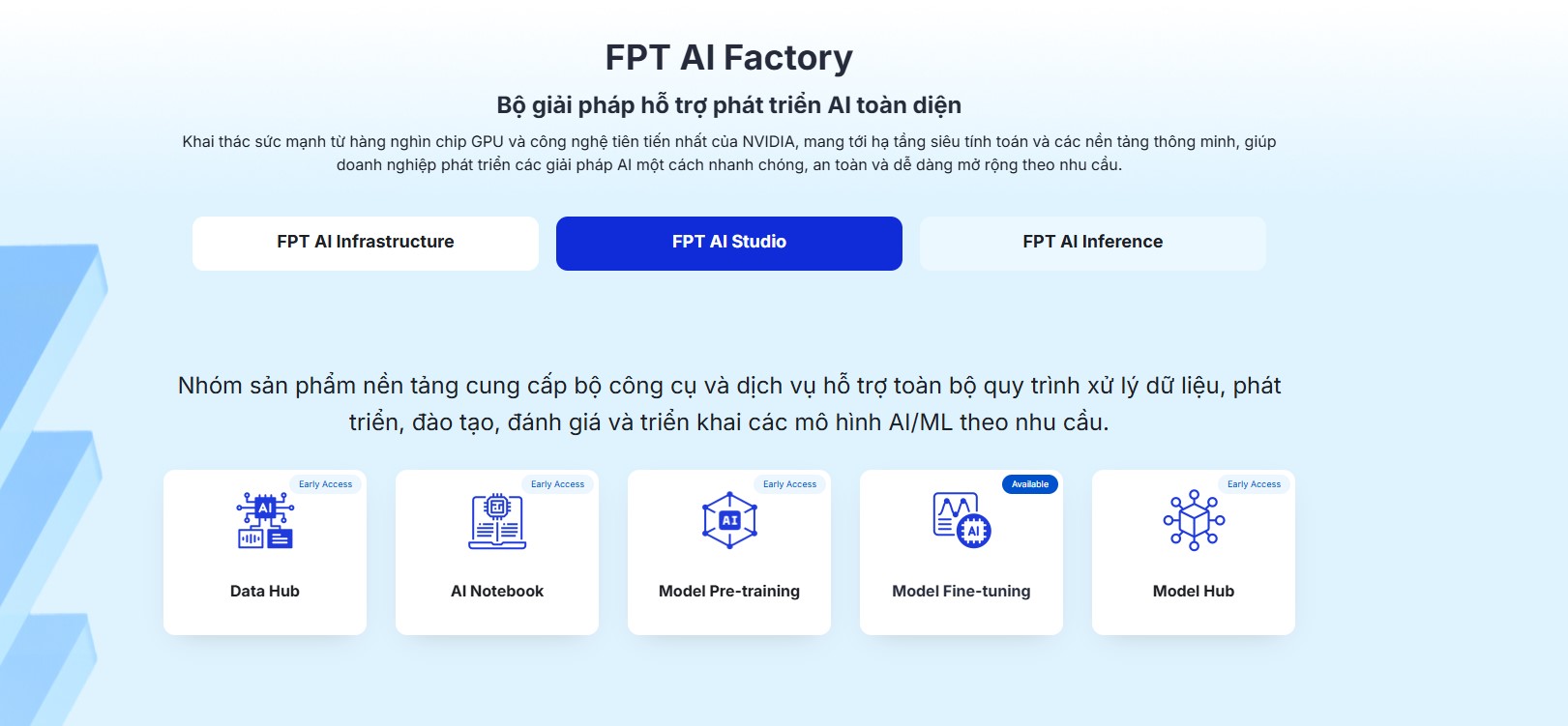

3.2 Sản phẩm AI Studio được phát triển bởi FPT Cloud

Sau khi đã xây dựng được hệ thống hạ tầng với công nghệ GPU tiên tiến thì tiếp theo doanh nghiệp cần xây dựng và phát triển các mô hình trí tuệ nhân tạo và học máy cho riêng mình nhằm phục vụ cho những nhu cầu riêng biệt trong khâu vận hành và ứng dụng khác nhau thì FPT AI Studio chính là giải pháp tối ưu dành cho doanh nghiệp. FPT AI Studio là một môi trường phát triển AI toàn diện, cung cấp đầy đủ các công cụ và dịch vụ hỗ trợ các doanh nghiệp trong quy trình xử lý dữ liệu, phát triển mô hình, đào tạo, đánh giá và triển khai các mô hình AI/ML thực tế theo nhu cầu thông qua các công nghệ hiện đại và tiên tiến: Data Hub, AI Notebook, Model PRe-training, Model Fine-tuning và Model Hub.

3.3 Dịch vụ AI Inference của FPT

Khi mô hình AI hay Machine Learning của doanh nghiệp đã được huấn luyện dựa trên dữ liệu nội bộ và các dữ liệu quan trọng khác, việc triển khai và vận hành nó trong môi trường thực tế đòi hỏi một giải pháp hiệu quả. FPT AI Inference chính là lựa chọn thông minh dành cho doanh nghiệp của bạn. Đây là giải pháp được tối ưu hóa để cung cấp tốc độ suy luận (inference) cao và độ trễ thấp, FPT AI Inference đảm bảo các mô hình AI của bạn có thể hoạt động nhanh chóng và chính xác trong các ứng dụng thực tế như trợ lý ảo, dịch vụ tư vấn khách hàng, hệ thống khuyến nghị, nhận diện hình ảnh, hay xử lý ngôn ngữ tự nhiên thông qua các công nghệ tiên tiến: Model Servering và Model-as-a-Service. Đây là mảnh ghép cuối cùng trong bộ giải pháp FPT AI Factory giúp doanh nghiệp đưa AI vào ứng dụng thực tiễn, mang lại giá trị kinh doanh ngay lập tức.

4. Ưu đãi độc quyền dành riêng cho khách hàng đăng ký trải nghiệm FPT AI Factory tại FPT Cloud

Những ưu đãi độc quyền mà FPT Cloud dành riêng cho bạn khi đăng ký trải nghiệm sớm bộ ba giải pháp toàn diện Nhà máy AI: FPT AI Infrastructure, FPT AI Studio và FPT AI Inference ngay hôm nay:

- Ưu tiên trải nghiệm các dịch vụ của FPT AI Infrastructure với mức giá ưu đãi: Tiết kiệm chi phí đáng kể khi tiếp cận cơ sở hạ tầng, bộ công cụ và ứng dụng AI hiện đại nhất thế giới ngay tại Việt Nam.

- Cung cấp quyền truy cập, sử dụng sớm các tính năng cao cấp của FPT AI Factory: Doanh nghiệp của bạn luôn là đơn vị tiên phong và dẫn đầu với những công nghệ và công cụ AI mới nhất trong thời đại chuyển đổi số.

- Nhận tín dụng Cloud để trải nghiệm hệ sinh thái AI và Cloud đa dạng: Doanh nghiệp của bạn có thể trải nghiệm các sản phẩm và dịch vụ khác của FPT Cloud nhằm nâng cao hiệu suất vận hành của mình như: FPT Backup Services, FPT Disaster Recovery và FPT Object Storage.

- Nhận tư vấn chuyên sâu từ các chuyên gia AI & Cloud giàu kinh nghiệm: Các chuyên gia AI và Cloud tại FPT sẽ hỗ trợ doanh nghiệp trong việc ứng dụng và vận hành bộ ba giải pháp FPT AI Factory vào trong quy trình thực tế của doanh nghiệp để mang lại hiệu quả kinh doanh tức thì.