Tối ưu hóa sức mạnh của AI tạo sinh cùng Retrieval-Augmented Generation (RAG)

Tối ưu hóa sức mạnh của AI tạo sinh cùng Retrieval-Augmented Generation (RAG)

Xem nhanh

Trí tuệ nhân tạo (AI) đang phát triển với tốc độ vượt bậc, làm thay đổi cách thức vận hành của các ngành công nghiệp và định hình lại cách doanh nghiệp tương tác với công nghệ. Ở trung tâm của làn sóng cách mạng này là các mô hình ngôn ngữ lớn (Large Language Models – LLM) như ChatGPT của OpenAI hay Google Gemini. Những mô hình này sở hữu năng lực vượt trội trong việc hiểu và tạo ra ngôn ngữ tự nhiên, trở thành công cụ hỗ trợ đắc lực cho nhiều lĩnh vực kinh doanh.

Tuy nhiên, LLMs vẫn tồn tại những hạn chế nhất định. Các mô hình này chủ yếu dựa trên dữ liệu được huấn luyện sẵn vốn có nguy cơ trở nên lỗi thời, thiếu sót hoặc chưa đáp ứng được nhu cầu chuyên sâu. Do đó, đôi khi chúng có thể tạo ra thông tin không chính xác, gây hiểu nhầm hoặc gặp khó khăn trong việc xử lý các truy vấn yêu cầu dữ liệu theo thời gian thực.

Để giải quyết thách thức này, phương pháp tăng cường truy xuất (Retrieval-Augmented Generation - RAG) đã ra đời. Cách tiếp cận này kết hợp sức mạnh sáng tạo của LLMs với khả năng truy xuất dữ liệu bên ngoài, từ đó mang lại các giải pháp AI chính xác, đáng tin cậy và sẵn sàng đáp ứng nhu cầu của doanh nghiệp.

Retrieval-Augmented Generation là gì?

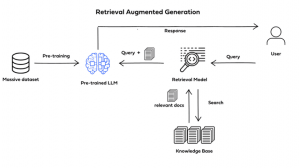

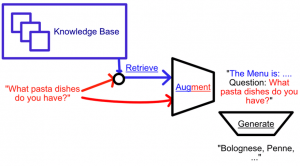

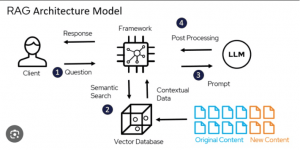

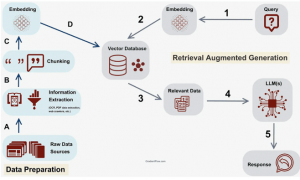

Tăng cường truy xuất là một phương pháp AI được thiết kế nhằm cải thiện cách mô hình ngôn ngữ lớn tạo ra phản hồi. Thay vì chỉ dựa vào kiến thức được huấn luyện sẵn, RAG tích hợp thêm bộ truy xuất (retriever), cho phép lấy thông tin từ các kho dữ liệu bên ngoài như API, nội dung trực tuyến, cơ sở dữ liệu và tài liệu nội bộ.

RAG được phát triển nhằm nâng cao chất lượng phản hồi của các mô hình ngôn ngữ lớn

Công cụ truy xuất (retriever) có thể được lựa chọn tùy thuộc vào nhu cầu về mức độ ngữ nghĩa và độ chính xác, bao gồm:

- Vector database: Các truy vấn được chuyển đổi thành vector nhúng (dense vector embedding) thông qua các mô hình như BERT (transformers- based Model). Ngoài ra, các phương pháp truyền thống như TF-IDF có thể được sử dụng để tạo ra sparse embeddings. Việc tìm kiếm dựa trên độ tương đồng ngữ nghĩa (semantic similarity) hoặc tần suất thuật ngữ (term frequency).

- Graph database: Xây dựng cơ sở tri thức (knowledge base) từ các mối quan hệ giữa các thực thể (entity) được trích xuất từ văn bản. Phương pháp này đảm bảo tính chính xác của tri thức nhưng đòi hỏi truy vấn ban đầu phải chính xác, gây khó khăn trong một số trường hợp.

- Regular SQL database: Lưu trữ và truy xuất dữ liệu có cấu trúc nhưng hạn chế về mặt linh hoạt trong việc xử lý ngữ nghĩa.

RAG đặc biệt hiệu quả trong xử lý lượng lớn dữ liệu phi cấu trúc, chẳng hạn như những thông tin phân tán khắp internet. Mặc dù dữ liệu này rất đa dạng, nhưng hiếm khi được tổ chức để trực tiếp trả lời truy vấn của người dùng.

Đó là lý do tại sao RAG đã được áp dụng rộng rãi trong các trợ lý ảo và chatbot (ví dụ: Siri, Alexa). Khi người dùng đặt câu hỏi, hệ thống có thể truy xuất dữ liệu liên quan và tạo câu trả lời rõ ràng, chính xác trong ngữ cảnh. Ví dụ: Khi được hỏi “Làm thế nào để cài đặt lại điều khiển ABC?”, RAG có thể truy xuất thông tin liên quan từ tài liệu sản phẩm và các tài liệu tương ứng, từ đó tạo ra câu trả lời ngắn gọn, dễ hiểu và chính xác.

Bằng cách kết hợp việc truy xuất kiến thức bên ngoài với khả năng của mô hình ngôn ngữ lớn, RAG giúp trải nghiệm người dùng trở nên chính xác, đáng tin cậy và phù hợp hơn, kể cả trong các tình huống phức tạp và chuyên ngành.

Mô hình RAG thường được ứng dụng phổ biến trong các trợ lý ảo và chatbot

Vì sao RAG quan trọng?

Các mô hình ngôn ngữ lớn như ChatGPT hay Gemini đã định hình các tiêu chuẩn mới cho xử lý ngôn ngữ tự nhiên với khả năng từ hiểu biết, tóm tắt cho đến sáng tạo nội dung. Tuy nhiên, dù có hiệu suất ấn tượng, những mô hình này vẫn có giới hạn nhất định. Khi các tác vụ đòi hỏi chuyên môn sâu trong lĩnh vực cụ thể hoặc kiến thức cập nhật vượt ra ngoài phạm vi dữ liệu đã được huấn luyện, các mô hình ngôn ngữ lớn có thể tạo ra các câu trả lời nghe có vẻ trôi chảy nhưng lại sai sự thật. Vấn đề này thường được gọi là ảo giác AI (AI hallucination).

Trong môi trường doanh nghiệp, thách thức này càng được thể hiện rõ rệt. Các tổ chức thường quản lý những kho lưu trữ khổng lồ chứa thông tin bảo mật bao gồm sổ tay kỹ thuật, tài liệu sản phẩm, các cơ sở kiến thức, mà các mô hình thường khó có thể điều hướng. Ngay cả các mô hình tiên tiến như GPT-4 vẫn có thể gặp phải hiệu ứng “lost in the middle” – một hạn chế khiến mô hình thường nhớ rõ thông tin ở đầu và cuối văn bản nhưng dễ bỏ sót các chi tiết quan trọng ở giữa, dẫn đến kết quả trả lời chưa đầy đủ.

RAG được phát triển để khắc phục toàn bộ những hạn chế này. Bằng cách tích hợp cơ chế truy xuất, RAG cho phép mô hình ngôn ngữ lớn lấy thông tin trực tiếp từ nguồn bên ngoài, từ dữ liệu công khai đến tài liệu riêng của doanh nghiệp. Điều này không chỉ bù đắp lỗ hổng kiến thức mà còn giảm thiểu rủi ro “ảo giác”, đảm bảo câu trả lời dựa trên dữ liệu có thể kiểm chứng.

Bằng cách tích hợp dữ liệu từ nguồn bên ngoài, RAG giúp LLM đưa ra phản hồi chính xác hơn và giảm nguy cơ ảo giác AI

Cách thức hoạt động của RAG

Lợi ích của RAG

RAG mang lại nhiều ưu điểm đáng kể so với các LLMs độc lập, bao gồm:

- Cập nhật kiến thức nhanh chóng: Truy xuất thông tin mới nhất một cách linh hoạt mà không cần huấn luyện lại mô hình.

- Giảm thiểu ảo giác AI: Các câu trả lời có căn cứ giúp giảm thiểu rủi ro nội dung bịa đặt.

- Tính minh bạch: Cung cấp nguồn tham chiếu, cho phép người dùng xác minh thông tin.

- Tăng hiệu quả chi phí: Loại bỏ các chu kỳ huấn luyện lại thường xuyên, giảm chi phí tính toán và tài chính.

- Khả năng mở rộng dễ dàng: Hoạt động hiệu quả trên nhiều lĩnh vực, từ chăm sóc sức khỏe, tài chính đến CNTT doanh nghiệp.

- Đa dạng ứng dụng: Cung cấp sức mạnh cho các ứng dụng như chatbot, hệ thống tìm kiếm và công cụ tóm tắt thông minh.

Ứng dụng thực tiễn của RAG

RAG chính là chìa khóa giúp AI tạo sinh khắc phục những hạn chế của các mô hình như ChatGPT hay Gemini, vốn chỉ dựa vào dữ liệu huấn luyện trước có thể nhanh chóng trở nên lỗi thời hoặc không chính xác.

Bằng cách kết hợp khả năng tạo sinh của các mô hình ngôn ngữ với việc truy xuất dữ liệu bên ngoài, RAG giúp đưa ra các câu trả lời rõ ràng, theo thời gian thực, giảm thiểu ảo giác AI và giúp doanh nghiệp tối ưu hóa chi phí.

Trong thực tế, RAG đang định hình tương lai của AI trong nhiều lĩnh vực, bao gồm:

- Chatbot và dịch vụ khách hàng: Cung cấp phản hồi tức thì, chính xác bằng cách truy xuất câu trả lời trực tiếp từ sổ tay sản phẩm, câu hỏi thường gặp (FAQs) hoặc cơ sở kiến thức.

- Chăm sóc sức khỏe: Cung cấp thông tin y khoa đáng tin cậy bằng cách tìm kiếm thông tin từ các hướng dẫn lâm sàng và nghiên cứu khoa học đã được xác minh.

- Tài chính: Hỗ trợ cho các nhà phân tích với những dữ liệu được cập nhật thị trường theo thời gian thực và những hiểu biết theo ngữ cảnh được rút ra từ các dữ liệu trực tiếp, giúp mang lại những insight hữu ích.

- Quản lý tri thức (Knowledge management): Giúp nhân viên tương tác với các tài liệu kỹ thuật và quy trình một cách tự nhiên.

Những trường hợp sử dụng thực tế này đã chứng minh cách RAG làm cho AI trở nên đáng tin cậy, minh bạch và thực sự có giá trị trên nhiều ngành công nghiệp.

Tương lai của RAG

RAG là bước tiến quan trọng hướng tới tạo ra giải pháp AI đáng tin cậy và có thẩm quyền. Bằng cách kết hợp giữa kiến thức đã học (parameterized knowledge) và dữ liệu truy xuất (retrieved knowledge), RAG khắc phục một trong những hạn chế lớn nhất của mô hình ngôn ngữ lớn.

Trong tương lai, với sự phát triển của tác nhân AI (AI có khả năng tự động phối hợp truy xuất, suy luận, và tạo sinh), kết hợp với tăng tốc phần cứng như NVIDIA Grace Hopper Superchip và các framework mã nguồn mở (LangChain) và hạ tầng sẵn sàng cho doanh nghiệp như FPT AI Factory với GPU hiệu năng cao, RAG sẽ ngày càng trở thành nền tảng cốt lõi cho các giải pháp AI của doanh nghiệp.

Vì vậy, RAG không chỉ là giải pháp cho vấn đề ảo giác hay thiếu hụt tri thức, mà chính là nền móng để xây dựng trợ lý thông minh, chatbot tiên tiến và hệ thống AI sẵn sàng cho doanh nghiệp trên mọi lĩnh vực.