Blogs Tech

Danh mục

Kiến thức cloud cho doanh nghiệp FPT Cloud

Ahamove ứng dụng Cloud và AI phục vụ hàng triệu đơn hàng mỗi tháng

16:54 22/11/2024

Trong thị trường giao hàng theo nhu cầu tại Việt Nam, Ahamove đang khẳng định vị thế là một trong những đơn vị hàng đầu. Bên cạnh mạng lưới đối tác tài xế rộng lớn, Ahamove không ngừng ứng dụng các giải pháp công nghệ hiện đại để tối ưu hóa quy trình vận hành, nâng cao trải nghiệm khách hàng.

Tối ưu vận hành, nâng cao trải nghiệm khách hàng

Ahamove là đơn vị chuyên cung cấp giải pháp giao hàng chặng cuối cho cá nhân và doanh nghiệp từ giao hàng nội thành, liên tỉnh đến phân phối hàng hóa bằng xe máy và xe tải. Với dịch vụ đa dạng gồm giao hàng siêu rẻ, nhận hàng siêu tốc, ứng COD cao, đa dạng tải trọng cùng chính sách đảm an toàn hàng hóa, Ahamove hiện đang phục vụ hơn 700,000 doanh nghiệp, 2.5 triệu khách hàng trên toàn quốc.

Đặc thù trong ngành giao hàng on-demand (giao hàng theo nhu cầu), luôn biến động theo nhu cầu khách hàng. Vào các dịp Lễ, Tết số lượng đơn hàng có thể tăng đột biến đến 200% trong những khung giờ cao điểm. Để đáp ứng hiệu quả, từ đầu năm 2024, Ahamove đã triển khai hạ tầng FPT Cloud với tính năng tự động mở rộng (auto-scaling), giúp hệ thống tự động điều chỉnh công suất theo nhu cầu, giảm lãng phí tài nguyên và đảm bảo dịch vụ không bị gián đoạn.

Việc sử dụng FPT Cloud giúp Ahamove duy trì ổn định hệ thống lên đến 99.99%, độ trễ xử lý dưới 200 ms và tiết kiệm đến 30% chi phí vận hành. Điều này không chỉ giúp Ahamove đáp ứng kịp thời các yêu cầu từ khách hàng mà còn củng cố lợi thế cạnh tranh nhờ đường truyền mạnh mẽ và đảm bảo tính bảo mật cao từ các dịch vụ của FPT Cloud.

[caption id="attachment_55291" align="alignnone" width="2560"] Ông Lê Sỹ Thắng - Kỹ Sư Trưởng của Ahamove chia sẻ[/caption]

Ông Lê Sỹ Thắng - Kỹ Sư Trưởng của Ahamove chia sẻ: “Nhờ đội ngũ kỹ thuật chuyên nghiệp từ FPT Cloud, các vấn đề bảo mật luôn được cập nhật kịp thời. Việc triển khai hệ thống trên FPT Cloud không chỉ giúp bảo vệ thông tin khách hàng mà còn đảm bảo quy mô vận hành linh hoạt và an toàn.”

Ahamove mở rộng quy mô, dẫn đầu thị trường với công nghệ AI tiên phong

Không ngừng đầu tư vào công nghệ, Ahamove đang phát triển mạnh mẽ trên nền tảng hạ tầng FPT Cloud, cải tiến hàng loạt tiện ích giúp người dùng dễ dàng theo dõi đơn hàng theo thời gian thực, cải thiện tốc độ phản hồi và dự đoán chính xác thời gian giao hàng. Với hạ tầng mạnh mẽ từ FPT Kubernetes, FPT Storage và FPT Database, Ahamove rút ngắn thời gian từ giai đoạn thử nghiệm đến triển khai sản phẩm, từ đó nâng cao khả năng đáp ứng nhu cầu của thị trường.

[caption id="attachment_55292" align="alignnone" width="2400"] Công nghệ là chìa khóa nâng cao chất lượng dịch vụ của Ahamove[/caption]

Ahamove hiện đang tiên phong ứng dụng các giải pháp AI trong vận hành và chăm sóc khách hàng, tiêu biểu là giải pháp FPT AI eKYC trong quy trình định danh tài xế và người dùng cuối. Tận dụng sức mạnh của AI cùng các công nghệ bảo mật, chống giả mạo tiên tiến giúp Ahamove tăng cường bảo vệ thông tin khách hàng, giảm thiểu rủi ro và ngăn chặn gian lận.

Bên cạnh FPT AI eKYC, đơn vị này hiện đang triển khai AI Chatbot tới các đối tác nhà hàng trong hệ thống AhaFood, thuộc phạm vi dự án AhaFood AI. Đến nay, dự án AhaFood AI đã được triển khai tại hơn 500 nhà hàng tại Đà Nẵng và đang mở rộng thử nghiệm tại Hà Nội và TP.HCM. Tất cả các dự án AI của Ahamove đều được xây dựng trên nền tảng hạ tầng FPT Cloud mạnh mẽ, linh hoạt, giúp tối ưu tốc độ và hiệu năng tính toán của các mô hình.

Với định hướng tương lai, Ahamove tiếp tục đầu tư mạnh mẽ vào công nghệ AI, nhằm mang đến những tính năng và giải pháp mới, giúp cải thiện trải nghiệm người dùng, thu hút thêm khách hàng và tài xế, và củng cố vị thế là ứng dụng giao hàng công nghệ hàng đầu khu vực.

FPT Cloud, nền tảng điện toán đám mây thế hệ mới của FPT Smart Cloud (thành viên Tập đoàn FPT), được triển khai trên hệ thống Data Center hiện đại tại Hà Nội và TP.HCM. Tuân thủ các tiêu chuẩn khắt khe về an toàn thông tin, FPT Cloud mang đến sự linh hoạt và tùy biến, đáp ứng nhu cầu đa dạng của doanh nghiệp.

Nền tảng cung cấp hệ sinh thái 80 dịch vụ, từ lưu trữ, tính toán, cơ sở dữ liệu đến công cụ phân tích và ứng dụng trí tuệ nhân tạo (FPT.AI), hỗ trợ doanh nghiệp khai thác giá trị dữ liệu, tối ưu hóa vận hành. Các giải pháp tích hợp bao gồm dịch vụ hạ tầng (IaaS), nền tảng (PaaS) và phần mềm (SaaS).

Nhằm hỗ trợ doanh nghiệp ngành logistics đẩy nhanh chuyển đổi số, FPT Cloud triển khai ưu đãi lên đến 50% dịch vụ Cloud Server và nhận tư vấn trực tiếp cùng các chuyên gia. Tại đây

Xu hướng ứng dụng điện toán đám mây trong ngành Logistics

14:19 21/11/2024

Xu hướng ứng dụng điện toán đám mây trong ngành Logistics như thế nào? Điện toán đám mây (Cloud Computing) đã trở thành xu hướng hàng đầu trong ngành logistics nhờ khả năng cung cấp các giải pháp tối ưu, linh hoạt và tiết kiệm chi phí.

Sự phát triển của công nghệ điện toán đám mây đang mang đến bước đột phá cho ngành logistics toàn cầu, mở ra những cơ hội để tối ưu hóa chi phí, tăng cường hiệu quả vận hành và cải thiện khả năng đáp ứng của chuỗi cung ứng.

Theo Data Bridge Market Research, thị trường chuỗi cung ứng đám mây dự kiến sẽ đạt 71,93 tỷ USD vào năm 2030, với tốc độ tăng trưởng kép (CAGR) 16,10% trong giai đoạn dự báo, đánh dấu vai trò thiết yếu của điện toán đám mây trong việc nâng cao khả năng cạnh tranh và đổi mới của các doanh nghiệp logistics.

Xu hướng ứng dụng điện toán đám mây trong ngành Logistics và quản lý chuỗi cung ứng

Với vai trò trung tâm của chuỗi cung ứng trong mọi hoạt động kinh doanh, nhiều doanh nghiệp logistics đang chuyển sang công nghệ đám mây để cải tiến các quy trình quản lý. Điện toán đám mây mang lại cơ sở hạ tầng linh hoạt và nền tảng phần mềm hiệu quả, cho phép tối ưu hóa toàn bộ chuỗi cung ứng từ dự báo nhu cầu đến quản lý hàng tồn kho và điều phối vận chuyển.

[caption id="attachment_55227" align="aligncenter" width="1200"] Xu hướng ứng dụng điện toán đám mây trong ngành Logistics[/caption]

Dự báo và lập kế hoạch

Điện toán đám mây cung cấp một nền tảng để thu thập và phân tích dữ liệu từ các điểm đầu và cuối của chuỗi cung ứng, bao gồm cả nhà cung cấp và khách hàng. Sử dụng hệ thống AI trên nền tảng đám mây, các doanh nghiệp có thể dự báo chính xác cung và cầu, tối ưu hóa quy trình lập kế hoạch sản xuất và phân phối, giúp giảm thiểu lãng phí và giảm chi phí lưu kho.

Tối ưu hóa logistics

Công nghệ đám mây giúp giám sát các hoạt động logistics, bao gồm theo dõi lộ trình, quản lý kho hàng, và tự động hóa các quy trình quản lý hàng tồn kho. Hệ thống trên nền tảng đám mây còn cung cấp khả năng phân tích dữ liệu về hiệu suất vận hành, từ đó đề xuất các cải tiến giúp tối ưu hóa tuyến đường và giảm thời gian giao hàng, mang lại sự tiện lợi và trải nghiệm khách hàng tốt hơn.

Tìm nguồn cung ứng và mua sắm thông minh

Nhờ hệ thống cơ sở dữ liệu đám mây, các doanh nghiệp có thể quản lý hiệu quả thông tin nhà cung cấp, theo dõi hàng tồn kho, và tự động hóa quy trình mua sắm. Điều này giúp tăng cường hiệu suất quy trình, giảm thiểu sự phụ thuộc vào nguồn cung ứng duy nhất và đảm bảo tính sẵn có của nguyên liệu.

Những lợi ích vượt trội khi áp dụng điện toán đám mây trong logistics

Điện toán đám mây mang lại nhiều lợi ích đột phá cho các công ty giao nhận on-demand (theo nhu cầu), giúp tối ưu hóa hoạt động, tăng khả năng linh hoạt và giảm thiểu chi phí vận hành. Đối với đơn vị giao nhận on-demand, điện toán đám mây hỗ trợ một số khía cạnh quan trọng như:

Tối ưu hóa lộ trình giao hàng và giảm thời gian vận chuyển

Các nền tảng đám mây cho phép truy cập dữ liệu theo thời gian thực, bao gồm tình trạng giao thông, mức độ tắc nghẽn và khả năng tiếp cận của các tuyến đường. Điều này giúp các công ty giao nhận on-demand lập kế hoạch lộ trình tối ưu, giảm thiểu thời gian giao hàng và đảm bảo đúng lịch trình cam kết.

Quản lý dữ liệu khách hàng và các lô hàng một cách linh hoạt

Điện toán đám mây cho phép lưu trữ và quản lý dữ liệu khách hàng, đơn hàng, và tình trạng giao hàng dễ dàng trên một hệ thống duy nhất. Điều này giúp các công ty nhanh chóng cập nhật và theo dõi từng bước của quy trình giao hàng, đáp ứng kịp thời các yêu cầu từ khách hàng.

Tích hợp nền tảng với các đối tác và nhà cung cấp dịch vụ logistics

Các công ty giao nhận on-demand có thể sử dụng đám mây để kết nối với đối tác logistics hoặc nhà cung cấp dịch vụ thứ ba (3PL). Điều này giúp mở rộng phạm vi hoạt động và linh hoạt trong việc đáp ứng khối lượng giao hàng tăng đột biến. Tính năng tích hợp API trên đám mây giúp dễ dàng trao đổi thông tin giữa các bên liên quan và tối ưu hóa chuỗi cung ứng.

Theo dõi và báo cáo theo thời gian thực (real-time)

Nhờ các công cụ theo dõi và báo cáo đám mây, các đơn vị giao nhận có thể giám sát vị trí của đội xe và tình trạng giao hàng theo thời gian thực. Điều này giúp đơn vị quản lý phản hồi kịp thời khi có vấn đề phát sinh, từ đó tăng cường trải nghiệm của khách hàng và giảm thiểu các khiếu nại về giao hàng.

[caption id="attachment_55229" align="aligncenter" width="1200"] Xu hướng ứng dụng cloud trong ngành logistics[/caption]

Khả năng mở rộng theo nhu cầu sử dụng

Điện toán đám mây cho phép các công ty giao nhận on-demand mở rộng nhanh chóng khi nhu cầu tăng cao, như vào dịp lễ, giờ cao điểm hoặc các chương trình khuyến mãi lớn. Các nền tảng SaaS (Phần mềm dưới dạng dịch vụ) cung cấp tùy chọn linh hoạt trong quy mô và dịch vụ, cho phép doanh nghiệp chỉ trả phí cho các dịch vụ sử dụng thực tế.

Cải thiện bảo mật và tính sẵn sàng của hệ thống

Đám mây cung cấp các biện pháp bảo mật và phục hồi dữ liệu nâng cao, giúp bảo vệ thông tin nhạy cảm về khách hàng và đơn hàng, giảm thiểu rủi ro từ các sự cố kỹ thuật hoặc tấn công mạng. Điều này rất quan trọng đối với các đơn vị giao nhận on-demand, vì hệ thống phải luôn sẵn sàng phục vụ trong thời gian cao điểm.

Tự động hóa quy trình và cải thiện dịch vụ khách hàng

Với sự hỗ trợ của AI và tự động hóa trên nền tảng đám mây, các công ty giao nhận có thể tự động phân bổ tài xế, lập lộ trình giao hàng và xử lý đơn hàng nhanh chóng. Bên cạnh đó, các công cụ đám mây tích hợp chatbot cũng cải thiện khả năng chăm sóc khách hàng, giảm bớt thời gian chờ đợi và nâng cao trải nghiệm người dùng.

Phân tích dữ liệu và dự báo nhu cầu

Các nền tảng đám mây cung cấp khả năng phân tích dữ liệu toàn diện, giúp các công ty giao nhận on-demand dự báo nhu cầu và lập kế hoạch giao hàng chính xác hơn. Từ dữ liệu lịch sử và xu hướng thị trường, doanh nghiệp có thể đưa ra các quyết định kịp thời, chủ động quản lý tài nguyên và nâng cao hiệu quả vận hành.

Điện toán đám mây thực sự đóng vai trò như một nền tảng kết nối linh hoạt, giúp các đơn vị giao nhận on-demand nâng cao khả năng phục vụ, tối ưu hóa chi phí và đáp ứng linh hoạt nhu cầu của khách hàng trong bối cảnh cạnh tranh gay gắt.

Số hóa doanh nghiệp logistics với hệ sinh thấy chuyển đổi số toàn diện - FPT Cloud

Sau gần 1 năm sử dụng FPT Cloud từ đầu năm 2024 Ahamove rất hài lòng với các dịch vụ của FPT Smart Cloud mang lại đó là sự ổn định, đội ngũ support chuyên nghiệp và nhiệt tình hỗ trợ, và giúp Ahamove tối ưu được chi phí đáng kể khi sử dụng. Các chuyên gia từ FPT Cloud cũng thường xuyên cập nhật chia sẻ những dịch vụ, công cụ mới và hỗ trợ tư vấn giải pháp cho Ahamove giúp việc vận hành hệ thống được suôn sẻ hơn.

Ahamove đã sử dụng dịch vụ FPT Cloud với tính năng tự động mở rộng (auto-scaling), khi đơn hàng tăng đột ngột, hệ thống sẽ tự động mở rộng, ngược lại khi nhu cầu giảm, hệ thống sẽ thu hẹp, giúp tối ưu tài nguyên. Tính năng này không chỉ giúp giảm lãng phí mà còn đảm bảo khả năng phục vụ liên tục, không bị gián đoạn, đáp ứng trải nghiệm khách hàng xuyên suốt.

Với hơn 20,000 tài xế hoạt động cùng hàng trăm đơn hàng hoàn thành mỗi ngày, việc sử dụng công nghệ đã giúp Ahamove đảm bảo hệ thống hoạt động liên tục, ổn định lên đến 99.99% và giảm độ trễ của mỗi yêu cầu xuống dưới 200ms. Theo chia sẻ của doanh nghiệp này, chi phi vận hành đã giảm được 30% khi sử dụng hạ tầng FPT Cloud, đồng thời tối ưu lợi thế về đường truyền vì tập khách hàng của Ahamove chủ yếu là doanh nghiệp tại Việt Nam. Bên cạnh đó, FPT Cloud còn giúp Ahamove đảm bảo tính an toàn thông tin, đạt mức độ bảo mật cao với các dịch vụ đi kèm.

[embed]https://www.youtube.com/watch?v=EnMcAxd3K28[/embed]

Change Data Capture: Đồng bộ dữ liệu tự động cho doanh nghiệp

11:39 21/10/2024

Change Data Capture là gì?

Change Data Capture (CDC) là một giải pháp sao chép dữ liệu, ghi lại những thay đổi trong cơ sở dữ liệu ngay khi chúng xảy ra và chuyển chúng đến các cơ sở dữ liệu. CDC cung cấp khả năng ghi nhận thay đổi với tác động thấp và chuyển giao nhanh chóng các thay đổi dữ liệu cho các sáng kiến quản lý thông tin quan trọng, bao gồm kho dữ liệu động, quản lý dữ liệu chính, hợp nhất hoặc di chuyển ứng dụng, BI hoạt động, và hỗ trợ các dự án SOA. CDC cũng giúp giảm thiểu chi phí xử lý và lưu lượng mạng bằng cách chỉ gửi dữ liệu đã thay đổi. Bạn có thể thực hiện sao chép liên tục hoặc theo định kỳ. Khi dữ liệu được chuyển từ máy chủ nguồn, nó có thể được ánh xạ lại hoặc chuyển đổi trong môi trường mục tiêu.

Việc tự động cập nhật những thay đổi về dữ liệu sẽ giúp chúng ta xử lý được nhiều các bài toán trong việc xử lý dữ liệu. Để mà có thể bắt được sự thay đổi dữ liệu này thì có rất nhiều các khác nhau, nguyên thủy nhất ta có thể sử dụng cơ chế TRIGGER trong các database đã hỗ trợ sẵn để bắt các ACTION về update, insert, delete,... Hoặc nhẹ nhàng hơn chúng ta có thể sử dụng các công cụ để làm việc này, điển hình có dịch vụ FPT CDC – Change Data Capture.

Tại sao Change Data Capture lại rất quan trọng đối với doanh nghiệp

Ngày nay, dữ liệu là trung tâm trong cách các doanh nghiệp hiện đại vận hành và là yếu tố chính thúc đẩy chuyển đổi số và ra quyết định kinh doanh. Các kiến trúc dữ liệu hiện đại đang ngày càng gia tăng. Các công ty đang chuyển dữ liệu của họ từ cơ sở hạ tầng tại chỗ lên đám mây bao gồm kho dữ liệu đám mây và hồ dữ liệu. Doanh nghiệp đang chuyển từ quản lý dữ liệu theo lô (Batch) sang quản lý dữ liệu theo thời gian thực (streaming). Nhưng họ vẫn gặp khó khăn trong việc theo kịp với khối lượng, sự đa dạng và tốc độ dữ liệu đang gia tăng. Các kiến trúc đám mây mới đang giải quyết những thách thức này. Chúng bao gồm kho dữ liệu đám mây, hồ dữ liệu đám mây và phát trực tuyến dữ liệu.

Nhưng tuổi thọ của dữ liệu đang giảm dần. Khi dữ liệu nhạy cảm với thời gian, giá trị của nó đối với doanh nghiệp sẽ nhanh chóng hết hạn. Những hiểu biết về dữ liệu theo thời gian thực là thước đo mới cho sự thành công trong kỷ nguyên số. Khi một công ty không thể hành động ngay lập tức, họ sẽ bỏ lỡ cơ hội kinh doanh. Những hiểu biết về dữ liệu cung cấp giá trị lớn hơn gấp bội so với phân tích truyền thống, nhưng giá trị đó sẽ nhanh chóng lỗi thời và không mang lại giá trị cao.

Lợi ích Change Data Capture (CDC) là gì?

CDC ghi lại các thay đổi thông tin giữa các cơ sở dữ liệu. Sau đó, nó đẩy các thay đổi đến một điểm đến như Cloud Data Lake, kho dữ liệu đám mây hoặc trung tâm giám sát. Điều này mang lại nhiều lợi ích cho tổ chức:

Hiệu quả hơn

Với CDC, chỉ những dữ liệu đã thay đổi mới được đồng bộ hóa. Điều này hiệu quả gấp nhiều lần so với việc sao chép toàn bộ cơ sở dữ liệu. Các cập nhật dữ liệu liên tục tiết kiệm thời gian và nâng cao độ chính xác của dữ liệu và phân tích. Điều này rất quan trọng khi dữ liệu di chuyển từ hệ thống quản lý dữ liệu chính (MDM) đến các quy trình tải công việc sản xuất.

Quyết định nhanh hơn

CDC giúp các tổ chức đưa ra quyết định nhanh hơn. Việc tìm kiếm, phân tích và hành động dựa trên các thay đổi dữ liệu trong thời gian thực là rất quan trọng. Sau đó, bạn có thể tạo ra những trải nghiệm kỹ thuật số siêu cá nhân hóa và theo thời gian thực cho khách hàng của mình. Ví dụ, phân tích thời gian thực cho phép các nhà hàng tạo ra thực đơn cá nhân hóa dựa trên dữ liệu khách hàng lịch sử. Dữ liệu từ các thiết bị di động hoặc thiết bị đeo tay cung cấp những ưu đãi hấp dẫn hơn cho khách hàng. Các nhà bán lẻ trực tuyến có thể phát hiện các mẫu mua hàng để tối ưu hóa thời gian và giá cả của các ưu đãi.

Ứng dụng ít bị ảnh hưởng hơn

Chuyển dữ liệu từ nguồn đến máy chủ vận hành chính tốn nhiều thời gian. CDC ghi lại các cập nhật gia tăng với tác động tối thiểu từ nguồn đến đích. Nó có thể đọc và tiêu thụ các thay đổi gia tăng trong thời gian thực. Mục tiêu phân tích sau đó được cung cấp dữ liệu liên tục mà không làm gián đoạn các cơ sở dữ liệu sản xuất. Điều này mở ra cơ hội cho việc chuyển giao dữ liệu khối lượng lớn đến mục tiêu phân tích.

Cải thiện thời gian để tạo giá trị và giảm TCO:

CDC cho phép bạn xây dựng đường ống dữ liệu ngoại tuyến của mình nhanh hơn. Điều này giúp bạn tránh khỏi những lo lắng liên quan đến việc viết kịch bản. Nó có nghĩa là các kỹ sư dữ liệu và kiến trúc sư dữ liệu có thể tập trung vào những nhiệm vụ quan trọng giúp thúc đẩy doanh nghiệp của bạn. Nó cũng giảm sự phụ thuộc vào những người dùng ứng dụng có kỹ năng cao. Điều này làm giảm tổng chi phí sở hữu (TCO).

Ứng dụng của Change Data Capture (CDC) trong doanh nghiệp

CDC ghi lại những thay đổi từ log thay đổi của cơ sở dữ liệu. Sau đó, nó công bố những thay đổi này đến trung tâm dữ liệu chính. Một trường hợp sử dụng CDC truyền thống là đồng bộ hóa cơ sở dữ liệu. Phân tích dữ liệu theo luồng thời gian thực và việc tiếp nhận hồ dữ liệu đám mây là những trường hợp sử dụng CDC hiện đại hơn.

Đồng bộ hóa/nhân bản cơ sở dữ liệu truyền thống

Thường thì việc quản lý thay đổi dữ liệu liên quan đến việc nhân bản dữ liệu theo lô (Batch). Với nhu cầu ngày càng tăng về việc ghi lại và phân tích dữ liệu theo luồng thời gian thực (Real-time), các công ty không thể ngừng hoạt động và sao chép toàn bộ cơ sở dữ liệu để quản lý thay đổi dữ liệu. CDC cho phép nhân bản liên tục trên các tập dữ liệu nhỏ hơn. Nó cũng chỉ giải quyết các thay đổi gia tăng.

Hãy tưởng tượng bạn có một hệ thống trực tuyến đang liên tục cập nhật cơ sở dữ liệu ứng dụng của bạn. Với CDC, chúng ta có thể ghi lại những thay đổi gia tăng đối với bản ghi. Vì vậy, khi khách hàng quay lại và cập nhật thông tin của họ, CDC sẽ cập nhật bản ghi trong cơ sở dữ liệu mục tiêu theo thời gian thực. Trong một ứng dụng tiêu dùng, bạn có thể tiếp nhận và hành động dựa trên những thay đổi đó nhanh hơn nhiều. Việc xử lý một trăm bản ghi sẽ mất ít thời gian hơn so với một triệu hàng. Bạn cũng có thể xác định cách xử lý các thay đổi (tức là, nhân bản hoặc bỏ qua chúng).

Phân tích dữ liệu theo luồng thời gian thực và tiếp nhận dữ liệu Cloud Data Lake

Khía cạnh khó khăn nhất của việc quản lý hồ dữ liệu đám mây là giữ cho dữ liệu luôn cập nhật. Với kiến trúc dữ liệu hiện đại, các công ty có thể liên tục tiếp nhận dữ liệu CDC vào Data Lake thông qua Data Pipeline tự động. Điều này tránh việc di chuyển hàng terabyte dữ liệu một cách không cần thiết qua mạng. Bạn có thể tập trung vào sự thay đổi trong dữ liệu, tiết kiệm chi phí tính toán và mạng. Với sự hỗ trợ cho các công nghệ như Apache Spark để xử lý theo thời gian thực, CDC là công nghệ nền tảng để thúc đẩy phân tích thời gian thực tiên tiến. Bạn cũng có thể hỗ trợ các trường hợp sử dụng trí tuệ nhân tạo (AI) và học máy (ML).

Phát hiện gian lận trong tài chính

Đối với các tổ chức dựa trên dữ liệu, trải nghiệm khách hàng rất quan trọng để giữ chân và phát triển cơ sở khách hàng của họ. Một ví dụ điển hình là trong lĩnh vực tài chính. Nếu một ngân hàng lớn gặp phải sự gia tăng đột ngột về các hoạt động gian lận, họ cần phân tích theo thời gian thực để chủ động cảnh báo khách hàng về các gian lận tiềm ẩn. Dữ liệu giao dịch cần được thu thập từ cơ sở dữ liệu theo thời gian thực. Sau đó, nó có thể chuyển đổi và làm phong phú dữ liệu để công cụ giám sát gian lận có thể chủ động gửi tin nhắn và email cảnh báo cho khách hàng. Khi đó, khách hàng có thể thực hiện hành động khắc phục ngay lập tức.

Dịch vụ FPT CDC – Change Data Capture là một công cụ mạnh mẽ cho phép doanh nghiệp theo dõi và đồng bộ hóa dữ liệu thay đổi một cách hiệu quả giữa các hệ thống khác nhau, cập nhật dữ liệu thời gian thực, và hỗ trợ các quy trình phân tích và báo cáo từ đó tối ưu hóa các quy trình kinh doanh.

Liên hệ với chúng tôi để được tư vấn chi tiết và dùng thử giải pháp FPT Cloud Data Platform Tại đây

Hotline: 1900 638 399

Email: [email protected]

Support: m.me/fptsmartcloud

ETL và ELT: Những sự khác biệt cần phải biết

11:00 02/10/2024

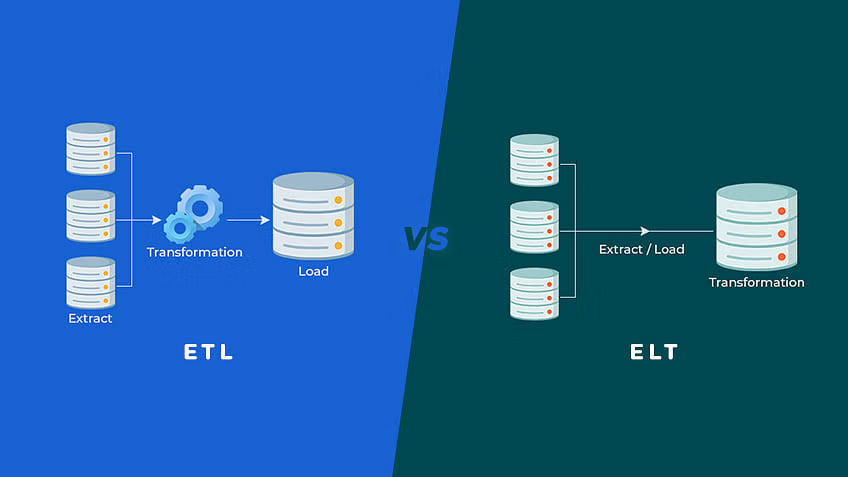

Trích xuất, chuyển đổi và tải (ETL) cũng như trích xuất, tải và chuyển đổi (ELT) là hai phương pháp xử lý dữ liệu để phân tích. Các tổ chức lớn có hàng trăm (hoặc thậm chí hàng ngàn) nguồn dữ liệu từ mọi khía cạnh trong hoạt động của họ – ví dụ như các ứng dụng, cảm biến, cơ sở hạ tầng CNTT và các đối tác bên thứ ba. Họ phải lọc, sắp xếp và làm sạch khối lượng dữ liệu lớn này để biến chúng trở lên hữu ích cho phân tích và nghiệp vụ thông minh.

Trong bài viết này FPT Cloud chia sẻ thêm những điểm tương đồng và khác biệt giữa 2 phương pháp trong quá trình xử lý dữ liệu.

ETL là gì?

ETL là tên viết tắt của Trích xuất, chuyển đổi, và tải (Extract, Transform, Load). Trong quá trình này, một công cụ ETL trích xuất dữ liệu từ các hệ thống nguồn RDBMS khác nhau sau đó chuyển đổi dữ liệu như áp dụng các biến đổi dữ liệu ( tính toán, nối chuỗi v.v. ) và sau đó tải dữ liệu vào hệ thống Data Warehouse. ETL là những luồng từ “nguồn” tới ”đích”. Trong quá trình ETL, engine chuyển đổi sẽ xử lý mọi thay đổi dữ liệu.

ELT là gì?

ELT là một phương pháp khác để tiếp cận công cụ chuyển động dữ liệu. Thay vì chuyển đổi dữ liệu trước khi viết, ELT cho phép “hệ thống đích” chuyển đổi trước. Dữ liệu đầu tiên được sao chép vào “đích” và sau đó được chuyển đổi tại đó. ELT thường được sử dụng với các database No-SQL như Hadoop, Data Appliance hoặc Cloud Installation.

Các quy trình ELT và ETL khác nhau như thế nào?

Tiếp theo, chúng tôi phác thảo các quy trình trích xuất, chuyển đổi và tải (ETL) và trích xuất, tải và chuyển đổi (ELT). Bạn cũng có thể đọc một số thông tin nền tảng lịch sử.

Quy trình ETL

ETL bao gồm ba bước:

Bạn trích xuất dữ liệu thô từ nhiều nguồn khác nhau

Bạn sử dụng một máy chủ xử lý thứ cấp để chuyển đổi dữ liệu

Bạn tải dữ liệu đó vào cơ sở dữ liệu mục tiêu

Giai đoạn chuyển đổi giúp đảm bảo cơ sở dữ liệu mục tiêu tuân thủ các yêu cầu về cấu trúc. Bạn chỉ di chuyển dữ liệu khi dữ liệu đã được chuyển đổi và sẵn sàng.

Quy trình ELT

Đây là ba bước của ELT:

Bạn trích xuất dữ liệu thô từ nhiều nguồn khác nhau

Bạn tải dữ liệu ở trạng thái tự nhiên vào một kho dữ liệu hoặc hồ dữ liệu

Bạn chuyển đổi dữ liệu nếu cần thiết trong khi ở hệ thống mục tiêu

Với ELT, tất cả các quá trình làm sạch, chuyển đổi và bổ sung dữ liệu diễn ra trong kho dữ liệu. Bạn có thể tương tác và chuyển đổi dữ liệu thô nhiều lần nếu cần.

Sự khác nhau giữa ETL và ELT

ETL và ELT khác nhau ở những điểm sau:

ETLELT1. Quy trìnhDữ liệu được chuyển đổi từ server staging sau đó được transfer tới Data warehouse DBDữ liệu vẫn còn trong DB của Data warehouse2. Code UsageĐược sử dụng cho:-Những biến đổi chuyên sâu về tính toán-Lượng data nhỏĐược sử dụng cho lượng data rất lớn3. Biến đổi dữ liệuCác biến đổi được thực hiện trong ETL server/stagingCác biến đổi được thực hiện bên trong “hệ thống đích”4. Thời gian loadDữ liệu trước tiên được load vào staging sau đó mới load vào “đích”. Cần nhiều thời gianDữ liệu được load vào “đích” chỉ 1 lần sau đó mới biến đổi. Nhanh hơn5. Thời gian biến đổiQuá trình ETL bắt buộc cần quá trình “Tranform” hoàn tất. Khi kích thước dữ liệu tăng lên, thời gian chuyển đổi cũng tăng theo.. Trong quá trình ELT, tốc độ không bao giờ phụ thuộc vào kích thước của dữ liệu.6. Thời gian bảo trìNhu cầu bảo trì là rất cao vì cần phải chọn dữ liệu để load và transformNhu cầu bảo trì là rất thấp vì dữ liệu luôn có sẵn7. Độ phức tạp khi bắt đầuỞ giai đoạn đầu thực hiện rất dễ dàngĐể thực hiện quá trình ELT, cần phải có những kiến thức rất sâu về các tools và kĩ năng chuyên môn8. Hỗ trợ Data warehouse?Mô hình ETL được sử dụng cho dữ liệu on-premise, quan hệ và có cấu trúcĐược sử dụng cho cơ sở hạ tầng cloud có thể support các nguồn dữ liệu có cấu trúc và phi cấu trúc9. Hỗ trợ Data LakeKhông supportCho phép sử dụng Data Lake với dữ liệu phi cấu trúc10. Độ phức tạpQuá trình ETL chỉ load những dữ liệu quan trọng, như đã được xác định trước từ thời điểm designQuá trình này bao gồm tất cả quá trình phát triển từ output-backward và load những dữ liệu liên quan11. Chi phíChi phí rất cao cho các doanh nghiệp vừa và nhỏChi phí đầu vào thấp khi sử dụng các phần mềm online làm Services Platforms12. LookupsTrong quá trình ETL, cả 2 bảng Facts và Dimensions cần có sẵn trong StagingTất cả dữ liệu đều sẽ có sẵn vì Extract và Load được thực hiện chỉ trong 1 hành động13. AggregationsĐộ phức tạp tăng lên với dữ liệu thêm vào trong datasetSức mạnh của target platform có thể xử lí một lượng dữ liệu đáng kể 1 cách nhanh chóng14. Tính toánGhi đè lên cột đang có hoặc cần cắm cờ và đẩy sang “đích”Dễ dàng thêm cột đã được tính toán vào bảng hiện có.15. MaturityETL đã được sử dụng trong hơn 2 thập kỷ. Nó có bộ tài liệu tốt và dễ dàng để thực hànhKhái niệm tương đối mới và khá phức tạp để triển khai16. HardwareHầu hết các tools đều có yêu cầu về hardware riêng biệt, tương đối đắt tiềnChi phí cho phần cứng hệ thống điện toán đám mây không phải là vấn đề to tát17. Hỗ trợ dữ liệu phí cấu trúcChủ yếu hỗ trợ dữ liệu quan hệ cấu trúcCó hỗ trợ sẵn cho dữ liệu phi cấu trúc

So sánh về thời điểm nên sử dụng ETL hay ELT

Trích xuất, tải và chuyển đổi (ELT) là lựa chọn tiêu chuẩn cho các phân tích hiện đại. Tuy nhiên, bạn có thể cân nhắc trích xuất, chuyển đổi và tải (ETL) trong các tình huống sau đây.

Cơ sở dữ liệu cũ

Đôi khi, bạn sẽ hưởng lợi nhiều hơn khi sử dụng ETL để tích hợp với cơ sở dữ liệu cũ hoặc các nguồn dữ liệu của bên thứ ba có các định dạng dữ liệu đã xác định trước. Bạn chỉ phải chuyển đổi và tải dữ liệu một lần vào hệ thống của bạn. Sau khi chuyển đổi, bạn có thể sử dụng dữ liệu hiệu quả hơn cho tất cả các phân tích trong tương lai.

Thử nghiệm

Trong các tổ chức lớn, các kỹ sư dữ liệu tiến hành các thử nghiệm – ví dụ như khám phá các nguồn dữ liệu ẩn để phân tích và thử những ý tưởng mới để trả lời các truy vấn về hoạt động kinh doanh. ETL rất hữu ích trong các thử nghiệm dữ liệu để hiểu cơ sở dữ liệu và tính hữu dụng của cơ sở dữ liệu trong một tình huống cụ thể.

Phân tích phức tạp

ETL và ELT có thể được sử dụng cùng nhau cho các phân tích phức tạp sử dụng nhiều định dạng dữ liệu từ nhiều nguồn khác nhau. Các nhà khoa học dữ liệu có thể thiết lập quy trình ETL từ một số nguồn và sử dụng ELT với phần còn lại. Điều này cải thiện hiệu quả phân tích và tăng hiệu năng của ứng dụng trong một số trường hợp.

Ứng dụng IoT

Các ứng dụng Internet vạn vật (IoT) sử dụng luồng dữ liệu cảm biến thường hưởng lợi từ ETL thay vì ELT. Ví dụ: dưới đây là một số trường hợp sử dụng phổ biến cho ETL tại biên:

Bạn muốn nhận dữ liệu từ các giao thức khác nhau và chuyển đổi dữ liệu thành các định dạng dữ liệu chuẩn để sử dụng trong khối lượng công việc trên đám mây

Bạn muốn lọc dữ liệu tần suất cao, thực hiện các hàm tính trung bình trên các tập dữ liệu lớn, sau đó tải các giá trị đã tính trung bình hoặc đã lọc với tốc độ chậm hơn

Bạn muốn tính giá trị từ các nguồn dữ liệu khác nhau trên thiết bị cục bộ và gửi các giá trị đã lọc tới backend của đám mây

Bạn muốn làm sạch, chống trùng lặp hoặc điền vào các thành phần dữ liệu chuỗi thời gian bị thiếu

Tổng quan lại:

ETL là viết tắt của Extract, Transform và Load trong khi ELT là viết tắt của Extract, Load, Transform.

Trước tiên, ETL load data vào staging server sau đó mới mới sang “đích” trong khi ELT load thẳng dữ liệu vào trực tiếp “đích”.

Mô hình ETL được sử dụng cho dữ liệu on-premises, dữ liệu có cấu trúc và quan hệ trong khi ELT được sử dụng cho các nguồn dữ liệu có cấu trúc và phi cấu trúc trên hệ thống đám mây mở rộng.

ETL chủ yếu được sử dụng cho một lượng nhỏ dữ liệu trong khi ELT được sử dụng cho lượng dữ liệu lớn.

ETL không cung cấp hỗ trợ Lake Data trong khi ELT cung cấp hỗ trợ Lake Data.

ETL rất dễ thực hiện trong khi ELT yêu cầu các kỹ năng thích hợp để thực hiện và duy trì.

Giải bài toán dữ liệu hiệu quả cho tổ chức Việt với nền tảng toàn diện FPT Cloud Data Platform

FPT Cloud Data Platform là một giải pháp công nghệ toàn diện được triển khai trên cơ sở hạ tầng đám mây để quản lý, lưu trữ, xử lý và phân tích dữ liệu. Đây là một môi trường tích hợp cho phép các doanh nghiệp dễ dàng làm việc với dữ liệu từ nhiều nguồn khác nhau, cung cấp khả năng mở rộng linh hoạt và truy cập từ bất kỳ đâu. FPT Cloud Data Platform có khả năng bao quát các bài toán lớn về dữ liệu của các cơ quan, tổ chức với 4 giải pháp chính từ: Kết nối và tổng hợp dữ liệu nhiều nguồn; Lưu trữ dữ liệu, xử lý dữ liệu; Khai phá và trực quan hóa dữ liệu.

Nhờ khả năng cho phép kết nối dữ liệu từ đa nguồn mà không cần phụ thuộc đơn vị quản lý nguồn dữ liệu gốc, không làm gián đoạn vận hành hệ thống hiện tại, FPT Cloud Data Platform giúp các tổ chức duy trì kết nối, liên thông CSDL dùng chung và cung cấp dịch vụ tới các cấp liên tục, hiệu quả.

Liên hệ với chúng tôi để được tư vấn chi tiết và dùng thử giải pháp FPT Cloud Data Platform Tại đây

Hotline: 1900 638 399

Email: [email protected]

Support: m.me/fptsmartcloud

Tích hợp dữ liệu: Công cụ hàng đầu cho hoạt động quản trị dữ liệu trong doanh nghiệp

11:23 26/09/2024

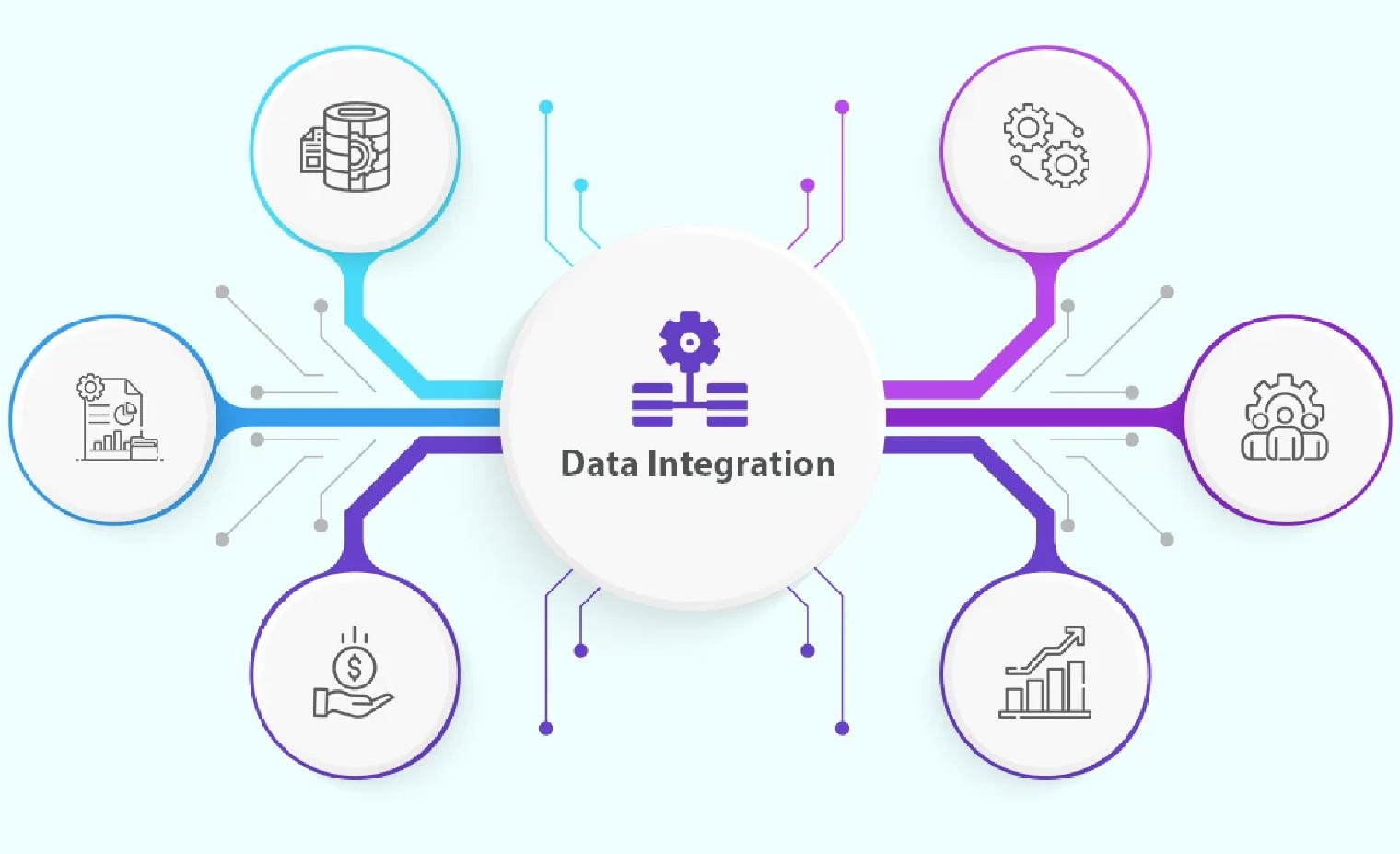

Trong kỷ nguyên công nghệ 4.0, dữ liệu là kho "vàng" cho mọi hoạt động ra quyết định của doanh nghiệp. Tuy nhiên, một thực trạng phổ biến hiện nay của nhiều doanh nghiệp là tình trạng dữ liệu bị phân mảnh, rời rạc khi bị lưu trữ ở nhiều nguồn khác nhau: như cơ sở dữ liệu, hệ thống CRM, ERP hay POS…

Vậy làm sao để dữ liệu được thống nhất và góp phần xây dựng vào bức tranh toàn cảnh về hoạt động kinh doanh của doanh nghiệp? Data Integration, tức Tích hợp dữ liệu, là một giải pháp then chốt giúp nhà quản trị giải quyết vấn đề “nhức nhối” trên. Không chỉ là cầu nối giữa các nguồn dữ liệu nhỏ lẻ, rời rạc, tích hợp dữ liệu mang lại lợi ích to lớn trong các quyết định toàn diện và tiềm năng của doanh nghiệp.

Cùng FPT Cloud tìm hiểu về các phương pháp tích hợp dữ liệu hiệu quả trong bài viết dưới đây!

Tích hợp dữ liệu là gì?

Tích hợp dữ liệu (Data Integration), là quá trình tạo cầu nối, gắn kết các nguồn dữ liệu rời rạc, phi tập trung để tạo thành một thể thống nhất. Với phương pháp này, doanh nghiệp hoạt động triển khai toàn bộ dữ liệu trên một nền tảng thống nhất. Trong đó, người dùng có thể truy vấn dữ liệu trên một hệ thống đồng bộ, liền mạch từ nhiều nguồn khác nhau một cách dễ dàng.

Tích hợp dữ liệu là tương lai của hoạt động quản lý tổng thể và lưu trữ dữ liệu an toàn trong mọi tổ chức. Không chỉ hỗ trợ các doanh nghiệp trong hoạt động quản lý, khai thác tối đa dữ liệu hiệu quả, tích hợp dữ liệu còn cải thiện khả năng phân tích, ghép nối thông tin các phòng ban và mang lại rất nhiều lợi ích to lớn trong hoạt động bảo mật, vận hành của doanh nghiệp.

Hãy hình dung bạn đang làm việc với một hệ thống “hỗn độn” gồm báo cáo Excel, bảng tính Access, và tập tin CSV… Các số liệu thống kê từ các nguồn trên lại lẻ tẻ, không được tổng hợp trực quan dẫn tới hệ quả nhà quản trị đưa ra các đánh giá thiếu bao quát và dự đoán có tính chính xác thấp.

Việc tích hợp dữ liệu sẽ giúp bạn dọn dẹp “chiến trường” và sắp xếp các thông tin một cách có trật tự, khoa học và hơn hết là tích hợp trên một nền tảng, giúp bạn dễ dàng tìm kiếm, phân tích và trích xuất dữ liệu khi cần thiết.

Phân biệt Data Integration và Application Integration

Tích hợp dữ liệu (Data Integration) và tích hợp ứng dụng (Application Integration) đều là những kỹ thuật quan trọng được sử dụng cho doanh nghiệp trong hành trình chuyển đổi số. Vậy đâu là phương pháp phù hợp cho doanh nghiệp của bạn? Hãy cùng Gimasys khám phá sự khác biệt giữa hai kỹ thuật này:

Data IntegrationApplication IntegrationMục tiêuTập hợp dữ liệu từ các nguồn khác nhau thành một dạng thống nhất. Điều này cho phép người dùng có cái nhìn toàn cảnh về dữ liệu và hỗ trợ tạo ra các báo cáo, phân tích chi tiết hơn.Kết nối các ứng dụng, nền tảng trong hay ngoài hệ thống để chúng có thể trao đổi dữ liệu và hoạt động cùng nhau. Điều này giúp tự động hóa quy trình và cải thiện hiệu quả hoạt động.Nguyên lý hoạt độngDữ liệu được trích xuất từ các nguồn khác nhau (cơ sở dữ liệu, bảng tính, CRM), được chuyển đổi thành một định dạng chung và sau đó được tải vào một kho lưu trữ tập trung (như data warehouse, data lake).Các ứng dụng được kết nối với nhau thông qua các API (Giao diện lập trình ứng dụng) hoặc các giao thức khác. Điều này cho phép các ứng dụng truyền dữ liệu theo thời gian thực (real-time) và hành động ngay với thiết lập được cài đặt sẵn.Ứng dụngThường được sử dụng cho hoạt động phân tích kinh doanh (BI), báo cáo và học máy.Thường được sử dụng để tự động hóa các quy trình làm việc, chẳng hạn như xử lý đơn hàng, quản lý khách hàng và tích hợp chuỗi cung ứng.

Tại sao doanh nghiệp nên triển khai tích hợp dữ liệu?

Trong thời đại của dữ liệu lớn (Big Data), các bộ dữ liệu khổng lồ đã, đang và sẽ trở thành “mỏ vàng” quý giá, giúp doanh nghiệp đưa ra các quyết định quản trị kinh doanh sáng suốt và xây dựng được lợi thế cạnh tranh trong ngành. Một doanh nghiệp nếu biết tận dụng triệt để dữ liệu: từ tập hợp, liên kết, tới phân tích và ứng dụng chúng trong hoạt động kinh doanh, sẽ đi nhanh hơn những đối thủ của mình “một bước”.

Data Integration, tích hợp dữ liệu, là một trong những giải pháp trọng yếu giúp doanh nghiệp khai thác dữ liệu hiệu quả. Không chỉ hỗ trợ truy vấn trong bộ dữ liệu “khổng lồ”, tích hợp dữ liệu mang lại nhiều lợi ích cho doanh nghiệp trọng hoạt động kinh doanh thông minh, phân tích dữ liệu khách hàng. Ngoài ra, khi tích hợp dữ liệu trên một nền tảng thống nhất, doanh nghiệp có thể làm giàu cho kho lưu trữ dữ liệu (Data Warehouse) và cung cấp các thông tin cụ thể theo mốc thời gian thực.

Ngoài Big Data, chuyển đổi số cũng là xu hướng tất yếu và là điều kiện tiên quyết để đánh giá một doanh nghiệp có tiềm năng phát triển hay không. Trong đó, tích hợp dữ liệu cũng là nhân tố nền tảng cho hoạt động chuyển đổi số của doanh nghiệp, giúp tự động hóa quy trình làm việc, tối ưu hóa vận hành và tạo ra trải nghiệm khách hàng xuất sắc.

Nói tóm lại, những giá trị mà Data Integration, tức tích hợp dữ liệu, đem lại cho người dùng là cực kỳ to lớn:

Phá vỡ rào cản thông tin, kết nối các nguồn dữ liệu rời rạc từ nhiều hệ thống khác nhau.

Quản lý, lưu trữ, kết nối dữ liệu thành một thể thống nhất.

Tự động hóa các quy trình thủ công, giúp doanh nghiệp tiết kiệm chi phí và nguồn lực.

Hỗ trợ báo cáo, nghiệp vụ thông minh và phân tích dữ liệu doanh nghiệp nâng cao.

Đưa ra bức tranh toàn cảnh về thị trường, giúp doanh nghiệp hiểu rõ về khách hàng.

Cung cấp nguồn dữ liệu chính xác, cập nhật chi tiết và đồng bộ các chỉ số cần thiết.

Kiểm soát phân quyền dữ liệu, nâng cao tính bảo mật và an toàn thông tin.

Ứng dụng của Data Integration trong doanh nghiệp

Dữ liệu bùng nổ, nhiều doanh nghiệp đã triển khai tích hợp dữ liệu trong hoạt động quản trị của mình. Trong đó, giải pháp được ứng dụng phổ biến nhất trong lĩnh vực Máy học, Phân tích dự đoán và Điện toán đám mây.

Máy học (Machine Learning)

Ngay từ tên gọi, Machine Learning đã cho thấy công nghệ này hoạt động hiệu quả nhất khi được học từ nguồn dữ liệu đa dạng, chất lượng và nhất quán. Nhắc tới máy học (ML), quá trình này liên quan tới việc đào tạo AI từ nguồn dữ liệu đầu vào, từ đó đưa ra các giải pháp phù hợp nhất cho người dùng.

Tuy nhiên, trên thực tế, dữ liệu thường bị phân tán, có đầu vào ở nhiều định dạng khác nhau. Điều này gây khó khăn cho máy học để cho ra những sản phẩm đầu ra chất lượng, đáp ứng nhu cầu và mong muốn của người dùng. Đây cũng chính là những thách thức mà tích hợp dữ liệu có thể giải quyết:

Nâng cao độ chính xác của mô hình: Dữ liệu được tích hợp và chuẩn hóa giúp mô hình học máy học được hiệu quả hơn, đưa ra dự đoán chính xác hơn.

Tăng tốc độ đào tạo mô hình: Việc truy cập và xử lý dữ liệu nhanh chóng giúp rút ngắn thời gian đào tạo mô hình, tiết kiệm chi phí và thời gian.

Cải thiện khả năng mở rộng: Khi tích hợp dữ liệu, doanh nghiệp có thể dễ dàng bổ sung các nguồn dữ liệu mới, cho phép mô hình học máy thích ứng và cập nhật liên tục.

Phân tích dự đoán (Predictive Analytics)

Phân tích dự đoán là công cụ đắc lực hỗ trợ doanh nghiệp dự đoán xu hướng, đưa ra quyết định phù hợp. Tuy nhiên, để có được dự đoán sát với thực tế nhất, doanh nghiệp cần cung cấp nguồn dữ liệu đầu vào chính xác và hữu ích cho quá trình phân tích.

Với tích hợp dữ liệu (Data Integration), nhà quản trị có thể kết nối các nguồn dữ liệu rời rạc, đa dạng từ nhiều hệ thống khác nhau như:

Cơ sở dữ liệu quan hệ (RDBMS)

Dữ liệu phi cấu trúc (Unstructured Data)

Dữ liệu cảm biến IoT (Internet of Things)

Dữ liệu từ các ứng dụng di động

Nhờ tích hợp dữ liệu, doanh nghiệp có thể thu thập và tổng hợp thông tin từ mọi khía cạnh của hoạt động kinh doanh, giúp nâng cao độ chính xác và hiệu quả của dự đoán. Bên cạnh đó, với dữ liệu đầu vào được sắp xếp khoa học và thống nhất, tốc độ phân tích sẽ được cải thiện và rút ngắn thời gian ra quyết định của nhà quản trị.

Đặc biệt, trong các tổ chức, doanh nghiệp ứng dụng công nghệ AI vào quá trình phân tích dữ liệu, việc tích hợp dữ liệu không chỉ đưa ra một đầu vào chất lượng mà còn cải thiện hiệu suất hoạt động của AI.

Chuyển đổi lên điện toán đám mây

Điện toán đám mây (Cloud Computing) là một trong những mô hình phổ biến được đa số các doanh nghiệp hiện nay sử dụng với khả năng mở rộng và truy cập dữ liệu mọi lúc mọi nơi. Tuy nhiên, việc di chuyển tất cả cơ sở dữ liệu từ hệ thống truyền thống lên đám mây đôi khi khá cồng kềnh và gây gián đoạn cho hoạt động vận hành của doanh nghiệp.

Tích hợp dữ liệu, trong đó có sử dụng phần mềm trung gian để dịch chuyển dữ liệu mà không gây gián đoạn, sẽ giúp doanh nghiệp giải quyết bài toán trên. Thay vì di chuyển tất cả dữ liệu cùng lúc, Data Integration cho phép doanh nghiệp thực hiện quá trình chuyển đổi một cách linh hoạt và hiệu quả:

Giảm thiểu gián đoạn hoạt động: Các phòng ban có thể tiếp tục hoạt động bình thường trong khi dữ liệu được di chuyển lên đám mây.

Tối ưu và tăng cường hiệu quả hoạt động: Tự động hóa nhiều quy trình thủ công, giúp tiết kiệm thời gian và chi phí.

Cải thiện bảo mật, khắc lục lỗ hổng quản lý: Đảm bảo dữ liệu được bảo mật và tuân thủ các quy định an toàn dữ liệu đề ra.

Những khó khăn doanh nghiệp thường gặp phải trong quá trình tích hợp dữ liệu

Tích hợp dữ liệu là một quá trình phức tạp, đòi hỏi doanh nghiệp cần chuẩn bị kỹ lượng và lên kế hoạch quản trị rủi ro trong quá trình phân luồng và thống nhất dữ liệu. Dưới đây là một số khó khăn nhà quản trị thường gặp phải khi triển khai tích hợp dữ liệu cho doanh nghiệp của mình:

Chất lượng dữ liệu không đạt chuẩn

Chất lượng dữ liệu ở đây được thể hiện ở 3 yếu tố, trong đó nếu thiếu 1 trong 3, kết quả thu về đều có thể bị ảnh hưởng và gây khó khăn cho doanh nghiệp trong quá trình thực thi:

Tính nhất quán: Dữ liệu từ các nguồn khác nhau có thể có các định dạng, đơn vị đo lường, mã hóa khác nhau, gây khó khăn cho doanh nghiệp trong hành trình thu thập, đối sánh và kết hợp.

Tính đầy đủ: Trên thực tế, không phải tệp dữ liệu nào cũng đầy đủ các trường quan trọng, dẫn tới khoảng trống trong phân tích dữ liệu và dẫn tới kết quả thiếu chính xác.

Tính đúng đắn: Dữ liệu có thể chứa các lỗi nhập liệu hoặc các sai sót khác ảnh hưởng đến độ chính xác của kết quả.

Tính phức tạp khi làm việc với hệ thống

Trong quá trình tích hợp, nhà quản trị đòi hỏi phải cập nhật kiến thức và đưa ra các phương án phù hợp khi xử lý nhiều nguồn dữ liệu khác nhau:

Số lượng nguồn dữ liệu lớn: Việc quản lý và kết nối nhiều nguồn dữ liệu khác nhau đòi hỏi nhiều tài nguyên, thời gian và các nỗ lực từ nhiều bộ phận. Do vậy, nhà quản trị cần nghiên cứu và đưa ra các phương án phòng ngừa theo cố vấn từ các chuyên gia trong ngành công nghệ thông tin.

Cấu trúc dữ liệu phức tạp: Các hệ thống kế thừa (Legacy Systems) có thể có cấu trúc dữ liệu phức tạp và gây khó khăn cho người dùng trong quá trình sử dụng. Vì vậy, hãy đảm bảo mọi nhân viên trong công ty có thể nắm được các vận hành và nguyên lý sử dụng phần mềm.

Tiêu tốn nhiều chi phí và thời gian trong giai đoạn đầu triển khai

Quá trình tích hợp dữ liệu là một hành trình dài hạn đòi hỏi doanh nghiệp cần kiên trì và tiêu tốn nhiều nguồn lực (phần cứng, phần mềm, chi phí nhân lực) hay thời gian triển khai. Lưu ý rằng tiến độ kế hoạch có thể kéo dài hơn dự kiến hay tốn kém trong đầu tư vào các công cụ, phần mềm phục vụ việc chuyển đổi.

Các phương pháp tích hợp dữ liệu

Gộp dữ liệu (Data Federation)

Phương pháp này hoạt động dựa trên nguyên lý trích xuất, làm sạch và lưu trữ dữ liệu vật lý tại một vị trí duy nhất. Điều này cho phép nhiều cơ sở dữ liệu hoạt động như một, cung cấp một nguồn dữ liệu duy nhất cho các ứng dụng front-end. Cơ chế này sẽ cắt giảm chi phí cơ sở hạ tầng dữ liệu, chi phí lưu trữ. Tuy nhiên tồn tại nhược điểm là hiệu suất truy cập có thể chậm hơn, yêu cầu truy vấn phức tạp hơn.

Sao chép dữ liệu (Data Replication)

Phương pháp này tạo ra các bản sao toàn bộ hay một phần dữ liệu từ kho lưu trữ gốc sang kho đích, trong đó tạo ra dữ liệu trùng lặp thay vì di chuyển cồng kềnh qua các hệ thống khác nhau. Giải pháp này sẽ khá phù hợp với các doanh nghiệp vừa và nhỏ, có nguồn dữ liệu hạn chế do nhược điểm tốn thêm chi phí lưu trữ, tiềm ẩn nhiều nguy cơ sai lệch dữ liệu hoặc thiếu đồng bộ trên toàn hệ thống.

Ảo hóa dữ liệu (Data Virtualization)

Tương tự như sao chép dữ liệu, phương pháp ảo hóa nói không với việc di chuyển dữ liệu giữa các hệ thống. Việc ảo hóa dữ liệu sẽ tạo ra một lớp xem ảo, trích xuất dữ liệu từ tất cả các nguồn trong hệ thống quản lý của doanh nghiệp.

Tại đây, người dùng truy cập dữ liệu thông qua một giao diện thống nhất mà không cần biết chi tiết về nguồn gốc dữ liệu. Phương pháp này khá linh hoạt, dễ dàng mở rộng và có thể truy cập dữ liệu nhanh chóng. Tuy nhiên một hạn chế tồn đọng đó là sự phức tạp của chúng trong hoạt động triển khai, đòi hỏi công nghệ cao và nguồn lực lớn. Do vậy, chi phí sẽ phù hợp nhất với các doanh nghiệp lớn, có nguồn lực đủ mạnh.

Liên kết dữ liệu (Data Linking)

Phương pháp này tạo một hệ thống cơ sở dữ liệu ảo trên nhiều nguồn dữ liệu và hoạt động tương tự như Data Virtualization. Chúng tạo ra mối liên hệ giữa các bản ghi dữ liệu từ các nguồn khác nhau dựa trên các thuộc tính chung. Chính vì vậy, để triển khai phương án tích hợp dữ liệu này, doanh nghiệp cần phân loại và sắp xếp dữ liệu có nguồn tương ứng. Ngoài ra, có thể gặp khó khăn với dữ liệu phi cấu trúc.

Giải bài toán dữ liệu hiệu quả cho tổ chức Việt với nền tảng toàn diện FPT Cloud Data Platform

FPT Cloud Data Platform là một giải pháp công nghệ toàn diện được triển khai trên cơ sở hạ tầng đám mây để quản lý, lưu trữ, xử lý và phân tích dữ liệu. Đây là một môi trường tích hợp cho phép các doanh nghiệp dễ dàng làm việc với dữ liệu từ nhiều nguồn khác nhau, cung cấp khả năng mở rộng linh hoạt và truy cập từ bất kỳ đâu. FPT Cloud Data Platform có khả năng bao quát các bài toán lớn về dữ liệu của các cơ quan, tổ chức với 4 giải pháp chính từ: Kết nối và tổng hợp dữ liệu nhiều nguồn; Lưu trữ dữ liệu, xử lý dữ liệu; Khai phá và trực quan hóa dữ liệu.

Nhờ khả năng cho phép kết nối dữ liệu từ đa nguồn mà không cần phụ thuộc đơn vị quản lý nguồn dữ liệu gốc, không làm gián đoạn vận hành hệ thống hiện tại, FPT Cloud Data Platform giúp các tổ chức duy trì kết nối, liên thông CSDL dùng chung và cung cấp dịch vụ tới các cấp liên tục, hiệu quả.

Liên hệ với chúng tôi để được tư vấn chi tiết và dùng thử giải pháp FPT Cloud Data Platform Tại đây

Hotline: 1900 638 399

Email: [email protected]

Support: m.me/fptsmartcloud

Bản tin: Doanh nghiệp & Công Nghệ ngày 26.08.2024

13:32 10/09/2024

Tiêu điểm

FPT AI Mentor được vinh danh giải pháp trí tuệ nhân tạo xuất sắc năm 2024

Vượt qua hơn 70 đối thủ dự thi, giải pháp nâng cao chất lượng nguồn nhân lực FPT AI Mentor được vinh danh là “Giải pháp Trí tuệ nhân tạo xuất sắc 2024” (AI Awards). Với khả năng cá nhân hóa đào tạo nhờ phương pháp Adaptive Micro-learning, FPT AI Mentor là trợ thủ đắc lực giúp nhân viên cải thiện kiến thức, năng lực, từ đó tăng năng suất và hiệu quả vận hành cho doanh nghiệp.

Xem thêm

Cloud cho chuyển đổi số

FPT Unify Portal ra mắt tính năng Budget Alert giúp kiểm soát chi phí hiệu quả

Khám phá nền tảng xử lý dữ liệu đầu tiên dành riêng cho doanh nghiệp Việt

Tính năng Budget Alert mới cho phép người dùng có thể triển khai hệ thống cảnh báo ngân sách chủ động dựa trên thiết lập thời gian, ngân sách, dịch vụ liên quan trên FPT Unify Portal.

Xem thêm

FPT Cloud Data Platform là nền tảng xử lý và lưu trữ dữ liệu toàn diện đầu tiên giúp doanh nghiệp Việt có thể khai thác hiệu quả giá trị mà dữ liệu mang lại, từ đó tạo lợi thế cạnh tranh trên thị trường.

Xem thêm

Doanh nghiệp chuẩn bị gì cho chuyển đổi BCTC chuẩn IFRS: Thời gian đã cạn?

Tin bảo mật tháng 8 chuyển đổi BCTC chuẩn IFRS: Thời gian đã cạn?

Chỉ còn 5 tháng nữa, đến hạn áp dụng chuẩn mực BCTC IFRS bắt buộc tại Việt Nam. Liệu doanh nghiệp đã chuẩn bị sẵn nguồn lực con người, kiến thức và cả các giải pháp công nghệ cho việc áp dụng chuẩn mực này?

Xem thêm

Bài viết tổng hợp các lỗ hổng bảo mật được công bố bởi các ông lớn công nghệ như Microsoft, Linux, Vmware cùng những khuyến nghị từ chuyên gia an toàn thông tin của FPT Cloud và những sự kiện an ninh mạng đáng chú ý diễn ra trong tháng 8.

Xem thêm

AI trong doanh nghiệp

FPT.AI gây dấu ấn đặc biệt tại thị trường Indonesia

FPT cam kết thúc đẩy AI có chủ quyền tại Việt Nam

Sau khi mở rộng hoạt động kinh doanh tại thị trường lớn nhất Đông Nam Á, bộ giải pháp FPT AI đã bắt tay hợp tác với nhiều doanh nghiệp lớn bằng những ưu điểm vượt trội trong trải nghiệm khách hàng hàng, tối ưu vận hành và thúc đẩy kinh doanh.

Xem thêm

Ông Lê Hồng Việt - CEO, FPT Smart Cloud tại sự kiện AI4VN 2024 vừa qua đã khẳng định: “Chiến lược thúc đẩy AI có chủ quyền sẽ giúp Việt Nam tăng năng lực cạnh tranh quốc gia thông qua tăng năng suất lao động và tự động hóa.”

Xem thêm

AI là yếu tố quyết định sức cạnh tranh của các nền kinh tế trong tương lai

Vietcombank tự động hoá chăm sóc khách hàng bằng FPT AI Chat

Với quy mô giá trị thị trường lên tới hơn 1800 tỷ USD vào năm 2030, AI đang là “cuộc đua nóng” giữa các nền kinh tế lớn, đặc biệt trong việc đầu tư nghiên cứu và làm chủ công nghệ.

Xem thêm

Trợ lý ảo thông minh được phát triển bởi FPT Smart Cloud trên nền tảng FPT.AI mang tên VCB Digibot là “mảnh ghép” quan trọng, giúp Vietcombank dần hoàn thiện bức tranh số hóa tổng thể và toàn diện.

Xem thêm

Tin FPT Smart Cloud

FPT cam kết đẩy mạnh đầu tư vào AI, đưa Việt Nam tiến sâu vào kỷ nguyên trí tuệ nhân tạo

FPT Smart Cloud đồng hành cùng cộng đồng lập trình viên, khai phá tiềm năng các công nghệ lõi

Nhờ sự đầu tư nghiêm túc về mặt công nghệ, FPT đang ngày càng tiến sâu hơn vào sân chơi của các "đại gia" trên thế giới với vai trò một công ty tư vấn và cung cấp các giải pháp dịch vụ chuyển đổi số toàn diện.

Xem thêm

Tại sự kiện Google I/O Extended Cloud Hanoi 2024, FPT Smart Cloud khiến cộng đồng công nghệ “dậy sóng” với phiên trình bày của PGS.TS Ngô Xuân Bách - Giám đốc khối sản phẩm AI về AI tạo sinh và xu hướng AI-Powered Cloud.

Xem thêm

Tư vấn từ chuyên gia hàng đầu theo nhu cầu doanh nghiệp!

Liên hệ ngay

Chủ động ứng phó với các cuộc tấn công mạng leo thang

10:00 06/09/2024

Đối mặt với tấn công ransomware, các biện pháp bảo mật là chưa đủ. Doanh nghiệp cần triển khai các giải pháp sao lưu hiệu quả để đảm bảo an toàn và toàn vẹn dữ liệu.

Doanh nghiệp có thực sự khôi phục sau khi đóng tiền chuộc?

Trong bối cảnh số hóa ngày càng mạnh mẽ, ransomware hay còn gọi là tấn công mã hóa dữ liệu không chỉ là một mối đe dọa mà còn là một đại dịch ngày càng nghiêm trọng với các cuộc tấn công gia tăng và ngày càng tinh vi. Nhiều doanh nghiệp vẫn cho rằng nếu bị tấn công thì việc trả tiền chuộc có thể giúp phục hồi dữ liệu bị đánh cắp, nhưng thực tế cho thấy điều này không phải lúc nào cũng đúng.

Báo cáo ransomware 2022 của công ty bảo mật Sophos, dựa trên khảo sát hơn 5.600 quản lý IT tại 31 quốc gia, 46% cho biết đã chấp nhận trả tiền để lấy lại dữ liệu. Tuy nhiên, chỉ 4% công ty trong số này khôi phục được toàn bộ dữ liệu, còn gần một nửa chỉ lấy lại được 61% dữ liệu.

Quy trình xử lý khi bị ransomware trước giai đoạn phục hồi, doanh nghiệp phải thực hiện bước rà soát tổng thể để đảm bảo tạo ra một môi trường mạng sạch. Các đơn vị sẽ phải tìm và vá lỗ hổng trên hệ thống, rà soát kỹ từng máy chủ và đưa từng thành phần hoạt động trở lại, sau khi đã bổ sung các phương án phòng thủ cần thiết. Đây cũng là lý do khiến việc mở khóa thường tốn nhiều thời gian, trong thời gian đó hệ thống sẽ phải tạm dừng hoạt động và vô hình chung gây gián đoạn vận hành doanh nghiệp.

Trước tình hình đó, Cục An toàn thông tin đã nhấn mạnh tầm quan trọng của việc thiết lập hệ thống sao lưu dữ liệu an toàn trong Cẩm nang Phòng chống, giảm thiểu rủi ro từ tấn công Ransomware cho doanh nghiệp. Việc xây dựng một hệ thống sao lưu và phục hồi dữ liệu hiệu quả trở thành ưu tiên hàng đầu của doanh nghiệp. Đặc biệt, đối với các doanh nghiệp có lượng thông tin dữ liệu lớn và trực tiếp ảnh hưởng đến hoạt động kinh doanh như sản xuất, bán lẻ, logistics, ngân hàng, tài chính…

[caption id="attachment_51845" align="aligncenter" width="800"] Đại dịch ransomware thách thức doanh nghiệp không thể xem thường[/caption]

Cách thức sao lưu hiệu quả, an toàn

Thực tế cho thấy, việc sao lưu dữ liệu an toàn không chỉ đơn giản là sao chép dữ liệu từ một hệ thống sang một hệ thống khác. Đó là một quy trình đòi hỏi tính chiến lược, sự cẩn trọng và tuân thủ các tiêu chuẩn bảo mật cao. Để đảm bảo việc sao lưu dữ liệu hiệu quả và an toàn, doanh nghiệp cần xem xét các yếu tố như: tần suất, phương thức, vị trí và bảo mật trong suốt quá trình sao lưu.

Doanh nghiệp cần thực hiện sao lưu dữ liệu thường xuyên để đảm bảo rằng bất kỳ thay đổi nào trên hệ thống cũng đều được lưu trữ một cách kịp thời. Tùy thuộc vào mức độ quan trọng của dữ liệu và hoạt động của doanh nghiệp, tần suất sao lưu có thể dao động từ hàng ngày, hàng giờ đến thời gian thực. Ví dụ, trong các ngành tài chính và ngân hàng, dữ liệu giao dịch thường được sao lưu liên tục để đảm bảo không có thông tin quan trọng nào bị mất.

Một trong những phương pháp sao lưu hiệu quả và được khuyến nghị rộng rãi nhất là nguyên tắc 3-2-1; cụ thể: duy trì 3 bản sao dữ liệu, dùng 2 phương thức lưu trữ khác nhau và duy trì 1 bản sao bên ngoài hạ tầng chính.

Bên cạnh đó, việc chọn lựa và sử dụng dịch vụ sao lưu, khôi phục dữ liệu từ các nhà cung cấp uy tín, có nhiều kinh nghiệm cũng là một yếu tố quan trọng để đảm bảo việc vận hành liên tục và chủ động trước các tình huống có thể xảy ra.

Tiến hành sao lưu đồng thời đảm bảo vận hành kinh doanh

Tuy nhiên, nhiều doanh nghiệp vẫn chần chừ trước việc triển khai dịch vụ sao lưu do một số rào cản như việc sợ gián đoạn hoạt động kinh doanh khi thực hiện công tác sao lưu, khó ước tính quy mô chi phí, thời gian của công tác sao lưu, thiếu thông tin để lựa chọn các nhà cung cấp dịch vụ uy tín.

Một doanh nghiệp trong lĩnh vực bán lẻ sở hữu hơn 28.000 điểm bán, gần 6.000 siêu thị và cửa hàng tiện lợi đã chia sẻ câu chuyện của họ về việc triển khai giải pháp sao lưu và phục hồi dữ liệu của chính doanh nghiệp. Sau quá trình khảo sát và tư vấn từ chuyên gia và kĩ sư của FPT Cloud, doanh nghiệp đã dịch chuyển toàn bộ hệ thống công nghệ thông tin đang có từ môi trường Datacenter hiện tại lên môi trường đám mây FPT Cloud, đồng thời triển khai giải pháp sao lưu dữ liệu, xây dựng hệ thống dự phòng thảm họa trên Cloud với cấu trúc vùng.

Chỉ với 14 ngày triển khai thần tốc, hệ thống đã đảm bảo dữ liệu luôn được sao lưu, dự phòng để hoạt động liên tục 24x7x365, không gián đoạn trước mọi sự cố như tấn công mã hóa, thiên tai… đáp ứng sự bùng nổ trong phát triển và mở rộng sản xuất.

[caption id="attachment_51846" align="aligncenter" width="800"] Tăng cường sức mạnh ứng phó ransomware với FPT Cloud Backup & DR[/caption]

Tiếp tục đồng hành cùng doanh nghiệp trong quá trình chủ động ứng phó và đảm bảo an toàn dữ liệu, FPT triển khai chương trình "Ưu đãi lên đến 30% chi phí sao lưu/ khôi phục dữ liệu, hỗ trợ 03 tháng chi phí dịch vụ Backup/ DR cho khách hàng đăng ký dịch vụ 12 tháng". Nhận ngay ưu đãi tại ĐÂY.

Kafka là gì? Giới thiệu tổng quan về Kafka chi tiết từ A – Z

17:26 11/08/2024

Hiện nay, Kafka được hơn 80% trong số Fortune 100 sử dụng bởi rất nhiều ưu điểm vượt trội. Nó được ứng dụng trong hầu hết mọi ngành nghề phù hợp với quy mô từ lớn đến nhỏ. Vậy Kafka là gì? Nguyên lý hoạt động của Kafka như thế nào? Tất cả sẽ có trong chia sẻ dưới đây của chúng tôi.

>>> Xem thêm: Dịch vụ cho thuê VPS tốc độ cao giá rẻ, uy tín tại FPT Cloud

1. Kafka là gì?

Kafka là một nền tảng message publish/subscribe phân tán có nguồn mở được phát triển để xử lý khối lượng lớn dữ liệu trong thời gian thực (streaming real-time). Hiện Kafka đã trở thành một công cụ quan trọng cho các nguồn cấp dữ liệu hiện đại bởi nó giúp truyền dữ liệu giữa các ứng dụng và phân tích dữ liệu chính xác dẫn đến quyết định cách chia sẻ dữ liệu đó.

Như bạn đã biết, Real-time data có giá trị đặc biệt quan trọng như thế nào đối với các tổ chức, doanh nghiệp. Real-time data được sử dụng để cải thiện dịch vụ người dùng, quản lý sản phẩm và hướng đến tối ưu quá trình vận hành. Và Kafka có khả năng truyền một lượng lớn messgae thời gian thực. Ngay cả khi chưa nhận được thông tin, nó vẫn sẽ được lưu trữ trong hàng đợi để đảm bảo an toàn dữ liệu.

Năm 2011, Linkedin phát triển Kafka để xử lý các nguồn cấp dữ liệu theo thời gian thực. Sau đó trở thành dự án mã nguồn mở của Apache. Và đến nay, Kafka được phân phối chính thức nhất bởi Confluent thông qua Confluent Platform.

[caption id="attachment_38684" align="aligncenter" width="800"] Kafka là một nền tảng message publish/subscribe phân tán có nguồn mở được phát triển[/caption]

2. Kafka dùng để làm gì?

Để hiểu hơn về Kafka hãy xem những tính năng mà Kafka mang lại ngay nhé!

Đo lường

Kafka được sử dụng phổ biến để xây dựng dữ liệu giám sát các hoạt động. Nói cách khác, Kafka phù hợp việc tập hợp số liệu thống kê từ nhiều nguồn phân tán trên trang để tạo ra một nguồn dữ liệu tổng hợp.

Tạo log

Kafka cũng được dùng như một công cụ hỗ trợ tổng hợp log hoặc nhật ký hoạt động, tóm tắt các chi tiết và cung cấp bản ghi về dữ liệu sự kiện nhằm phục vụ cho việc xử lý trong tương lai.

Stream processing

Tiếp theo, Kafka được sử dụng để xử lý dữ liệu theo thời gian thực. Ngay khi có dữ liệu mới được cập nhật vào topic thì sẽ được ghi vào hệ thống tức thì và truyền đến bên nhận dữ liệu. Đặc biệt, thư viện Kafka Streams được tích hợp từ phiên bản 0.10.0.0 với tính năng xử lý stream nhẹ nhưng rất nhanh chóng.

Event Streaming

Event Streaming là tính năng được khai thác phổ biến hiện nay của Kafka. Theo đó, thu thập dữ liệu dưới dạng những luồng event real-time từ cơ sở dữ liệu, cảm biến hay từ các thiết bị di động và lưu trữ chúng trong một thời gian nhất định để thực hiện truy xuất về sau, phân tích, xử lý các luồng sự kiện trong real-time và định tuyến chúng đến các công nghệ đích khác nhau trong trường hợp cần thiết.

Lưu trữ các stream of record theo thứ tự

Kafka thực hiện lưu trữ message (bao gồm cả những message đã được gửi đi). Khi đó, những dữ liệu này có thể được dùng để truy xuất lại, re-consumed hay re-subscribe theo nhu cầu.

Ngoài message, Kafka còn có thể lưu trữ lượng lớn thông tin dữ liệu khác để tạo thành kho data. Thậm chí nhiều đơn vị còn sử dụng Kafka để thu thập xử lý luồng dữ liệu thời gian thực bên cạnh việc lưu trữ những dữ liệu theo phương thức thụ động. Đây là sự khác biệt của Kafka so với các hệ thống phân tán khác.

Với tính năng này, lượng dữ liệu được Kafka được lưu trữ là vô cùng lớn phù hợp để xây dựng với những công nghệ tầm cơ như Machine Learning hay Trí tuệ nhân tạo AI.

Đóng vai trò như message broker

Kafka hoàn toàn có thể được sử dụng để thay thế cho các Message Broker, ví dụ như ActiveMQ hoặc RabbitMQ.

Quản lý hoạt động website

[caption id="attachment_38686" align="aligncenter" width="800"] Quản lý hoạt động website[/caption]

Đây là cách sử dụng Kafka phổ biến nhất hiện nay. Với Kafka bạn có thể xây dựng website và đăng tải nội dung theo thời gian thực. Tất cả các dữ liệu quan trọng như lượt xem trang, hoạt động tìm kiếm…đều được tạo thành các topic. Quá trình quản lý hoạt động này giúp phân tích hành vi của người dùng trên trang tốt hơn. Từ đó có được giải pháp phù hợp đáp ứng thị hiệu của người dùng và thu hút được nhiều người đọc hơn.

Ngoài ra, Kafka còn được sử dụng để:

Publish và subscribe các stream of record

Hỗ trợ xử lý stream of record theo thời gian thực

>>> Xem thêm: Public Cloud là gì? Phân biệt Public Cloud & Private Cloud từ A - Z

3. Nguyên lý hoạt động của Kafka

Kafka hoạt động dựa trên sự kết hợp của 2 mô hình chính gồm queuing và publish-subscribe. Trong đó:

Queuing cho phép dữ liệu có thể được xử lý phân tán trên nhiều consumer và tạo ra khả năng mở rộng cao.

Publish-subscribe tiếp cận cùng lúc nhiều subscribe và các message sẽ được gửi đến nhiều subscribe tuy nhiên không thể sử dụng để phân tán công việc cho nhiều worker.

[caption id="attachment_38687" align="aligncenter" width="800"] Nguyên lý hoạt động của Kafka[/caption]

4. Ưu nhược điểm của Apache Kafka

Nhìn chung, bất kỳ công ty nào cần xử lý và phân tích khối lượng lớn dữ liệu thời gian thực đều có thể hưởng lợi từ việc sử dụng Apache Kafka. Đến nay đã có hàng ngàn tổ chức khác nhau sử dụng Kafka từ những gã khổng lồ Internet cho đến những nhà sản xuất ô tô lớn, sàn giao dịch chứng khoán,…Theo ghi nhận mới nhất, Kafka có hơn 5 triệu lượt tải xuống.

[caption id="attachment_38688" align="aligncenter" width="800"] Ưu nhược điểm của Apache Kafka[/caption]

Dưới đây là một số ưu, nhược điểm Kafka bao gồm:

4.1 Ưu điểm

Hiệu suất cao: Kafka hỗ trợ nền tảng xử lý tin nhắn với tốc độ rất cao, cụ thể tốc độ xử lý có thể vượt quá 100k/giây (độ trễ thấp). Đặc biệt, Kafka có khả năng duy trì hiệu suất ổn định với khối lượng dữ liệu cực lớn. Tất cả dữ liệu được xử lý và sắp xếp khoa học theo kiểu phân vùng và thứ tự.

Khả năng mở rộng: Kafka là một hệ thống phân tán có khả năng xử lý khối lượng dữ liệu lớn có thể mở rộng nhanh chóng mà không có thời gian chết. Nó cung cấp khả năng mở rộng bằng cách cho phép các phân vùng được phân phối trên các máy chủ khác nhau.

Khả năng chịu lỗi: Kafka là một hệ thống phân tán bao gồm một số nút chạy cùng nhau để phục vụ hoạt động của nhóm. Quy tắc này làm cho nó có khả năng hoạt động tốt ngay cả khi có nút bị lỗi hoặc lỗi máy cục bộ.

Độ bền: Hệ thống Kafka có độ bền cao.

Khả năng truy cập dễ dàng: Bất kỳ ai cũng có thể dễ dàng truy cập dữ liệu.

Loại bỏ nhiều tích hợp: Nó loại bỏ nhiều tích hợp nguồn dữ liệu vì tất cả dữ liệu của nhà sản xuất đều chuyển đến Kafka. Điều này làm giảm sự phức tạp, thời gian và chi phí.

[caption id="attachment_38689" align="aligncenter" width="800"] Khả năng chịu lỗi[/caption]

4.2 Nhược điểm

Kafka không hoàn hảo, nó vẫn còn tồn tại một số hạn chế nhất định như:

Không phù hợp với dữ liệu lịch sử: Hệ thống Kafka chỉ cho phép lưu trữ dữ liệu lịch sử trong một vài giờ đồng hồ.

Đôi khi xảy ra tình trạng xử lý chậm: Hệ thống Kafka sẽ trở nên chậm khi số lượng hàng đợi trong một cụm tăng lên từ đó ảnh hưởng đến hiệu suất chung.

Thiếu công cụ giám sát: Hệ thống Kafka không có bộ công cụ giám sát và quản lý hoàn chỉnh. Để khắc phục điều này, chúng ta có thể sử dụng các công cụ của bên thứ ba như Kafka Monitor (được phát triển bởi Linkedin), Datadog và Prometheus giúp giám sát các cụm Kafka. Ngoài ra, có nhiều tùy chọn mã nguồn mở và thương mại khác cũng có sẵn.

Không hỗ trợ chủ đề ký tự đại diện: Hệ thống Kafka chỉ hỗ trợ tên chủ đề chính xác và sẽ không hỗ trợ các chủ đề ký tự đại diện.

Ví dụ: Nếu bạn có chủ đề metric_2022_01_01 & metric_2022_01_02, thì chủ đề đó sẽ không hỗ trợ lựa chọn chủ đề ký tự đại diện như metric_2022_*.

Xử lý chưa linh hoạt: Đôi khi số lượng Queues trong Cluster của Kafka tăng lên thì hệ thống có hiện tượng xử lý chậm chạp và kém nhạy bén hơn.

>>> Xem thêm: Dropbox Là Gì? Hướng dẫn sử dụng Dropbox lưu trữ, sao lưu và chia sẻ dữ liệu

4.3 Những lý do nên sử dụng Kafka

Kafka là dự án mã nguồn mở được đóng gói hoàn chỉnh với hiệu năng sử dụng tốt đặc biệt dễ dàng mở rộng mà không ảnh hưởng đến hoạt động của hệ thống. Đặc biệt Kafka cũng được đánh giá rất cao về khả năng chịu lỗi.

[caption id="attachment_38690" align="aligncenter" width="800"] Những lý do nên sử dụng Kafka[/caption]

Nếu bạn đang xây dựng phần mềm hoặc website hiển thị thông tin theo thời gian thực thì Kafka là lựa chọn tối ưu. Một số lý do mà bạn nên sử dụng Kafka ngay hôm nay có thể kể đến như:

Kafka có khả năng mở rộng cao: Các cụm Kafka có quy mô lên tới một nghìn brokers, hàng nghìn tỷ messages mỗi ngày, hàng petabyte dữ liệu, hàng trăm nghìn phân vùng. Theo đó, mô hình phân vùng nhật ký của Kafka cho phép dữ liệu có thể được phân phối trên nhiều máy chủ và mở rộng không giới hạn máy chủ khi có nhu cầu.

Kafka có tốc độ nhanh chóng: Việc xử lý thông qua tách các luồng dữ liệu giúp cho tốc độ của Kafka trở nên nhanh hơn. Kafka có thể xử lý hàng triệu messages mỗi giây.

Kafka có khả năng chịu lỗi và độ bền: Do các gói dữ liệu được sao chép và phân phối trên nhiều máy chủ khác nhau, nên khi có sự cố thì dữ liệu được lưu trữ an toàn và sẽ ít gặp lỗi hơn.

5. Ứng dụng của Kafka trong thực tế

Kafka sở hữu khả năng xử lý, lưu trữ dữ liệu lớn theo thời gian thực nhanh chóng và chính xác. Bởi vậy đây là công cụ lý tưởng được hàng ngàn doanh nghiệp, tổ chức hoạt động trong nhiều ngành nghề khác nhau áp dụng rộng rãi. Dưới đây là một số trường hợp sử dụng phổ biến Kafka trong ngành nghề của mình.

5.1 Kafka trong lĩnh vực Logistic

[caption id="attachment_38691" align="aligncenter" width="800"] Kafka trong lĩnh vực Logistic[/caption]

Như bạn đã biết, dữ liệu tại các công ty vận chuyển logistic lớn đến như thế nào. Đặc biệt khi phải xử lý lượng đơn hàng khổng lồ mỗi ngày đến từ những nền tảng thương mại điện tử Ecommerce lớn. Thậm chí trong các thời gian diễn ra chương trình khuyến mãi, ưu đãi, giảm giá lớn trong năm lượng data càng khổng lồ.

Và công nghệ Kafka hoàn toàn có thể gánh vác xử lý kho dữ liệu thời gian thực (data real-time). Theo đó giúp quá trình hoạt động của Logistic được diễn ra trơn tru và đảm bảo không bị tắc nghẽn.

5.2 Kafka trong lĩnh vực Y học

Hiện nay, Kafka đang dần trở nên phổ biến trong lĩnh vực Y tế cộng đồng. Bên cạnh việc xử lý chính xác lượng thông tin lớn, Kafka còn giúp xếp xếp và phân loại dữ liệu một cách khoa học, theo thứ tự nhất định giúp quá trình khám chữa bệnh diễn ra thuận lợi hơn.

Trong đó bao gồm cả việc khai xây dựng những cảm biến theo dõi tình trạng bệnh nhân bao gồm các thông số nhịp tim, huyết áp hay thần kinh để từ đó có thể giám sát sức khỏe người bệnh và đưa ra phác đồ điều trị cũng như những phản hồi chữa trị kịp thời, đúng đắn.

5.3 Kafka trong lĩnh vực Marketing

Với Marketing, Kafka được khai thác tối đa những tính năng tối ưu. Theo đó, các công ty truyền thông có thể sử dụng Kafka để lưu trữ dữ liệu về nhân khẩu học, hành vi sử dụng trên mạng xã hội, trang mạn và các công cụ tìm kiếm. Từ đó tạo ra các mẫu quảng cáo phù hợp với nhu cầu của khách hàng.

Ví dụ: Người dùng A đang tìm kiếm thông tin về sản phẩm kem chống nắng trên công cụ tìm kiếm. Thông tin này sẽ được hệ thống lưu lại và xử lý, công ty quảng cáo có thể ghi nhận và đưa ra những gợi ý mua sắm ngay trên các nền tảng mạng xã hội mà người dùng A đang sử dụng ngay sau đó.

6. Một số dịch vụ điển hình tại FPT Cloud về Kafka

Chúng ta hãy cùng điểm nhanh qua một số dịch vụ điển hình đã được tích hợp Kafka được cung cấp bởi FPT Cloud nhé!

FPT Database Engine cho Redis

Sản phẩm được cung cấp dưới dạng dịch vụ, giúp khách hàng triển khai, giám sát, sao lưu, khôi phục và mở rộng cơ sở dữ liệu Redis trên nền tảng đám mây.

Như bạn đã biết, Redis là cơ sở dữ liệu caching mã nguồn mở thông dụng được giới công nghệ đánh giá rất cao. Việc quản lý việc khôi phục và sao lưu dữ liệu được thực hiện theo từng thời điểm. Ngay cả khi bị lỗi, việc xử lý dữ liệu sẽ được chuyển sang nút dự phòng đảm bảo an toàn dữ liệu.

>>> Tham khảo tại: https://fptcloud.com/product/fpt-timeseries-database-engine/

FPT Database Engine cho MongoDB

Tương tự như sản phẩm trên tuy nhiên FPT Database Engine cho MongoDB mọi hoạt động dựa trên cơ sở dữ liệu MongoDB.

Trong đó, MongoDB là cơ sở dữ liệu no-SQL mã nguồn mở phổ biến hàng đầu trên thị trường. Với FPT Database Engine cho MongoDB người dùng có thể phát triển ứng dụng và tiết kiệm tối đa chi phí, nguồn lực cho công tác quản trị cơ sở dữ liệu.

>>> Tham khảo tại: https://fptcloud.com/product/fpt-non-relational-database-engine/

FPT Database Engine cho PostgreSQL

FPT Database Engine cho PostgreSQL ghi điểm mạnh mẽ với khả năng tạo mới, tăng hoặc giảm tài nguyên nhanh chóng (tính theo phút). Quá trình mở rộng tài nguyên (hot-add) dễ dàng, mượt mà mà không ảnh hưởng đến hoạt động của cơ sở dữ liệu.

>>> Tham khảo tại: https://fptcloud.com/product/fpt-relational-database-engine/

FPT Database Engine cho MySQL

Và không thể không nhắc đến FPT Database Engine cho MySQL, đây là dịch vụ best seller của FPT Cloud. Bởi sự đơn giản hóa trong quá trình triển khai được tự động hóa 99%. Dịch vụ còn được tích hợp giám sát, cảnh báo sự cố kịp thời.

>>> Tham khảo tại: https://fptcloud.com/product/fpt-olap-database-engine/

Những bài viết liên quan:

PostgreSQL là gì? Tìm hiểu về hệ quản trị cơ sở dữ liệu PostgreSQL

So sánh VPS và Cloud Server chi tiết từ A đến Z

Svchost là gì? Cách xử lý Svchost giúp máy tính chạy mượt

SWAP RAM là gì? Điều cần biết trước khi sử dụng SWAP(RAM ảo)

Trên đây là chia sẻ về Kafka, hy vọng thông tin đã kịp thời giải đáp những thắc mắc của Quý bạn đọc ngay tiêu đề bài viết. Theo dõi fptcloud.com ngay để cập nhật tin tức nhất công nghệ mới nhất và tham khảo các gói dịch vụ của FPT Cloud đang phục vụ hơn 3000 khách hàng doanh nghiệp.