- Giới thiệu

-

Dịch vụ máy chủ ảo tiết kiệm đến 90% chi phí cho doanh nghiệp

Dịch vụ máy chủ ảo tiết kiệm đến 90% chi phí cho doanh nghiệp Lưu trữ dữ liệu đối tượng không giới hạn và truy xuất dữ liệu liên tục

Lưu trữ dữ liệu đối tượng không giới hạn và truy xuất dữ liệu liên tục Nâng cao năng lực, tính sẵn sàng của ứng dụng

Nâng cao năng lực, tính sẵn sàng của ứng dụng Tích hợp với máy chủ ảo dành cho 3D Rendering, AI hay ML

Tích hợp với máy chủ ảo dành cho 3D Rendering, AI hay ML Sản phẩm hợp tác giữa FPT Cloud và CyRadar, cung cấp dịch vụ tường lửa với khả năng bảo vệ mạnh mẽ cho các ứng dụng web

Sản phẩm hợp tác giữa FPT Cloud và CyRadar, cung cấp dịch vụ tường lửa với khả năng bảo vệ mạnh mẽ cho các ứng dụng web Sản phẩm hợp tác giữa FPT Cloud và CyRadar, dịch vụ cung cấp khả năng rà quét toàn diện, phân tích chi tiết và đánh giá lỗ hổng bảo mật để tăng cường an ninh thông tin cho hệ thống ứng dụng doanh nghiệp

Sản phẩm hợp tác giữa FPT Cloud và CyRadar, dịch vụ cung cấp khả năng rà quét toàn diện, phân tích chi tiết và đánh giá lỗ hổng bảo mật để tăng cường an ninh thông tin cho hệ thống ứng dụng doanh nghiệp Sao lưu và khôi phục dữ liệu tức thời, an toàn và toàn vẹn dữ liệu

Sao lưu và khôi phục dữ liệu tức thời, an toàn và toàn vẹn dữ liệu Giải pháp làm việc từ xa hiệu quả và an toàn cho doanh nghiệp

Giải pháp làm việc từ xa hiệu quả và an toàn cho doanh nghiệp

Dịch vụ máy chủ ảo tiên tiến với khả năng mở rộng nhanh chóng

Dịch vụ máy chủ ảo tiên tiến với khả năng mở rộng nhanh chóng Hiệu năng mạnh mẽ với hạ tầng riêng biệt

Hiệu năng mạnh mẽ với hạ tầng riêng biệt

Tích hợp với máy chủ ảo dành cho 3D Rendering, AI hay ML

Tích hợp với máy chủ ảo dành cho 3D Rendering, AI hay ML Dịch vụ máy chủ ảo tiết kiệm đến 90% chi phí cho doanh nghiệp

Dịch vụ máy chủ ảo tiết kiệm đến 90% chi phí cho doanh nghiệp Nâng cao năng lực, tính sẵn sàng của ứng dụng

Nâng cao năng lực, tính sẵn sàng của ứng dụng Sao lưu và khôi phục dữ liệu tức thời, an toàn và toàn vẹn dữ liệu

Sao lưu và khôi phục dữ liệu tức thời, an toàn và toàn vẹn dữ liệu Dịch vụ dự phòng & khôi phục hệ thống nhanh chóng

Dịch vụ dự phòng & khôi phục hệ thống nhanh chóng Lưu trữ khối đa dạng thông lượng và dung lượng cho mọi nhu cầu

Lưu trữ khối đa dạng thông lượng và dung lượng cho mọi nhu cầu Lưu trữ dữ liệu đối tượng không giới hạn và truy xuất dữ liệu liên tục

Lưu trữ dữ liệu đối tượng không giới hạn và truy xuất dữ liệu liên tục Sản phẩm hợp tác giữa FPT Cloud và CyRadar, dịch vụ cung cấp khả năng rà quét toàn diện, phân tích chi tiết và đánh giá lỗ hổng bảo mật để tăng cường an ninh thông tin cho hệ thống ứng dụng doanh nghiệp

Sản phẩm hợp tác giữa FPT Cloud và CyRadar, dịch vụ cung cấp khả năng rà quét toàn diện, phân tích chi tiết và đánh giá lỗ hổng bảo mật để tăng cường an ninh thông tin cho hệ thống ứng dụng doanh nghiệp Sản phẩm hợp tác giữa FPT Cloud và CyRadar, cung cấp dịch vụ tường lửa với khả năng bảo vệ mạnh mẽ cho các ứng dụng web

Sản phẩm hợp tác giữa FPT Cloud và CyRadar, cung cấp dịch vụ tường lửa với khả năng bảo vệ mạnh mẽ cho các ứng dụng web Dịch vụ tường lửa thông minh cho các ứng dụng web - Giải pháp bảo mật đột phá với sự hợp tác giữa FPT Cloud và Penta Security.

Dịch vụ tường lửa thông minh cho các ứng dụng web - Giải pháp bảo mật đột phá với sự hợp tác giữa FPT Cloud và Penta Security. Dịch vụ bảo mật tường lửa thế hệ mới

Dịch vụ bảo mật tường lửa thế hệ mới Lưu trữ, quản lý, và bảo mật các Docker Images

Lưu trữ, quản lý, và bảo mật các Docker Images Nền tảng Kubernetes an toàn, bảo mật, ổn định, hiệu năng cao

Nền tảng Kubernetes an toàn, bảo mật, ổn định, hiệu năng cao Tăng tốc phát triển ứng dụng yêu cầu hiệu năng cao bằng dịch vụ Kubernetes tích hợp với vi xử lý cao cấp GPU

Tăng tốc phát triển ứng dụng yêu cầu hiệu năng cao bằng dịch vụ Kubernetes tích hợp với vi xử lý cao cấp GPU Giám sát và triển khai cơ sở dữ liệu như Kafka,..

Giám sát và triển khai cơ sở dữ liệu như Kafka,..

Giám sát và triển khai cơ sở dữ liệu Redis, Cassandra, ...

Giám sát và triển khai cơ sở dữ liệu Redis, Cassandra, ...

Giám sát và triển khai cơ sở dữ liệu xử lý phân tích trực tuyến

Giám sát và triển khai cơ sở dữ liệu xử lý phân tích trực tuyến

Giám sát và triển khai cơ sở dữ liệu MySQL, Postgres, SQLserver, MariaDB,...

Giám sát và triển khai cơ sở dữ liệu MySQL, Postgres, SQLserver, MariaDB,... Giám sát và triển khai cơ sở dữ liệu truy vấn thông tin

Giám sát và triển khai cơ sở dữ liệu truy vấn thông tin

Giám sát và triển khai cơ sở dữ liệu chuỗi thời gian

Giám sát và triển khai cơ sở dữ liệu chuỗi thời gian

Giám sát hệ thống và tài nguyên toàn diện trên mọi nền tảng

Giám sát hệ thống và tài nguyên toàn diện trên mọi nền tảng Giải pháp quản lý sự cố thông minh

Giải pháp quản lý sự cố thông minh Dịch vụ tự động khởi tạo, duy trì, quản lý và bảo vệ các API ở mọi quy mô

Dịch vụ tự động khởi tạo, duy trì, quản lý và bảo vệ các API ở mọi quy mô Dịch vụ cung cấp giải pháp khởi tạo và quản lý FPT ArgoCD được tạo ra từ dự án mã nguồn mở Argo

Dịch vụ cung cấp giải pháp khởi tạo và quản lý FPT ArgoCD được tạo ra từ dự án mã nguồn mở Argo Nền tảng đồng bộ hóa cơ sở dữ liệu theo thời gian thực.

Nền tảng đồng bộ hóa cơ sở dữ liệu theo thời gian thực. Nền tảng xử lý dữ liệu lớn mạnh mẽ và linh hoạt

Nền tảng xử lý dữ liệu lớn mạnh mẽ và linh hoạt Nền tảng hội thoại thông minh gắn kết khách hàng trên mọi nền tảng

Nền tảng hội thoại thông minh gắn kết khách hàng trên mọi nền tảng Xác thực nhanh chóng, dễ dàng, tối ưu chi phí

Xác thực nhanh chóng, dễ dàng, tối ưu chi phí Nâng tầm trải nghiệm khách hàng

Nâng tầm trải nghiệm khách hàng

Trích xuất dữ liệu vượt mọi giới hạn

Trích xuất dữ liệu vượt mọi giới hạn

Chuyển văn bản thành giọng nói tiếng Việt với ngữ điệu tự nhiên.

Chuyển văn bản thành giọng nói tiếng Việt với ngữ điệu tự nhiên. - Bảng giá

- Sự kiện

File Robots.txt là gì? Các cách tạo file Robots.txt cho WordPress

File Robots.txt là gì? Các cách tạo file Robots.txt cho WordPress

File Robots.txt được sử dụng để định hướng việc thu thập dữ liệu Indexing trên website. Kỹ thuật này giúp người dùng đi đến đúng các trang mục tiêu của bạn mong đợi. Để hiểu hơn về hình thức và cơ chế hoạt động, hãy đến với bài viết dưới đây của FPT Cloud. Đặc biệt, phần cuối sẽ hé lộ cách tạo file Robots txt cho website từ nhiều phương pháp khác nhau.

File Robots.txt là gì?

File Robots.txt là tập tin văn bản đơn giản, được tạo và lưu trữ ở dưới dạng .txt. Đây cũng là một phần trong giao thức Robots Exclusion Protocol (REP). Mục đích tạo ra để chứa một nhóm tiêu chuẩn quy định cách Robot Web thu thập dữ liệu.

Ý nghĩa của WordPress Robots txt cũng liên quan đến hoạt động truy cập, Indexing, cung cấp nội dung đó cho người dùng. Để vận hành hiệu quả, REP gồm cả các lệnh như Meta Robots, Page-Subdirectory, Site-Wide Instructions.

Sự phối hợp này giúp công cụ tìm kiếm, điển hình là Google xử lý các liên kết. Trên thực tế, tạo WordPress Robots.txt giúp nhà quản trị web linh hoạt, chủ động hơn. Họ dễ dàng cho phép hoặc không cho phép Bot Indexing phần nào đó trong trang.

>>> Có thể bạn quan tâm: Hướng dẫn cách sử dụng WordPress chi tiết cho người mới bắt đầu

Vị trí file Robots.txt cho WordPress

Theo sau định nghĩa, điều cơ bản cần biết là vị trí đặt file Robots.txt ở đâu. Khi tạo website WordPress sẽ tự động tạo ra tệp này và đặt bên dưới thư mục gốc Server.

Giả sử, Site của bạn đặt trong thư mục gốc có địa chỉ yourwebsite.com. Như vậy, đường dẫn truy cập Robots txt WordPress là yourwebsite.com/robots.txt.

Bạn cần lưu ý rằng đây là file ảo do WordPress tự thiết lập mặc định. Tệp này không thể chỉnh sửa được mặc dù hoạt động vẫn diễn ra bình thường.

Tóm lại, vị trí Robot.txt WordPress nằm ở thư mục gốc. Folder này thường có tên là public_html và www (hoặc tên website). Bạn cũng có thể thay đổi bằng cách tạo file Robots.txt cho WordPress thay thế.

Quy tắc khi tạo file Robots txt cho website

Trong phần này bạn sẽ biết mục đích của các quy tắc khi tạo Robots.txt là gì. Bên cạnh đó là lưu ý rất đáng ghi nhớ trong quá trình thực hiện.

Quy tắc

File Robots.txt cho WordPress được tạo ra dựa trên những quy tắc nhất định phải tuân theo. Về cơ bản, tệp chỉ có 2 rules ngắn nhưng hầu hết website trong thực tế đều thiết lập nhiều hơn vậy. Hình thức xuất hiện điển hình như sau:

User-agent: *

Allow: /

# Disallowed Sub-Directories

Disallow: /checkout/

Disallow: /images/

Disallow: /forum/

Đây là file Robots.txt chuẩn cho một diễn đàn thường thấy. Về nguyên tắc, công cụ tìm kiếm sẽ phải quét hết mọi chủ đề trên forum. Thế nhưng, có chủ đề do người dùng tạo ra chỉ là câu chuyện bên lề, không cần thiết.

Vì thế, bạn sẽ cài đặt rule “Disallow it” xác định loại sub-forum nào cần tránh. Việc của công cụ tìm kiếm đơn giản hơn nhiều, đó là quét phần nội dung còn lại.

Ngoài ra, dấu “*” sử dụng với mục đích đưa ra lệnh áp dụng luật lên toàn trang. Phần “Allow:/” phía dưới thông báo quét tất cả web trừ những phần Disallow. Ngoài ra, bạn cũng nên xem qua ví dụ thứ hai để hiểu hơn về file Robots.txt.

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

User-agent: Bingbot

Disallow: /

Trong file Robots.txt này đã đặt thêm rules để chặn Bing’s search bot quét website. Bingbot là tên Bot của công cụ tìm kiếm Bing. Bạn có thể điều chỉnh tương tự tìm kiếm của Search Engine nào được truy cập và không.

Lưu ý

Thế nhưng, nhiều Bots độc hại vốn chẳng quan tâm và tuân theo quy định. Hiểu đơn giản, Bots chỉ làm theo hướng dẫn trong file Robots.txt. Tuy nhiên, điều đó không có nghĩa là file Robots.txt bắt buộc Bots phải làm như vậy.

Khi tham khảo các lời khuyên, bạn sẽ cảm thấy bối rối vì không biết chặn và không chặn loại nào. Vì thế, cách tối ưu nhất là hãy giản lược rules nhất có thể. Ví dụ như sau:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Theo cách thiết lập này, mặc định WordPress sẽ chặn thư mục wp-admin và wp-includes. Tuy nhiên, dù thế nào bạn cũng nên bám sát 2 rules đã giới thiệu ở trên.

Cách tạo file Robots.txt cho WordPress

Sau khi đã quyết định về rule, bạn tiến hành sang giai đoạn chính là tạo file Robots.txt. Phương pháp thực hiện khả thi là nhờ sự hỗ trợ của Plugin. Nếu thành thạo hơn, bạn có thể tự thiết lập thủ công.

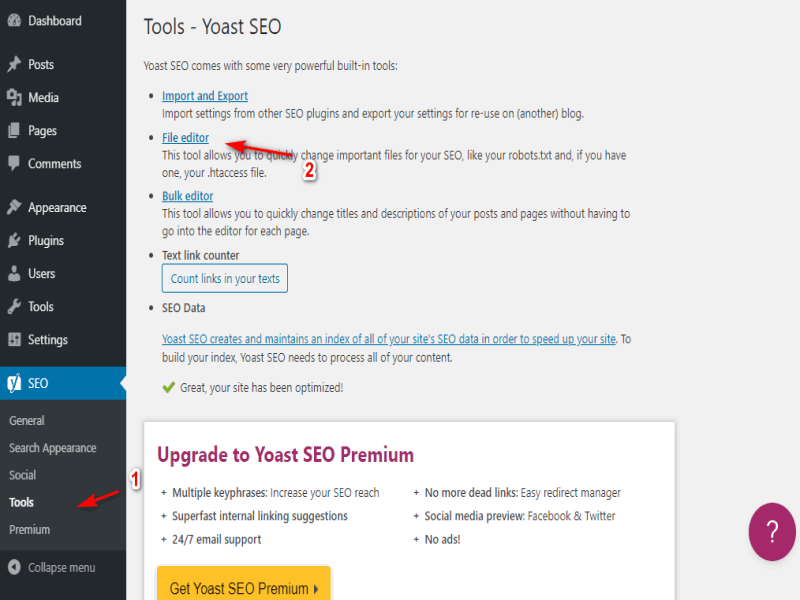

Yoast SEO

Mức độ nổi tiếng và hữu ích của Yoast SEO Plugin chắc chắn là điều không cần bàn cãi. Công cụ được yêu thích bởi khả năng hỗ trợ website tận dụng từ khóa tốt hơn. Bên cạnh đó là việc cải thiện độ dễ đọc, giữ chân người truy cập.

Ngoài ra, cách tạo file Robots.txt với sự hỗ trợ của Plugin này cũng rất đáng để khai thác. Trước hết, bạn cần cài đặt Yoast SEO rồi chuyển tới tab SEO -> Tools trong Dashboard. Sau đó, hãy tìm mục File Editor và click vào.

Ngay lập tức, hệ thống sẽ gửi bạn tới trang mới, cho phép chỉnh sửa file .htaccess. Hãy tìm đến nút “Create Robots.txt file” ngay trên đầu và nhấn vào đó.

Tab sẽ hiển thị Editor mới để bạn chỉnh sửa file Robots.txt trực tiếp. Mỗi khi thêm hoặc xóa rules, bạn nhớ click nút “Save changes to Robots.txt” để lưu lại. Chỉ cần như vậy là đã hoàn tất tệp chuẩn cho WordPress.

>>> Có thể bạn quan tâm: Hướng dẫn cách sử dụng WooCommerce Plugin cho người mới

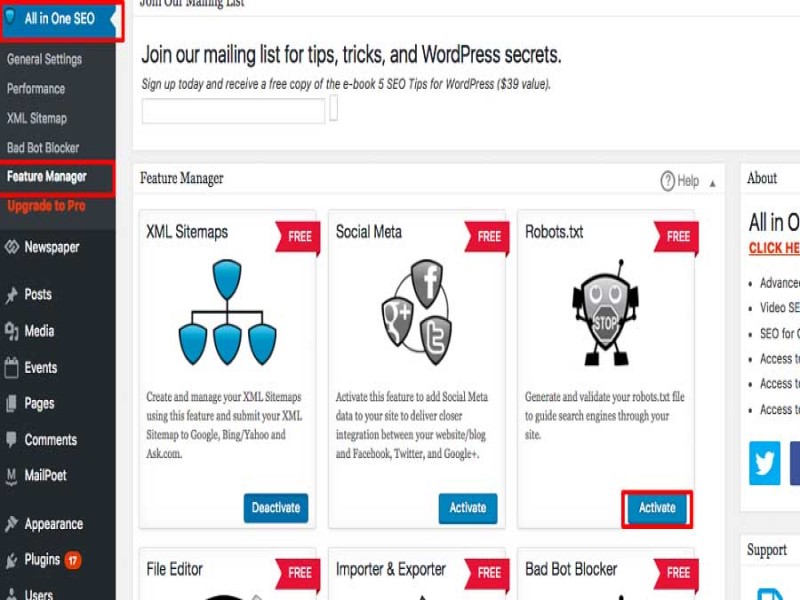

Sử dụng tính năng trong Plugin All in One SEO Pack

All in One SEO Pack có đầy đủ các tính năng như Yoast SEO, cộng thêm điểm mạnh là rất nhẹ. Vì thế, mọi hoạt động trong quá trình tạo Robots.txt nhanh chóng được diễn ra.

Tương tự như trên, điều đầu tiên là setup sẵn sàng Plugin này. Tiếp theo là di chuyển tới All in One SEO > Feature Manager trong Dashboard. Tại đây, bạn tìm mục có tên Robots.txt và nhấp nút “Active” ngay bên dưới.

Tab mới – Robots.txt sẽ xuất hiện phía dưới menu All in One SEO. Bạn click vào để thấy nhiều lựa chọn trong việc thêm, xóa hoặc chỉnh sửa rules.

Lưu ý là các dòng lệnh chưa trực tiếp kích hoạt ngay khi điền. Điều này tuy hơi phức tạp nhưng sẽ tránh việc ghi lỗi, gây thiệt hại cho Site. Ngoài ra, Plugin đính kèm nhiều tính năng để chặn “bad” Bots.

Upload file Robots.txt qua FTP

Dù là thực hiện thủ công nhưng không khó để bạn đạt thành quả cuối cùng. Điều cần có là chuẩn bị trước text editor bạn thích, ví dụ như NotePad hoặc Text Edit. Sau đó, hãy gõ các rules bạn mong muốn vào đó, lưu lại dưới dạng txt.

Khi đã có sẵn file, bạn kết nối tới website thông qua FTP. Tiếp theo là chuyển vào thư mục public_html. Tại đây, bạn chỉ cần nhấn “Upload” hoặc kéo thả file Robots.txt từ máy tính sang Server. Vì tệp nhẹ nên thường chỉ mất 1 giây là xong.

Với cả ba cách trên, bạn nên kiểm tra lại để xem có bị lỗi không. Để thực hiện, hãy sử dụng công cụ The Search Console do Google cung cấp.

Đầu tiên là đăng nhập vào Console và chuyển tới tab Robots.txt Tester. Bên trong sẽ xuất hiện trường editor để nhập code vào và ấn “Submit”. Công cụ sẽ hỏi bạn muốn dùng code mới không, hoặc kéo file mới về từ Site.

Lúc này, hãy nhấn vào “Ask Google to Update” để gửi lên Google. Việc còn lại là chờ kiểm tra và nhận thông báo.

Trên đây là những điều cần biết để tăng khả năng tiếp cận của Site lên trình tìm kiếm. Qua đó đảm bảo Search Engine không bị chặn và có thể quét những khu vực chứa thông tin quan trọng.

Nhờ sự tương tác tốt khi tìm kiếm, các trang sẽ nhanh chóng đứng top. Vì thế, FPT Cloud mong rằng bạn sẽ sớm thành thạo cách tạo file Robots.txt.

Liên hệ với chúng tôi để biết thêm thông tin chi tiết về dịch vụ của FPT Smart Cloud

- Website: https://fptcloud.com/

- Fanpage: https://www.facebook.com/fptsmartcloud

- Email: [email protected]

- Hotline: 1900 638 399

Có thể bạn quan tâm