Blogs Tech

Danh mục

Blog chia sẻ kiến thức FPT Cloud

Chính sách bảo vệ dữ liệu cá nhân

16:39 14/08/2024

Công ty Trách nhiệm hữu hạn FPT Smart Cloud (“FPT Smart Cloud”) xây dựng Chính sách Bảo vệ Dữ liệu cá nhân này (“Chính sách”) để Quý Khách hàng hiểu rõ hơn về mục đích, phạm vi thông tin mà chúng tôi xử lý, các biện pháp chúng tôi áp dụng để bảo vệ thông tin cá nhân và quyền của Quý Khách hàng đối với các hoạt động này.

Chính sách này là một phần không thể tách rời của Hợp đồng, Điều khoản sử dụng, Chính sách và các thỏa thuận sử dụng khác của FPT Smart Cloud, được công bố trên các Kênh giao dịch của FPT Smart Cloud trong từng thời kỳ.

Điều 1. Định nghĩa

1.1. FPT Smart Cloud: là Công ty Trách nhiệm hữu hạn FPT Smart Cloud, mã số thuế 0109307938. Trụ sở chính tại Số 10 Phạm Văn Bạch, Phường Dịch Vọng, Quận Cầu Giấy, Thành phố Hà Nội, Việt Nam.

1.2. Khách hàng: là Khách hàng cá nhân, với thông tin cung cấp cho FPT Smart Cloud khi đăng ký, sử dụng các Dịch vụ của FPT Smart Cloud.

1.3. Dữ liệu cá nhân: là thông tin dưới dạng ký hiệu, chữ viết, chữ số, hình ảnh, âm thanh hoặc dạng tương tự trên môi trường điện tử gắn liền với một con người cụ thể hoặc giúp xác định một con người cụ thể. Dữ liệu cá nhân bao gồm dữ liệu cá nhân cơ bản và dữ liệu cá nhân nhạy cảm.

1.4. Dữ liệu cá nhân cơ bản bao gồm:

(a) Họ, chữ đệm và tên khai sinh, tên gọi khác (nếu có);

(b) Ngày, tháng, năm sinh; ngày, tháng, năm chết hoặc mất tích;

(c) Giới tính;

(d) Nơi sinh, nơi đăng ký khai sinh, nơi thường trú, nơi tạm trú, nơi ở hiện tại, quê quán, địa chỉ liên hệ;

(e) Quốc tịch;

(f) Hình ảnh của cá nhân;

(g) Số điện thoại, số chứng minh nhân dân, số định danh cá nhân, số hộ chiếu, số giấy phép lái xe, số biển số xe, số mã số thuế cá nhân, số bảo hiểm xã hội, số thẻ bảo hiểm y tế;

(h) Tình trạng hôn nhân;

(i) Thông tin về mối quan hệ gia đình (cha mẹ, con cái);

(j) Thông tin về tài khoản số của cá nhân; dữ liệu cá nhân phản ánh hoạt động, lịch sử hoạt động trên không gian mạng;

(k) Các thông tin khác gắn liền với một con người cụ thể hoặc giúp xác định một con người cụ thể không thuộc Dữ liệu cá nhân nhạy cảm.

(l) Các dữ liệu khác theo quy định pháp luật hiện hành.

1.5. Dữ liệu cá nhân nhạy cảm dữ liệu cá nhân gắn liền với quyền riêng tư của cá nhân mà khi bị xâm phạm sẽ gây ảnh hưởng trực tiếp tới quyền và lợi ích hợp pháp của cá nhân gồm:

(a) Quan điểm chính trị, quan điểm tôn giáo;

(b) Tình trạng sức khỏe và đời tư được ghi trong hồ sơ bệnh án, không bao gồm thông tin về nhóm máu;

(c) Thông tin liên quan đến nguồn gốc chủng tộc, nguồn gốc dân tộc;

(d) Thông tin về đặc điểm di truyền được thừa hưởng hoặc có được của cá nhân;

(e) Thông tin về thuộc tính vật lý, đặc điểm sinh học riêng của cá nhân;

(f) Thông tin về đời sống tình dục, xu hướng tình dục của cá nhân;

(g) Dữ liệu về tội phạm, hành vi phạm tội được thu thập, lưu trữ bởi các cơ quan thực thi pháp luật;

(h) Thông tin khách hàng của tổ chức tín dụng, chi nhánh ngân hàng nước ngoài, tổ chức cung ứng dịch vụ trung gian thanh toán, các tổ chức được phép khác, gồm: thông tin định danh khách hàng theo quy định của pháp luật, thông tin về tài khoản, thông tin về tiền gửi, thông tin về tài sản gửi, thông tin về giao dịch, thông tin về tổ chức, cá nhân là bên bảo đảm tại tổ chức tín dụng, chi nhánh ngân hàng, tổ chức cung ứng dịch vụ trung gian thanh toán;

(i) Dữ liệu về vị trí của cá nhân được xác định qua dịch vụ định vị;

(j) Dữ liệu cá nhân khác được pháp luật quy định là đặc thù và cần có biện pháp bảo mật cần thiết.

1.6. Bảo vệ dữ liệu cá nhân: là hoạt động phòng ngừa, phát hiện, ngăn chặn, xử lý hành vi vi phạm liên quan đến dữ liệu cá nhân theo quy định của pháp luật.

1.7. Xử lý dữ liệu cá nhân: là một hoặc nhiều hoạt động tác động tới dữ liệu cá nhân, như: thu thập, ghi, phân tích, xác nhận, lưu trữ, chỉnh sửa, công khai, kết hợp, truy cập, truy xuất, thu hồi, mã hóa, giải mã, sao chép, chia sẻ, truyền đưa, cung cấp, chuyển giao, xóa, hủy dữ liệu cá nhân hoặc các hành động khác có liên quan.

1.8. Kênh giao dịch FPT Smart Cloud: bao gồm Kênh giao dịch điện tử FPT Smart Cloud (Hotline, Facebook, Form đăng ký trên Website ….) hoặc các Kênh giao dịch khác tùy theo từng thời kỳ do FPT Smart Cloud cung cấp cho Khách hàng.

Điều 2. Loại Dữ liệu được xử lý

2.1. FPT Smart Cloud xử lý các loại Dữ liệu cá nhân sau đây của Khách hàng:

(a) Họ, chữ đệm và tên khai sinh, tên gọi khác (nếu có);

(b) Số điện thoại

(k) Email

2.2. Các Dữ liệu cá nhân được xử lý bao gồm các dữ liệu Khách hàng cung cấp cho FPT Smart Cloud khi đăng ký sử dụng dịch vụ và cả dữ liệu phát sinh trong quá trình Khách hàng sử dụng dịch vụ của FPT Smart Cloud.

Điều 3. Nguyên tắc bảo mật Dữ liệu của FPT Smart Cloud

3.1. Dữ liệu cá nhân của Khách hàng được cam kết bảo mật tối đa theo quy định của FPT Smart Cloud và quy định của pháp luật. Việc xử lý Dữ liệu cá nhân của mỗi Khách hàng chỉ được thực hiện khi có sự đồng ý của Khách hàng, trừ trường hợp pháp luật có quy định khác.

3.2. FPT Smart Cloud không sử dụng, chuyển giao, cung cấp hay chia sẻ cho bên thứ ba nào về Dữ liệu cá nhân của Khách hàng khi không có sự đồng ý của Khách hàng, trừ trường hợp pháp luật có quy định khác.

3.3. Các nguyên tắc khác theo quy định pháp luật hiện hành.

Điều 4. Mục đích xử lý

4.1. Khách hàng đồng ý cho phép FPT Smart Cloud xử lý Dữ liệu cá nhân của Khách hàng và chia sẻ kết quả xử lý dữ liệu cho các mục đích sau:

a) Hỗ trợ Khách hàng, cập nhật thông tin Khách hàng khi mua, sử dụng sản phẩm, dịch vụ do FPT Smart Cloud hoặc đối tác của FPT Smart Cloud cung cấp.

b) Cung cấp sản phẩm, dịch vụ của FPT Smart Cloud, sản phẩm, dịch vụ FPT Smart Cloud hợp tác với đối tác cho Khách hàng.

c) Tổ chức giới thiệu và xúc tiến thương mại, nghiên cứu thị trường, thăm dò dư luận, môi giới.

d) Nghiên cứu, phát triển các dịch vụ mới và cung cấp các sản phẩm, dịch vụ phù hợp cho Khách hàng.

e) Kinh doanh dịch vụ tiếp thị, giới thiệu sản phẩm quảng cáo.

f) Đo lường, phân tích dữ liệu nổi bộ, dánh giá và các xử lý khác để cải thiện và nâng cao chất lượng dịch vụ mà FPT Smart Cloud cung cấp cho khách hàng.

g) Điều tra, giải quyết thắc mắc, khiếu nại của Khách hàng.

h) Điều chỉnh, cập nhật, bảo mật và cải tiến các sản phẩm, dịch vụ, thiết bị mà FPT Smart Cloud đang cung cấp.

i) Xác minh danh tính và đảm bảo tính bảo mật thông tin của Khách hàng.

j) Thông báo cho Khách hàng về những thay đổi đối với các chính sách, khuyến mại của các sản phẩm, dịch vụ mà FPT Smart Cloud đang cung cấp.

k) Ngặn chặn và phòng chống gian lận, đánh cắp danh tính và các hoạt động bất hợp pháp khác.

l) Tuân thủ luật hiện hành, các tiêu chuẩn ngành có liên quan và các chính sách hiện hành khác của FPT Smart Cloud.

m) Bất kỳ mục đích nào khác dành riêng cho hoạt động vận hành của FPT Smart Cloud và theo bất kỳ mục đích nào khác mà FPT Smart Cloud thông báo cho Khách hàng, vào thời điểm thu thập dữ liệu cá nhân của Khách hàng hoặc trước khi bắt đầu xử lý liên quan hoặc theo yêu cầu khác hoặc được pháp luật hiện hành cho phép.

4.2. Trường hợp cần xử lý Dữ liệu cá nhân của Khách hàng cho các mục đích khác hoặc theo yêu cầu của Khách hàng, FPT Smart Cloud sẽ thông báo cho Khách hàng thông qua các Kênh giao dịch của FPT Smart Cloud để Khách hàng thể hiện sự đồng ý trước khi thực hiện.

Điều 5. Tổ chức được xử lý Dữ liệu cá nhân

5.1. Công ty Trách nhiệm hữu hạn FPT Smart Cloud, mã số thuế 0109307938. Trụ sở chính tại Số 10 Phạm Văn Bạch, Phường Dịch Vọng, Quận Cầu Giấy, Thành phố Hà Nội, Việt Nam.

5.2. FPT Smart Cloud sẽ thực hiện việc chia sẻ hoặc cùng xử lý dữ liệu cá nhân với các tổ chức, cá nhân sau:

a) Tập đoàn FPT và các Công ty thành viên trực thuộc Tập đoàn FPT.

b) Các Công ty thành viên mà FPT Smart Cloud trực tiếp hoặc gián tiếp sở hữu.

c) Các nhà thầu, đại lý, đối tác, các nhà cung cấp dịch vụ vận hành của FPT Smart Cloud.

d) Các chi nhánh, đơn vị kinh doanh và các cán bộ nhân viên làm việc tại các chi nhánh, đơn vị kinh doanh, đại lý của FPT Smart Cloud.

e) Các doanh nghiệp kinh doanh viễn thông trong trường hợp Khách hàng vi phạm nghĩa vụ thanh toán cước dịch vụ.

f) Các cửa hàng thương mại và nhà bán lẻ liên quan tới việc thực hiện các chương trình khuyến mại của FPT Smart Cloud.

g) Các cố vấn chuyên nghiệp của FPT Smart Cloud như kiểm toán, luật sư theo quy định của pháp luật.

h) Tòa án, các cơ quan nhà nước có thẩm quyền phù hợp với quy định của pháp luật và/hoặc khi được yêu cầu và pháp luật cho phép.

FPT Smart Cloud cam kết việc chia sẻ hoặc cùng xử lý dữ liệu cá nhân chỉ thực hiện trong trường hợp cần thiết để thực hiện các Mục Đích Xử Lý được nêu tại Điều 4 của Chính sách này hoặc theo quy định của pháp luật. Các tổ chức, cá nhân nhận được dữ liệu cá nhân của Khách hàng sẽ phải tuân thủ theo nội dung quy định tại Chính sách này và quy định của pháp luật về bảo vệ dữ liệu cá nhân liên quan.

Mặc dù FPT Smart Cloud sẽ thực hiện mọi nỗ lực để đảm bảo rằng các thông tin Khách hàng được ẩn danh/mã hóa, nhưng không thể loại trừ hoàn toàn rủi ro các dữ liệu này có thể bị tiết lộ trong một số trường hợp bất khả kháng.

5.3. Trong trường hợp có sự tham gia của các tổ chức xử lý dữ liệu cá nhân khác được nêu tại Điều này, Khách hàng đồng ý FPT Smart Cloud sẽ thông báo cho Khách hàng thông qua các Kênh giao dịch của FPT Smart Cloud trước khi FPT Smart Cloud thực hiện.

Điều 6. Xử lý Dữ liệu cá nhân trong một số trường hợp đặc biệt

FPT Smart Cloud đảm bảo thực hiện xử lý dữ liệu cá nhân của Khách hàng đáp ứng đầy đủ các yêu cầu của pháp luật trong các trường hợp đặc biệt nêu sau:

6.1. Đoạn phim của máy quay giám sát (CCTV), trong trường hợp cụ thể, cũng có thể được sử dụng cho các muc đích sau đây:

a) cho các mục đích đảm bảo chất lượng;

b) cho mục đích an ninh công cộng và an toàn lao động;

c) phát hiện và ngăn chặn việc sử dụng đáng ngờ, không phù hợp hoặc không được phép của các tiện ích, sản phẩm, dịch vụ và/hoặc cơ sở của FPT Smart Cloud;

d) phát hiện và ngăn chặn hành vi phạm tội; và/hoặc

e) tiến hành điều tra các sự cố.

6.2. FPT Smart Cloud luôn tôn trọng và bảo vệ dữ liệu cá nhân của trẻ em. Ngoài các biện pháp bảo vệ dữ liệu cá nhân được quy định theo pháp luật, trước khi xử lý dữ liệu cá nhân của trẻ em, FPT Smart Cloud sẽ thực hiện xác minh tuổi của trẻ em và yêu cầu sự đồng ý của:

a) trẻ em và/hoặc

b) cha, mẹ hoặc người giám hộ của trẻ em theo quy định của pháp luật.

6.3. Bên cạnh tuân thủ theo các quy định pháp luật có liên quan khác, đối với việc xử lý dữ liệu cá nhân liên quan đến dữ liệu cá nhân của người bị tuyên bố mất tích/ người đã chết, FPT Smart Cloud sẽ phải được sự đồng ý của một trong số những người có liên quan theo quy định của pháp luật hiện hành.

Điều 7. Lưu trữ Dữ liệu cá nhân

FPT Smart Cloud cam kết sẽ chỉ lưu trữ dữ liệu cá nhân của Khách hàng trong trường hợp liên quan đến các mục đích được nêu trong Chính sách này. FPT Smart Cloud cũng có thể cần lưu trữ dữ liệu cá nhân của quý khách trong một giai đoạn thời gian khi pháp luật hiện hành yêu cầu.

Điều 8. Quyền của Khách hàng

8.1. Khách hàng có quyền được biết về hoạt động xử lý dữ liệu cá nhân của mình, trừ trường hợp pháp luật có quy định khác.

8.2. Khách hàng được đồng ý hoặc không đồng ý cho phép xử lý dữ liệu cá nhân của mình, trừ trường hợp luật có quy định khác.

8.3. Khách hàng được quyền truy cập để xem, chỉnh sửa hoặc yêu cầu chỉnh sửa Dữ liệu cá nhân của mình bằng văn bản gửi đến FPT Smart Cloud, trừ trường hợp luật có quy định khác.

8.4. Khách hàng có quyền rút lại sự đồng ý của mình bằng văn bản gửi đến FPT Smart Cloud, trừ trường hợp pháp luật có quy định khác.Việc rút lại sự đồng ý không ảnh hưởng đến tính hợp pháp của việc xử lý dữ liệu đã được Khách hàng đồng ý với FPT Smart Cloud trước khi rút lại sự đồng ý.

8.5. Khách hàng được quyền xóa hoặc yêu cầu xóa dữ liệu cá nhân của mình bằng văn bản gửi đến FPT Smart Cloud, trừ trường hợp luật có quy định khác.

8.6. Khách hàng được quyền yêu cầu hạn chế xử lý Dữ liệu cá nhân của mình bằng văn bản gửi đến FPT Smart Cloud, trừ trường hợp luật có quy định khác. Việc hạn chế xử lý dữ liệu sẽ được FPT Smart Cloud thực hiện trong 72 giờ sau khi có yêu cầu của Khách hàng, với toàn bộ Dữ liệu cá nhân mà Khách hàng yêu cầu hạn chế, trừ trường hợp luật có quy định khác.

8.7. Khách hàng được quyền yêu cầu FPT Smart Cloud cung cấp cho bản thân Dữ liệu cá nhân của mình bằng văn bản gửi đến FPT Smart Cloud, trừ trường hợp luật có quy định khác.

8.8. Khách hàng được quyền phản đối FPT Smart Cloud, Tổ chức được xử lý dữ liệu cá nhân quy định tại Điều 5 Chính sách này xử lý dữ liệu cá nhân của mình bằng văn bản gửi đến FPT Smart Cloud nhằm ngăn chặn hoặc hạn chế tiết lộ Dữ liệu cá nhân hoặc sử dụng cho mục đích quảng cáo, tiếp thị, trừ trường hợp luật có quy định khác. FPT Smart Cloud sẽ thực hiện yêu cầu của Khách hàng trong 72 giờ sau khi nhận được yêu cầu, trừ trường hợp luật có quy định khác.

8.9. Khách hàng có quyền khiếu nại, tố cáo hoặc khởi kiện theo quy định của pháp luật.

8.10. Khách hàng có quyền yêu cầu bồi thường đối với thiệt hại thực tế theo quy định của pháp luật nếu FPT Smart Cloud có hành vi vi phạm quy định về bảo vệ Dữ liệu cá nhân của mình, trừ trường hợp các bên có thỏa thuận khác hoặc luật có quy định khác.

8.11. Khách hàng có quyền tự bảo vệ theo quy định của Bộ luật Dân sự, luật khác có liên quan, hoặc yêu cầu cơ quan, tổ chức có thẩm quyền thực hiện các phương thức bảo vệ quyền dân sự theo quy định tại Điều 11 Bộ luật Dân sự.

8.12. Các quyền khác theo quy định của pháp luật hiện hành.

8.13. Phương thức thực hiện quyền: bằng văn bản gửi đến FPT Smart Cloud hoặc gọi tới số đường dây nóng 1900 638 399 hoặc gửi email theo địa chỉ fptsmartcloud@fpt.com để được hướng dẫn.

Điều 9. Nghĩa vụ của Khách hàng

9.1. Tuân thủ các quy định của pháp luật, quy định, hướng dẫn của FPT Smart Cloud liên quan đến xử lý Dữ liệu cá nhân của Khách hàng.

9.2. Cung cấp đầy đủ, trung thực, chính xác Dữ liệu cá nhân, các thông tin khác theo yêu cầu của FPT Smart Cloud khi đăng ký và sử dụng dịch vụ của FPT Smart Cloud và khi có thay đổi về các thông tin này. FPT Smart Cloud sẽ tiến hành bảo mật Dữ liệu cá nhân của Khách hàng căn cứ trên thông tin Khách hàng đã đăng ký, do đó nếu có bất kỳ thông tin sai lệch nào FPT Smart Cloud sẽ không chịu trách nhiệm trong trường hợp thông tin đó làm ảnh hưởng hoặc hạn chế quyền lợi của Khách hàng. Trường hợp không thông báo, nếu có phát sinh rủi ro, tổn thất thì Khách hàng chịu trách nhiệm về những sai sót hay hành vi lợi dụng, lừa đảo khi sử dụng dịch vụ do lỗi của mình hoặc do không cung cấp đúng, đầy đủ, chính xác, kịp thời sự thay đổi thông tin; bao gồm cả thiệt hại về tài chính, chi phí phát sinh do thông tin cung cấp sai hoặc không thống nhất.

9.3. Phối hợp với FPT Smart Cloud, cơ quan nhà nước có thẩm quyền hoặc bên thứ ba trong trường hợp phát sinh các vấn đề ảnh hưởng đến tính bảo mật Dữ liệu cá nhân của Khách hàng.

9.4. Tự bảo vệ dữ liệu cá nhân của mình; chủ động áp dụng các biện pháp nhằm bảo vệ Dữ liệu cá nhân của mình trong quá trình sử dụng dịch vụ của FPT Smart Cloud; thông báo kịp thời cho FPT Smart Cloud khi phát hiện thấy có sai sót, nhầm lẫn về Dữ liệu cá nhân của mình hoặc nghi ngờ Dữ liệu cá nhân của mình đang bị xâm phạm.

9.5. Tự chịu trách nhiệm đối với những thông tin, dữ liệu, chấp thuận mà mình tạo lập, cung cấp trên môi trường mạng; tự chịu trách nhiệm trong trường hợp dữ liệu cá nhân bị rò rỉ, xâm phạm do lỗi của mình.

9.6. Thường xuyên cập nhật các Quy định, Chính sách bảo vệ Dữ liệu cá nhân của FPT Smart Cloud trong từng thời kỳ được thông báo tới Khách hàng hoặc đăng tải trên Kênh giao dịch của FPT Smart Cloud. Thực hiện các hành động theo hướng dẫn của FPT Smart Cloud để thể hiện rõ việc chấp thuận hoặc không chấp thuận đối với các mục đích xử lý Dữ liệu cá nhân mà FPT Smart Cloud thông báo tới Khách hàng trong từng thời kỳ.

9.7. Tôn trọng, bảo vệ dữ liệu cá nhân của người khác.

9.8. Tham gia tuyên truyền, phổ biến kỹ năng bảo vệ dữ liệu cá nhân.

9.9. Các trách nhiệm khác theo quy định của pháp luật.

Điều 10. Quyền của FPT Smart Cloud

10.1 Xử lý dữ liệu cá nhân của Khách hàng theo đúng mục đích, phạm vi và các nội dung khác đã thỏa thuận với Khách hàng và/hoặc được Khách hàng đồng ý.

10.2 Được phép sửa đổi, bổ sung nội dung hoặc thay thế Chính sách này theo từng thời kỳ và bảo đảm Khách hàng được thông báo thông qua các Kênh giao dịch của FPT Smart Cloud trước khi áp dụng. Nếu Khách hàng tiếp tục sử dụng các sản phẩm, dịch vụ, thực hiện, giao kết các giao dịch với FPT Smart Cloud sau thời điểm FPT Smart Cloud thông báo được hiểu là Khách hàng chấp nhận toàn bộ các sửa đổi, bổ sung, thay thế Chính sách này của FPT Smart Cloud.

10.3 Có quyền từ chối những yêu cầu không hợp pháp của Khách hàng hoặc vì lý do hạ tầng, kĩ thuật hay công nghệ không thể đáp ứng.

10.4 Quyết định áp dụng các biện pháp phù hợp để bảo vệ Dữ liệu cá nhân của Khách hàng.

10.5 Được miễn trừ mọi nghĩa vụ và trách nhiệm về các rủi ro có thể xảy ra trong quá trình Xử lý dữ liệu cá nhân, bao gồm nhưng không giới hạn thất thoát dữ liệu do lỗi hệ thống, do các nguyên nhân khách quan nằm ngoài tầm kiểm soát của FPT Smart Cloud.

10.6 Các quyền khác được quy định tại Chính sách này và theo quy định của pháp luật.

Điều 11. Nghĩa vụ của FPT Smart Cloud

11.1. Tuân thủ các quy định của pháp luật trong quá trình xử lý dữ liệu cá nhân của Khách hàng.

11.2. Áp dụng các biện pháp bảo mật thông tin phù hợp để tránh việc truy cập, thay đổi, sử dụng, tiết lộ trái phép dữ liệu cá nhân của Khách hàng.

11.3. Thực hiện đúng theo các yêu cầu hợp pháp của Khách hàng liên quan đến Dữ liệu cá nhân của Khách hàng.

11.4. Bảo đảm có cơ chế cho phép Khách hàng thực hiện các quyền liên quan đến Dữ liệu cá nhân của mình.

11.5. Phối hợp với cơ quan nhà nước có thẩm quyền và các tổ chức, cá nhân có liên quan khác để giảm thiểu tối đa thiệt hại khi phát hiện hành vi vi phạm pháp luật đối với Dữ liệu cá nhân của Khách hàng.

11.6. Các nghĩa vụ khác được quy định tại Chính sách này và theo quy định của pháp luật.

Điều 12. Cách thức xử lý Dữ liệu

FPT Smart Cloud áp dụng một hoặc nhiều hoạt động tác động tới dữ liệu cá nhân như: thu thập, ghi, phân tích, xác nhận, lưu trữ, chỉnh sửa, công khai, kết hợp, truy cập, truy xuất, thu hồi, mã hóa, giải mã, sao chép, chia sẻ, truyền đưa, cung cấp, chuyển giao, xóa, hủy dữ liệu cá nhân hoặc các hành động khác có liên quan.

Điều 13. Hậu quả, thiệt hại không mong muốn có khả năng xảy ra

13.1 FPT Smart Cloud sử dụng nhiều công nghệ bảo mật thông tin khác nhau nhằm bảo vệ Dữ liệu cá nhân của Khách hàng không bị truy lục, sử dụng hoặc chia sẻ ngoài ý muốn. Tuy nhiên, không một dữ liệu nào có thể được bảo mật 100%. Do vậy, FPT Smart Cloud cam kết sẽ bảo mật một cách tối đa Dữ liệu cá nhân của Khách hàng.

Một số hậu quả, thiệt hại không mong muốn có thể xảy ra bao gồm nhưng không giới hạn:

(a) Lỗi phần cứng, phần mềm trong quá trình xử lý dữ liệu làm mất dữ liệu của Khách hàng;

(b) Lỗ hổng bảo mật nằm ngoài khả năng kiểm soát của FPT Smart Cloud, hệ thống bị hacker tấn công gây lộ lọt dữ liệu;

(c) Khách hàng tự làm lộ lọt dữ liệu cá nhân do: bất cẩn hoặc bị lừa đảo; truy cập các website/tải các ứng dụng có chứa phần mềm độc hại…

13.2 FPT Smart Cloud khuyến cáo Khách hàng bảo mật các thông tin liên quan đến mật khẩu đăng nhập vào tài khoản của Khách hàng, mã OTP và không chia sẻ mật khẩu đăng nhập, mã OTP này với bất kỳ người nào khác.

13.3 Khách hàng nên bảo quản thiết bị điện tử trong quá trình sử dụng, Khách hàng nên khóa, đăng xuất, hoặc thoát khỏi tài khoản trên website hoặc Ứng dụng của FPT Smart Cloud khi không có nhu cầu sử dụng nữa.

13.4 Trong trường hợp máy chủ lưu trữ dữ liệu bị hacker tấn công dẫn đến mất mát Dữ liệu cá nhân của Khách hàng, FPT Smart Cloud sẽ có trách nhiệm thông báo vụ việc cho cơ quan chức năng điều tra xử lý kịp thời và thông báo cho Khách hàng được biết.

Điều 14. Cookies

14.1 Khi Khách hàng sử dụng hoặc truy cập các trang tin điện tử của FPT Smart Cloud, FPT Smart Cloud có thể đặt một hoặc nhiều cookie trên thiết bị của Khách hàng. “Cookie” là một tệp nhỏ được đặt trên thiết bị của Khách hàng khi Khách hàng truy cập một trang tin điện tử, nó ghi lại thông tin về thiết bị, trình duyệt của Khách hàng và trong một số trường hợp, sở thích và thói quen duyệt tin điện tử của Khách hàng. FPT Smart Cloud có thể sử dụng thông tin này để nhận diện Khách hàng khi Khách hàng quay lại các trang tin điện tử của FPT Smart Cloud, để cung cấp các dịch vụ được cá nhân hóa trên các trang tin điện tử của FPT Smart Cloud, để biên soạn số liệu phân tích nhằm hiểu rõ hơn về hoạt động của trang tin điện tử và để cải thiện các trang tin điện tử của FPT Smart Cloud. Khách hàng có thể sử dụng cài đặt trình duyệt của mình để xóa hoặc chặn cookie trên thiết bị của mình. Tuy nhiên, nếu Khách hàng quyết định không chấp nhận hoặc chặn cookie từ các trang tin điện tử của FPT Smart Cloud, Khách hàng có thể không tận dụng hết tất cả các tính năng của các trang tin điện tử của FPT Smart Cloud.

14.2 FPT Smart Cloud có thể xử lý thông tin cá nhân của Khách hàng thông qua công nghệ cookie, theo các quy định của Điều khoản này. FPT Smart Cloud cũng có thể sử dụng biện pháp tiếp thị lại để phân phát quảng cáo cho những cá nhân mà FPT Smart Cloud biết trước đây đã truy cập trang tin điện tử của mình.

14.3 Trong phạm vi các bên thứ ba đã gán nội dung lên trên các trang tin điện tử của FPT Smart Cloud (ví dụ: các tính năng truyền thông xã hội), các bên thứ ba đó có thể thu thập thông tin cá nhân của Khách hàng (ví dụ: dữ liệu cookie) nếu Khách hàng chọn tương tác với nội dung của bên thứ ba đó hoặc sử dụng các dịch vụ của bên thứ ba.

Điều 15. Điều khoản chung

15.1. Chính sách này có hiệu lực từ ngày 01/07/2023. Khách hàng hiểu và đồng ý rằng, Chính sách này có thể được sửa đổi theo từng thời kỳ và được thông báo tới Khách hàng thông qua các Kênh giao dịch của FPT Smart Cloud trước khi áp dụng. Những thay đổi và thời điểm có hiệu lực sẽ được cập nhật và công bố tại các Kênh giao dịch và các kênh khác của FPT Smart Cloud. Việc Khách hàng tiếp tục sử dụng dịch vụ sau thời hạn thông báo về các nội dung sửa đổi, bổ sung trong từng thời kỳ đồng nghĩa với việc Khách hàng đã chấp nhận các nội dung sửa đổi, bổ sung đó.

15.2. Khách hàng đã biết rõ và đồng ý bản Chính sách này cũng là Thông báo xử lý dữ liệu cá nhân quy định tại Điều 13 Nghị định 13/NĐ-CP/2023 và được sửa đổi, bổ sung trong từng thời kỳ trước khi FPT Smart Cloud tiến hành Xử lý dữ liệu cá nhân. Theo đó. FPT Smart Cloud không cần thực hiện thêm bất kỳ biện pháp nào khác nằm mục đích thông báo việc Xử lý dữ liệu cá nhân cho Khách hàng.

15.3. Khách hàng cam kết thực hiện nghiêm túc các quy định tại Chính sách này. Các vấn đề chưa được quy định, các Bên thống nhất thực hiện theo quy định của pháp luật, hướng dẫn của cơ quan Nhà nước có thẩm quyền và/hoặc các sửa đổi, bổ sung Chính sách này được FPT Smart Cloud thông báo cho khách hàng trong từng thời kỳ.

15.4. Chính sách này được giao kết trên cơ sở thiện chí giữa FPT Smart Cloud và Khách hàng. Trong quá trình thực hiện nếu phát sinh tranh chấp, các Bên sẽ chủ động giải quyết thông qua thương lượng, hòa giải. Trường hợp hòa giải không thành, tranh chấp sẽ được đưa ra Tòa án nhân dân có thẩm quyền để giải quyết theo quy định của pháp luật.

15.5. Khách hàng đã đọc kỹ, hiểu rõ các quyền và nghĩa vụ và đồng ý với toàn bộ nội dung của bản Chính sách bảo vệ dữ liệu cá nhân này.

Thông tin về người chịu trách nhiệm Bảo vệ dữ liệu cá nhân của FCI:

Người chịu trách nhiệm: Phạm Thế Minh

Mobile: +84 913571357

E-mail: minhpt@fpt.com

Sơ đồ tư duy là gì? Mẫu sơ đồ tư duy đẹp đơn giản 2023

15:56 14/08/2024

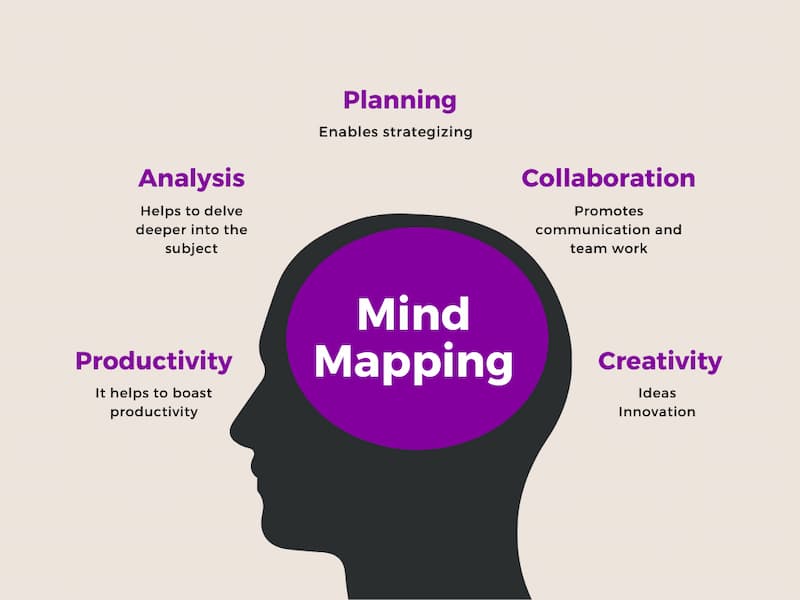

Sơ đồ tư duy là phương pháp hỗ trợ tuyệt vời giúp bạn sắp xếp các ý tưởng và thông tin một cách trực quan. Nó đang được ứng dụng ngày càng phổ biến trong học tập và làm việc. Nếu bạn chưa biết đến những lợi ích tuyệt vời của nó và cách để xây dựng sơ đồ tư duy sáng tạo, đẹp mắt thì hãy theo dõi ngay bài viết dưới đây của FTP Cloud.

1. Sơ đồ tư duy là gì?

[caption id="attachment_37422" align="aligncenter" width="800"] Sơ đồ tư duy là gì?[/caption]

Sơ đồ tư duy (Mindmap) là phương pháp hữu hiệu để tận dụng khả năng ghi nhận hình ảnh của bộ não bằng cách sử dụng các từ ngữ ngắn gọn, xúc tích và hình ảnh sinh động. Từ đó sẽ giúp ghi nhớ một cách nhanh chóng và lâu dài hơn.

Không chỉ vậy, sơ đồ tư duy còn giúp bạn ghi nhớ theo trình tự nhất định và liên kết các dữ liệu với nhau một cách chặt chẽ. Đồng thời kích thích trí não sáng tạo để khơi gợi hứng thú cho quá trình học tập, làm việc. Việc sử dụng Mindmap giúp tiết kiệm tối đa thời gian ghi chép văn bản dài mà hiệu quả ghi nhớ không cao.

Thông thường, sơ đồ tư duy có cấu trúc bao gồm: từ khóa/chủ đề chính ở vị trí trung tâm và các nhánh nhỏ thể hiện các nội dung, hình ảnh được phát triển từ chủ đề chính ở xung quanh. Sự sáng tạo với sơ đồ tư duy là không giới hạn, bạn có thể tùy chỉnh thêm hình ảnh và biểu trưng để tăng tính thẩm mỹ và dễ dàng ghi nhớ hơn.

2. Mẫu sơ đồ tư duy đẹp đơn giản 2023

Tham khảo mẫu sơ đồ tư duy độc đáo dưới đây để có thêm ý tưởng thiết kế sơ đồ tư duy phục vụ công việc và học tập của bạn!

2.1 Mẫu sơ đồ tư duy vòng tròn

[caption id="attachment_37423" align="aligncenter" width="800"] Mẫu sơ đồ tư duy vòng tròn[/caption]

Sơ đồ tư duy vòng tròn (Circle Map) đúng như với tên gọi của mình, cấu trúc của nó bao gồm vòng tròn lớn bên ngoài và một vòng tròn nhỏ bên trong. Theo đó, vòng tròn bên trong bao gồm chủ đề chính hoặc ý tưởng trung tâm. Xung quanh nó là vòng tròn lớn hơn diễn đạt các ý phụ, ý bổ trợ cho chủ đề chính/ý tưởng trung tâm.

2.2 Mẫu sơ đồ tư duy hình cây độc đáo

[caption id="attachment_37425" align="aligncenter" width="800"] Mẫu sơ đồ tư duy hình cây độc đáo[/caption]

Sơ đồ tư duy cây (Tree Map) là mẫu phổ biến nhất được nhiều người sử dụng hiện nay. Thiết kế giống như một cái cây, phía trên cùng là chủ đề chính hoặc nội dung chính và phía dưới là các chủ đề phụ, thông tin liên quan hay nội dung chi tiết làm rõ cho chủ đề chính.

Mẫu sơ đồ tư duy này không giới hạn số lượng phân nhánh nên có thể tùy chỉnh theo nội dung cấp cấp thông tin đầy đủ và hữu ích nhất. Đặc biệt hình ảnh minh họa sinh động dễ dàng trong việc nắm bắt thông tin hoặc liệt kê các nhiệm vụ, kế hoạch cụ thể.

2.3 Mẫu vẽ sơ đồ tư duy hình đám mây

[caption id="attachment_37424" align="aligncenter" width="800"] Mẫu vẽ sơ đồ tư duy hình đám mây[/caption]

Sơ đồ tư duy hình đám mây giúp bạn tạo ra một bức tranh toàn cảnh về các ý tưởng, ý kiến và thông tin liên quan. Mẫu sơ đồ tư duy này bạn có thể sắp xếp thông tin một cách chặt chẽ hơn và thể hiện sự liên kết của các ý tưởng. Hiện sơ đồ tư duy hình đám mây được sử dụng rộng rãi để phân tích ý kiến của khách hàng và mong muốn của họ.

>>> Xem thêm: Email là gì? Vai trò, Cách tạo & sử dụng email đơn giản nhất

2.4 Mẫu sơ đồ tư duy bong bóng

[caption id="attachment_37426" align="aligncenter" width="800"] Mẫu sơ đồ tư duy bong bóng[/caption]

Sơ đồ tư duy bong bóng (Bubble Map) là một biểu đồ gồm một vòng tròn ở trung tâm và các bong bóng hình tròn xung quanh nó, lan ra theo nhiều hướng. Trong sơ đồ này, vòng tròn ở trung tâm chứa chủ đề chính, còn các bong bóng sẽ chứa các ý tưởng và hành động cụ thể, bổ sung ý nghĩa cho chủ đề chính trong vòng tròn.

Bubble Map thường được sử dụng chủ yếu cho việc thiết lập mục tiêu và mô tả phân khúc khách hàng, và còn có thể được áp dụng vào nhiều mục đích khác.

2.5 Mẫu sơ đồ tư duy cho Giáo viên online

[caption id="attachment_37427" align="aligncenter" width="800"] Mẫu sơ đồ tư duy cho Giáo viên online[/caption]

Sơ đồ tư duy là một công cụ lý tưởng để giảng dạy và trình bày các khái niệm trong lớp học. Sơ đồ tư duy giúp giáo viên tập trung vào vấn đề cần truyền đạt cho học sinh, đồng thời cung cấp một cái nhìn tổng quan về chủ đề mà không có thông tin dư thừa. Giáo viên có thể sử dụng sơ đồ tư duy để lên kế hoạch bài giảng, giới thiệu các khái niệm mới, kiểm tra khả năng hiểu bài của học sinh.

2.6 Mẫu sơ đồ tư duy cho học sinh đẹp đơn giản

Sơ đồ tư duy mà một trong những phương pháp học giúp học sinh nhớ bài nhanh hơn. Có rất nhiều mẫu sơ đồ tư duy khác nhau phục vụ cho từng môn học giúp việc tiếp cận và ghi nhớ kiến thức trở nên đơn giản hơn.

[caption id="attachment_37428" align="aligncenter" width="800"] Mẫu sơ đồ tư duy cho học sinh đẹp đơn giản[/caption]

2.7 Mẫu sơ đồ tư duy cho Nhà văn

Việc sắp xếp ý tưởng và bố cục của nhà văn là rất cần thiết. Và sơ đồ tư duy là công cụ tuyệt vời giúp người dùng hoàn thành được việc này. Tham khảo mẫu dưới đây!

2.8 Mẫu sơ đồ tư duy phân tích sản phẩm

Nếu bạn đang phải làm việc với rất nhiều thông tin sản phẩm và gặp khó khăn trong việc trình bày chúng theo một trật tự nhất quán. Bạn hãy tạo một sơ đồ tư duy theo chiều dọc, chiều ngang hoặc tham khảo mẫu có sẵn trên các phần mềm vẽ sơ đồ tư duy.

2.9 Mẫu sơ đồ tư duy chiến lược sáng tạo

[caption id="attachment_37429" align="aligncenter" width="800"] Mẫu sơ đồ tư duy chiến lược sáng tạo[/caption]

Chiến lược rõ ràng, mạch lạc được sắp xếp và lưu trữ nhờ sơ đồ tư duy. Tham khảo mẫu sáng tạo dưới đây để có thêm gợi ý!

2.10 Mẫu sơ đồ tư duy nhân sự đẹp

Hệ thống nhân sự phức tạp khiến bạn khó ghi nhớ, đừng lo hãy sử dụng sơ đồ tư duy để đơn giản hóa nó giúp bạn dễ dàng phân tích và đánh giá.

2.11 Mẫu sơ đồ tư duy quảng cáo sáng tạo

[caption id="attachment_37430" align="aligncenter" width="800"] Mẫu sơ đồ tư duy quảng cáo sáng tạo[/caption]

Quảng cáo bao gồm rất nhiều những hạng mục nhỏ, mẫu sơ đồ tư duy dưới đây sẽ giúp bạn sắp xếp được những công việc cần làm một cách hiệu quả và nhanh chóng nhất.

3. Cách vẽ sơ đồ tư duy sáng tạo, đẹp

Vẽ sơ đồ tư duy có khó không? Khi bạn nắm bắt được những nguyên tắc và các bước dưới đây việc vẽ sơ đồ tư duy đẹp và sáng tạo không hề khó khăn.

3.1 Lên ý tưởng, chủ đề chính của sơ đồ

Điểm chung của tất cả các loại sơ đồ tư duy trên chính gồm 2 phần riêng biệt, rõ ràng như chủ đề chính và các nội dung nhỏ trong sơ đồ. Bởi vậy, trước khi bắt tay vẽ sơ đồ tư duy bạn cần xác định chính xác những nội dung trên. Từ đó dễ dàng trong việc lựa chọn mẫu sơ đồ tư duy phù hợp.

3.2 Ý tưởng thêm các nhánh lớn phát triển từ chủ đề chính ở trên

Bước tiếp theo, bạn hãy bắt đầu đặt chủ đề, nội dung chính vào vị trí trung tâm hoặc nhánh lớn nhất của sơ đồ tư duy. Sau đó tiếp nối đến các ý phụ phân nhánh.

Số lượng nhánh tùy thuộc vào nội dung đã phân loại của bạn. Để sơ đồ tư duy đẹp mắt và dễ nhìn hơn hãy sử dụng những từ ngắn gọn, xúc tích song phải đúng trọng tâm nêu bật được vấn đề.

3.3 Phát triển sơ đồ tư duy từ các nhánh nội dung chi tiết

Sau đó, từ các nhánh phục cấp 2 hãy triển khai các nhánh phục cấp 2, cấp 3 giúp bổ sung đầy đủ thông tin cho chủ đề/nội dung chính. Tất cả những thông tin đó phải đồng nhất và có liên kết chặt chẽ với nhau.

Hoàn thiện sơ đồ, tô đậm đường cong với nhiều màu sắc và vẽ thêm các hình minh họa

Đây là bước khá quan trọng giúp bạn có thể dễ dàng ghi nhớ được những nội dung đã liệt kê ở sơ đồ. Theo đó, bạn hãy tô màu cho các nhánh chính và áp dụng gợi ý như sau: tô đậm vào các chủ đề/nội dung chính; các nhánh cấp 1, cấp 2 và cấp 3 sử dụng màu sắc khác nhau để dễ dàng phân biệt. Ngoài ra, bạn có thể kết hợp sử dụng hình ảnh minh họa và icon khiến sơ đồ tư duy sáng tạo và ghi nhớ được lâu hơn.

>>> Xem thêm: TeamViewer là gì? Cách tải, cài đặt & sử dụng teamview

4. 5+ Phần mềm vẽ sơ đồ tư duy online đẹp, phổ biến nhất 2023

Vẽ sơ đồ tư duy bằng bút và giấy, bảng,…tồn tại khá nhiều hạn chế. Bởi vậy, các phần mềm vẽ sơ đồ tư duy online đã ra đời mang đến nhiều tiện ích sử dụng tuyệt vời. Đặc biệt, các phần mềm này còn cho phép kết nối thông tin với các nguồn tài liệu và website khác nhau giúp quá trình tạo sơ đồ tư duy của bạn trở nên dễ dàng hơn. Bạn có thể truy cập và làm việc trên phần mềm vẽ sơ đồ tư duy online từ bất kỳ thiết bị nào có kết nối internet. Dưới đây, chúng tôi xin giới thiệu 5+ phần mềm vẽ sơ đồ tư duy đẹp và sáng tạo sở hữu số lượng người dùng đông đảo nhất hiện nay!

4.1 Phần mềm X-mind

[caption id="attachment_37431" align="aligncenter" width="800"] Phần mềm X-mind[/caption]

Xmind là một trong những phần mềm vẽ sơ đồ tư duy phổ biến nhất hiện nay. Phần mềm cung cấp nhiều cấu trúc khác nhau hỗ trợ người dùng tạo ra các sơ đồ và lưu đồ khác nhau.

Phần mềm X-mind ra đời từ khá sớm và hoạt động mạnh mẽ trong nhiều thập kỷ. Hiện nó đang được hàng triệu người dùng cũng như doanh nghiệp tin dùng.

Ưu điểm

Hỗ trợ đa nền tảng, thiết bị bao gồm Mac, Windows và Linux.

Sử dụng dễ dàng trên các thiết bị di động, tương thích với các hệ điều hành phổ biến gồm iOS và Android.

Giao diện đẹp mắt, màu sắc hài hòa, dễ dàng sử dụng.

Cung cấp chế độ chuyển đổi từ sơ đồ tư duy thành bản trình chiếu.

Tích hợp nhiều ứng dụng hữu ích hỗ trợ vẽ sơ đồ tư duy đẹp mắt và hấp dẫn hơn.

Bản đồ tư duy rất dễ tạo bằng bàn phím

Nhược điểm

Bản miễn phí cung cấp các tính năng hạn chế

Không có đồng bộ hóa đám mây giữa các thiết bị.

4.2 Phần mềm Mondomo

[caption id="attachment_37432" align="aligncenter" width="800"] Phần mềm Mondomo[/caption]

Đây là phần mềm làm sơ đồ tư duy mà người dùng có thể truy cập trên web hoặc tải xuống trên PC. Phần mềm đa nền tảng này hỗ trợ tối đa trong việc tạo ra một phác thảo trực quan cho các ý tưởng của bạn. Đặc biệt, nó cho phép người dùng chia sẻ ý tưởng với người khác thông qua tính năng làm việc nhóm. Hiện Mondomo liên kết với nhiều phần mềm giáo dục như: Canvas, Desire2Learn, Moodle và Office 365.

Ưu điểm

Cung cấp phiên bản miễn phí trực tuyến và ngoại tuyến. Tính năng được cung cấp từ phiên bản miễn phí này khá đầy đủ

Thiết kế giao diện gọn gàng, sắp xếp khoa học và trực quan

Hỗ trợ truy cập và sử dụng trên thiết bị điện thoại di động

Đồng bộ hóa đám mây giữa các thiết bị

Nó cung cấp các phím tắt để điều hướng tốt hơn và nhanh hơn.

Nhược điểm

Truy cập sử dụng phần mềm trên thiết bị di động còn nhiều hạn chế

Khi sử dụng phần mềm đòi hỏi kết nối Internet đủ mạnh để có thể hoạt động hiệu quả.

Màu sắc khá đơn giản chưa có nhiều sự lựa chọn cho người dùng.

4.3 Phần mềm Edraw Mind Map

[caption id="attachment_37433" align="aligncenter" width="800"] Phần mềm Edraw Mind Map[/caption]

Edraw Mindmap được biết đến là một phần mềm vẽ sơ đồ tư duy không mất phí. Tất cả các template được tích hợp sẵn có giúp việc sử dụng phần mềm Edraw Mindmap rất dễ dàng. Tính năng đa dạng của phần mềm hỗ trợ làm ra những sơ đồ tư duy sáng tạo và độc đáo.

Ưu điểm

Hỗ trợ sử dụng đa nền tảng gồm điện thoại, máy tính website

Phần mềm vẽ sơ đồ tư duy online sử dụng miễn phí

Tốc độ xử lý nhanh chóng, giao diện thân thiện

Kho thư viện đa dạng cung cấp sơ đồ mẫu với nhiều chủ đề hấp dẫn

Bộ công cụ chỉnh sửa hoàn thiện, dễ thao tác

Tích hợp với cả các ứng dụng của Microsoft Office

Edraw Mindmap có thể xuất dữ liệu với các định dạng khác nhau

Nhược điểm

Không có nhiều tùy chọn để chia sẻ

4.4 Phần mềm vẽ sơ đồ tư duy Ayoa

[caption id="attachment_37434" align="aligncenter" width="800"] Phần mềm vẽ sơ đồ tư duy Ayoa[/caption]

Phần mềm Ayoa ra đời năm 2019 sở hữu tính năng và công nghệ mạnh mẽ, hỗ trợ tốt cho học tập, làm việc. Đây là ứng dụng sơ đồ tư duy dựa trên AI, cho phép chia sẻ với nhiều người dùng. Bạn dễ dàng truy cập sơ đồ thông qua phiên bản Ayoa Online, Ayoa PC và Ayoa Mobile.

Ưu điểm

Phần mềm cung cấp hình ảnh đa dạng và phong phú

Tích hợp nhiều tính năng và liên tục cập nhật cho người dùng những tính năng mới

Không gian làm việc của nhóm tối ưu

Bạn có thể truy cập nó với hầu hết tất cả các thiết bị phổ biến hiện nay.

Nhược điểm

Trình lưu lịch sử chỉnh sửa chưa thực sự tối ưu

Số lượng thành viên càng nhiều thì giá càng cao.

Phần mềm không có chức năng theo dõi thời gian.

4.5 Phần mềm TheBrain

[caption id="attachment_37435" align="aligncenter" width="800"] Phần mềm TheBrain[/caption]

TheBrain giúp sắp xếp và tổng hợp thông tin thành một sơ đồ dễ nhớ và khoa học. Phần mềm tạo sơ đồ tư duy này sẽ cung cấp cho bạn tính năng cần thiết cho việc thiết lập các nhánh trong biểu đồ một cách thật nhanh gọn.

Ưu điểm

Phần mềm sử dụng miễn phí trên các thiết bị khác nhau

Giao diện đơn giản và dễ dàng thao tác

Hỗ trợ ghi chú bằng hình ảnh và các ký tự đặc biệt

Kiểm soát nhiệm vụ và ghi nhớ công việc linh hoạt

Đồng bộ hóa dữ liệu khi đăng nhập bằng các thiết bị khác nhau

Nhược điểm

Phiên bản trả phí có mức giá khá cao

Bản dùng thử miễn phí chỉ kéo dài trong 30 ngày

Những bài viết liên quan:

Seeding là gì? Cách triển khai Seeding Marketing hiệu quả

Tab ẩn danh là gì? Cách mở tab ẩn danh trên máy tính, điện thoại

Trên đây là tổng quan những thông tin về sơ đồ tư duy hy vọng sau bài viết này FPT Cloud các bạn đã giải đáp được mọi thắc mắc của mình. Đồng thời biết cách làm sơ đồ tư duy đẹp, khoa học, hiệu quả giúp ích cho quá trình học tập và làm việc của mình.

CRM là gì? Quy trình triển khai hệ thống CRM chi tiết nhất

16:10 13/08/2024

CRM hệ thống phần mềm quản lý quan hệ khách hàng - sự kết hợp của chiến lược và công nghệ với mục tiêu gia tăng tính bền chặt trong mối quan hệ của doanh nghiệp, tổ chức với khách hàng. Nhờ CRM mà các doanh nghiệp có thể dễ dàng quản lý các thông tin liên quan đến khách hàng của mình. Hãy cùng chúng mình tìm hiểu chi tiết hơn về CRM là gì và quy trình triển khai của nó qua bài viết dưới đây nhé!

>>> Xem thêm: Top 16+ dịch vụ lưu trữ đám mây: so sánh, lợi ích, cách hoạt động

1. CRM là gì ?

CRM là phần mềm quản lý quan hệ khách hàng, là từ viết tắt thông dụng của cụm Customer Relationship Management. Khái niệm này được hiểu là cách giúp doanh nghiệp quản lý các tương tác với khách hàng, đây là nền tảng cơ bản để tạo nên mối quan hệ trong kinh doanh. Và cụ thể quản lý quan hệ khách hàng ở đây hướng tới là:

Khách hàng: Là những người, đối tượng tiêu dùng hàng hóa dịch vụ nói chung. Họ là những người có khả năng lựa chọn các sản phẩm và nhà cung cấp khác nhau.

Mối quan hệ trong kinh doanh: Ở đây mối quan hệ kinh doanh là doanh nghiệp với khách hàng, đối tác mà tổ chức đó thường xuyên thực hiện các giao dịch. Điều này giúp bạn có thể dễ dàng đánh giá và thấu hiểu khách hàng của mình, từ đó đưa ra những chiến lược hiệu quả để xây dựng mối quan hệ bền chặt và vững mạnh hơn nữa.

Quản lý: Đây là hoạt động chủ yếu của CRM, nhằm mục tiêu giúp doanh nghiệp kiểm tra, giám sát đối tượng khách hàng cụ thể. Hoạt động này tạo nên những module lớn có thể giúp tổ chức nắm bắt nhu cầu và giải quyết cho khách hàng của mình. Hoạt động này sẽ xoay quanh khách hàng, lấy khách hàng là trung tâm và mọi hoạt động của công ty sẽ được xây dựng dựa trên chủ thể đó.

[caption id="attachment_36292" align="aligncenter" width="800"] CRM là gì ?[/caption]

2. Mục đích của việc sử dụng CRM?

2.1 Cung cấp thông tin cần thiết đầy đủ và chính xác

Hệ thống sẽ luôn có những sơ đồ xác thực kết hợp với tính năng cập nhập dữ liệu tự động hóa, bạn có thể dễ dàng kiểm tra tính chính xác của dữ liệu.

Nhà quản lý có thể xem nhanh các dữ liệu và nắm bắt được các thông tin cơ bản như: Số lượng khách hàng hiện có đang là bao nhiêu? Số lượng khách hàng so với quý trước có thâm hụt không? Doanh thu hiện là bao nhiêu? Ai là người chốt nhiều deal nhất?

[caption id="attachment_36293" align="aligncenter" width="800"] Mục đích của việc sử dụng CRM?[/caption]

2.2 Kết nối với khách hàng ở mọi nền tảng

Sử dụng CRM là một cách hiệu quả giúp bạn tiếp cận đến nhiều đối tượng khách hàng thông qua các phương tiện truyền thông như website, mạng xã hội, điện thoại,... Phần mềm CRM này sẽ cho bạn biết tất tần tật các điểm tiếp cận khách hàng liên quan đến quy trình bán hàng. Từ đó bạn có thể đưa ra hệ thống kênh liên lạc với khách hàng hiệu quả nhất.

2.3 Kết nối các nhân viên với nhau

Nếu có đầy đủ những thông tin cơ bản và cần thiết về khách hàng và môi trường theo thời gian thực thì sẽ giúp các nhân viên tiết kiệm thời gian và phối hợp ăn ý với nhau hơn. Tránh những sự việc tiếp thị quá nhiều lần cho cùng 1 người.

3. Quy trình hoạt động của CRM

Quy trình hoạt động của CRM bao gồm 3 bước cơ bản như sau:

3.1 Tư vấn bán hàng (CRM Sales)

Đây là bước đầu tiên trong quy trinh CRM và cũng là bước cực kỳ quan trọng. Đây là hoạt động triển khai Sales qua các hình thức như: Gửi thư, báo giá, gọi điện, ký hợp đồng, giao dịch thanh toán, báo cáo công nợ…

Sales là nhân viên bán hàng và chắc chắn rồi nhiệm vụ của nhân viên bán hàng là liên tục tìm các đầu mối để chuyển hóa chúng thành cơ hội, thương vụ làm ăn tiềm năng, đồng thời luôn giữ vị trí theo sát các khách hàng nhằm mục đích cuối cùng đó là đóng ký hợp đồng.

Và sau hợp đồng, Account Manager sẽ là những người trực tiếp lên kế hoạch, triển khai, tiến hành thực hiện, tư vấn, thu tiền, cũng như đòi nợ. Thông thường, một Account Manager sẽ chỉ chăm sóc một số lượng khách hàng cụ thể vừa phải, và luôn giữ mối quan hệ thân thiết với nhóm đối tượng đó.

3.2 Truyền thông (CRM Marketing)

CRM Marketing là quy trình giúp doanh nghiệp tiết kiệm phần lớn thời gian trong khâu phân loại, chăm sóc khách hàng theo từng nhóm cụ thể, kích thích người mua hàng qua các công cụ Automation Marketing, ví dụ như: Email marketing, SMS marketing,…

Đồng thời, những phần mềm này luôn được đảm bảo nghiêm ngặt về tính kịp thời, chính xác những công tác phản hồi tới khách hàng.

Không chỉ vậy, quy trình này còn giúp người làm Marketing có điều kiện để phát huy sự sáng tạo cũng như tích lũy kinh nghiệm về các kỹ năng phân tích thông tin. Bên cạnh đó, còn giúp đỡ Team sales dễ dàng theo dõi, cập nhập dữ liệu khách hàng qua hệ thống.

[caption id="attachment_36294" align="aligncenter" width="800"] Truyền thông (CRM Marketing)[/caption]

3.3 Dịch vụ sau bán (CRM Services)

Là một trong những bước rất quan trọng trong việc tăng thiện cảm, níu giữ khách hàng và kích thích khách hàng quay lại với doanh nghiệp, CRM service có thể được thể hiện bằng các hoạt động như: giảm giá, chiết khấu phần trăm, tặng quà, gửi lời chúc trong những ngày lễ tết…

>>> Xem thêm: Tìm hiểu chi tiết về OTP là gì | Ứng dụng của OTP ngày nay

4. Những lợi ích của việc triển khai CRM cho doanh nghiệp

Tăng khả năng xác định và quản lý khách hàng tiềm năng

Hệ thống CRM sẽ thu thập các nguồn thông tin dữ liệu của khách hàng từ nhiều nguồn dữ liệu khác nhau. Qua các điểm tiếp xúc của khách hàng với doanh nghiệp, cụ thể như: Website, Hotline, Email, Các trang mạng xã hội,...

Thông qua việc sử dụng phần mềm quản lý dữ liệu thông tin khách hàng, doanh nghiệp có thể dễ dàng lưu trữ những thông tin cần thiết về khách hàng, giúp doanh nghiệp có thể tiến hành phân tích, từ đó phát hiện ra những cơ hội kinh doanh mới. Cách thức này giúp nâng cao khả năng xác định được khách hàng tiềm năng cũng như quản lý hệ thống khách hàng này một cách dễ dàng hơn.

[caption id="attachment_36295" align="aligncenter" width="800"] Những lợi ích của việc triển khai CRM cho doanh nghiệp[/caption]

Nâng cao năng suất của nhân viên

Phần mềm CRM giúp tạo ra một môi trường làm việc có khả năng tập trung cao, từ đó nâng cao khả năng chia sẻ thông tin dựa trên những dữ liệu của khách hàng đã được lưu trữ trong mạng lưới hệ thống.

Từ đó, nhân viên dễ dàng phân bố thời gian và lịch trình công việc một cách khoa học và có hiệu quả. Nhân viên kiểm soát tốt thời gian trong những cuộc gọi với khách hàng, gọi cho ai, gọi trong bao lâu, tránh được sự sơ sót hay bỏ lỡ trong công việc.

Tối ưu quy trình sale và phục vụ khách hàng

CRM giúp doanh nghiệp và tổ chức có thể cập nhập, lưu trữ cũng như tìm kiếm các thông tin của khách hàng một cách đơn giản, tiến hành phân tích những chiến lược hợp lý và hiệu quả cho doanh nghiệp. Đây là một điểm cộng rất lớn vì nó giúp công ty có thể tối ưu hóa hơn trong các quá trình bán hàng và chăm sóc khách hàng.

Cải thiện những trải nghiệm cho khách hàng, đồng thời nâng cao doanh số bán hàng

Phần mềm CRM có thể hỗ trợ doanh nghiệp so sánh tình hình doanh số qua từng thời điểm và đưa ra bài toán dự đoán tương lai dễ dàng hơn. Từ đó, giúp doanh nghiệp phát hiện những rủi ro tiềm ẩn để kịp thời đưa ra các giải pháp, đẩy mạnh doanh số bán hàng.

Đồng thời, nhờ CRM có các thông tin hữu ích được lưu trữ góp phần thúc đẩy phát triển mối quan hệ lâu dài, gắn bó giữa khách hàng và doanh nghiệp. Khách hàng cũ sẽ cảm thấy được trân trọng khi bạn luôn để tâm huyết và quan tâm họ một cách nghiêm túc như: ngày sinh, sở thích cũng như nhu cầu,…

>>> Xem thêm: Tận hưởng làm việc từ xa dễ dàng với Remote Desktop - Tìm hiểu ngay!

5. Quá trình triển khai hệ thống CRM

5.1 Bước 1: Các bước chuẩn bị trước khi triển khai hệ thống CRM

Xác định mục tiêu cuối cùng của hệ thống CRM

Để chuẩn bị kỹ càng trước khi tiến hành hệ thống CRM bạn phải xác định được đích mà bạn muốn đến. Bạn có thể tìm được mục tiêu chính xác thông qua quá trình thảo luận với các bên liên quan, bao gồm khách hàng. Cách này sẽ giúp bạn khoanh vùng và giới hạn được phạm vi của dự án cũng như đảm bảo đáp ứng đủ nhu cầu của khách hàng.

Lựa chọn hệ thống CRM thích hợp nhất với doanh nghiệp

Để phù hợp với nhu cầu của tổ chức, việc lựa chọn ra được một phần mềm hệ thống CRM tương thích là rất quan trọng. Công việc này đòi hỏi bạn phải có quá trình đánh giá, phân tích tỉ mỉ cách loại CRM hiện có trên thị trường về các mặt như: tính năng, chi phí và khả năng tích hợp.

Chuẩn bị dữ liệu cần thiết

Để triển khai hệ thống CRM, bạn phải chuẩn bị dữ liệu cần thiết, bao gồm việc: sao lưu, dọn dẹp dữ liệu, xác định và nhập dữ liệu các dữ liệu cần thiết vào hệ thống.

5.2 Bước 2: Tối ưu hóa và triển khai CRM phù hợp với doanh nghiệp

Tùy chỉnh, cấu hình của hệ thống CRM

Khi đã chuẩn bị xong các bước trước khi triển khai CRM thì bạn cần tùy chỉnh và cấu hình sao cho thích hợp với môi trường và nhu cầu của doanh nghiệp. Tùy chỉnh ở đây có thể thể hiện qua các mẫu email, báo cáo, bảng điều khiển,...

Đào tạo nhân viên

Để tối đa hóa hiệu quả mà hệ thống CRM có thể mang lại, các nhân viên của doanh nghiệp phải được đào tạo bài bản và nâng cao về trình độ, cũng như nhận biết cách thức để sử dụng và quản lý hệ thống một cách hiệu quả, giúp đảm bảo hoạt động kinh doanh của doanh nghiệp trơn tru.

Xác định hiệu quả

Và để tối ưu hóa quy trình làm việc và triển khai hệ thống CRM, doanh nghiệp cần xác định các quy trình làm việc hiệu quả, như các quy trình: tiếp nhận khách hàng, bán hàng, chăm sóc khách hàng và hỗ trợ sau mua.

5.3 Bước 3: Thực hiện và quản lý quá trình triển khai hệ thống CRM

Chuẩn bị cơ sở hạ tầng và những công cụ cần thiết để triển khai CRM

Để đảm bảo hệ thống CRM hoạt động trong điều kiện tốt nhất, phục vụ tốt cho doanh nghiệp, bạn cần chuẩn bị cơ sở hạ tầng ổn định và các công cụ cần thiết cho quá trình như: phần cứng, phần mềm, mạng, cơ sở dữ liệu,...

Triển khai và quản lý quá trình tiến hành hệ thống CRM

Sau khi tất cả đã hoàn thành, bạn chỉ cần tiến thành thực hiện triển khai hệ thống CRM và giám sát hoạt động triển khai. Nhà quản trị sẽ tiến hành tham gia quản lý và theo dõi quá trình triển khai đảm bảo phát hiện xử lý kịp thời các vấn đề phát sinh. Đồng thời, đánh giá tiến độ và kết quả để điều chỉnh chiến lược, bảo đảm cho kế hoạch đi đúng đúng tiến độ đề ra.

6. Thành công và thất bại của dự án triển khai CRM

Các yếu tố quan trọng trong quá trình triển khai hệ thống CRM

Để triển khai CRM thành công, cần quan tâm đến 2 yếu tố quan trọng sau:

Các yếu tố bên trong:

Chiến lược CRM: Để doanh nghiệp hoạt động một cách hiệu quả, hệ thống thì tất cả mọi hoạt động đều phải có chiến lược quy trình chi tiết, cụ thể. Đặc biệt, những nhà quản trị cấp cao cần phải đưa ra chiến lược quản trị khách hàng một cách đúng đắn và phù hợp với doanh nghiệp, cung như nhu cầu của khách hàng.

Con người: Con người luôn là một trong những nhân tố quan trọng hàng đầu của mỗi doanh nghiệp, tác động, quyết định đến kết quả cuối cùng của hoạt động CRM. Chính vì thế, đồi hỏi nhân viên công ty luôn phải nâng cao ý thức trong việc sáng tạo, bổ sung kiến thức cho bản thân.

Văn hóa doanh nghiệp: Văn hóa của công ty là một trong những giá trị tinh thần, có ảnh hưởng, tác động rất nhiều đến công suất và mức độ hiệu quả công việc của doanh nghiệp. Vì vậy, hãy tạo một môi trường doanh nghiệp có ý thức, văn hóa cao như: luôn đi làm đúng giờ, nhân viên năng động, sáng tạo, tự giác trong công việc.

Công nghệ: Hiện nay, có rất nhiều phần mềm hệ thống CRM được phát hành trên thị trường, chính vì vậy, khi doanh nghiệp quyết định tiến hành áp dụng công nghệ vào tổ chức cần cân nhắc nhiều yếu tố phụ thuộc vào hệ thống.

Các yếu tố từ bên ngoài:

Công chúng: Báo chí, truyền thông, mạng xã hội,... có ảnh hưởng rất lớn đến cái nhìn của khách hàng và thị trường đối với doanh nghiệp

Văn hóa của thị trường: Đây cũng là một trong những yếu tố phải cân nhắc trước khi bắt đầu phát triển sản phẩm hay dịch vụ của doanh nghiệp.

Nhu cầu khách hàng: Đồng thời, nhu cầu mà khách hàng hướng tới cũng là yếu tố then chốt phản ánh sự thành bại trong chiến lược phát triển của doanh nghiệp.

Và để đáp ứng đầy đủ những yêu cầu của khách hàng, cũng như xây dựng nên mối quan hệ thân thiết giữa doanh nghiệp và khách hàng thì trước tiên chúng ta cần phải hiểu khách hàng, biết họ mong muốn những gì, và cần gì từ doanh nghiệp?

Nguyên nhân thất bại khi triển khai CRM và cách tránh

Có một số nguyên nhân có thể dẫn đến thất bại của doanh nghiệp khi triển khai hệ thống quan lý quan hệ khách hàng, dưới đây sẽ là những nguyên nhân tiêu biểu cũng như cách ứng phó với chúng:

Tính bảo mật: Bảo mật luôn phải được coi là yếu tố quan trọng hàng đầu của các doanh nghiệp, nếu tổ chức coi nhẹ vấn đề này, thì đây sẽ trở thành nguyên nhân thất bại chết người cho chính doanh nghiệp đó. Chính vì vậy, đừng nên quá tiết kiệm và chi li trong các vấn đề liên quan đến bảo mật trong quá trình lựa chọn phần mềm CRM phù hợp nhất.

Sự quyết tâm: CRM là một trong những cách quản lý hiệu quả, tuy nhiên triển khai CRM không phải là một quá trình đơn giản mà nó đòi hỏi rất nhiều nỗ lực và công sức của cả một hệ thống. Có rất nhiều doanh nghiệp phải mất một khoảng thời gian dài trải qua nhiều lần chuyển đổi sử dụng phần mềm CRM vì không phù hợp. Vì vậy, nếu muốn thành công trên con đường này, doanh nghiệp phải nghiêm túc, tâm huyết và theo đuổi đến cùng.

Sự đơn giản: Nhiều doanh nghiệp mới đầu quá vội vã mà triển khai những phần mềm quá phức tạp, dân đến không hiệu quả mà còn tốn thời gian. Chính vì thế, bước đầu tổ chức nên đi từ những bước cơ bản và đơn giản, dễ hiểu, xây dựng từ căn bản rồi mới từ từ nâng cấp hệ thống lên cao hơn.

[caption id="attachment_36298" align="aligncenter" width="800"] Nguyên nhân thất bại khi triển khai CRM và cách tránh[/caption]

Những bài viết liên quan:

Hệ quản trị cơ sở dữ liệu là gì? Top 9 hệ quản trị csdl phổ biến

CentOS là gì? Hướng dẫn cài đặt hệ điều hành CentOS hiệu quả

Kafka là gì? Giới thiệu tổng quan về Kafka chi tiết từ A – Z

PostgreSQL là gì? Tìm hiểu về hệ quản trị cơ sở dữ liệu PostgreSQL

Triển khai hệ thống CRM là một quá trình dài yêu cầu nhiều yếu tố như: thời gian, tiền bạc,... nó không phải là một quá trình đơn giản. Nhưng nếu kiên trì nỗ lực thì lợi nhuận cũng như thành công sẽ sớm đến với bạn và doanh nghiệp của mình. Mong rằng bài viết trên chia sẻ CRM là gì cung cấp cho bạn những thông tin cần thiết, giúp ích cho quá trình triển khai CRM của bạn.

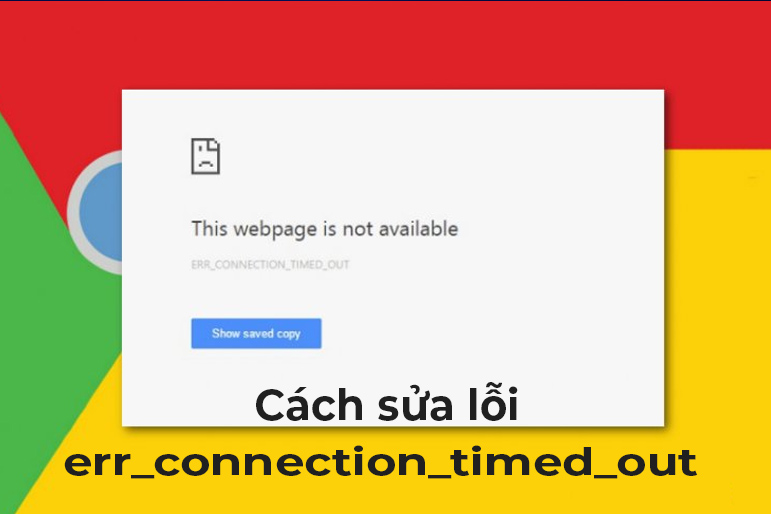

Sửa lỗi err_connection_timed_out trên Chrome đơn giản từ A-Z

15:34 13/08/2024

Err_connection_timed_out là lỗi khá phổ biến mà hầu như người dùng máy tính nào cũng gặp phải. Khi xuất hiện thông báo lỗi này, người dùng sẽ không thể truy cập được vào trang web khiến cho công việc bị gián đoạn. Ngay sau đây sẽ là cách khắc phục lỗi err_connection_timed_out vô cùng đơn giản. Cùng khám phá ngay nhé.

>>> Xem thêm: Disaster Recovery – Dịch vụ khôi phục hệ thống sau thảm họa

1. Lỗi err_connection_timed_out là lỗi gì?

Ngay bây giờ, không để bạn phải đợi lâu hơn nữa, hãy cùng chúng tôi giải nghĩa xem err_connection_timed_out là gì nhé. Theo như dịch nghĩa thì Connection timed out là kết nối của bạn đã vượt quá thời gian quy định. Lỗi ngày xuất hiện nếu sau khoảng 1 phút mà trang web chúng ta đang kết nối chưa xuất hiện dữ liệu. Lúc này, trình duyệt web sẽ báo để chúng ta có phương án khác thích hợp hơn mà không phải chờ thêm.

2. Hướng dẫn cách sửa lỗi err_connection_timed_out trên Chrome

Bạn đã biết err_connection_timed_out là lỗi gì rồi chứ? Vậy nếu như chúng ta gặp phải lỗi ngày thì nên giải quyết như thế nào đây? Đừng quá lo lắng, sau đây sẽ là 6 cách khắc phục để bạn lựa chọn.

2.1 Tải lại trang

Err_connection_timed_out Chrome báo lỗi không tải được dữ liệu thì cách đơn giản nhất mà chúng ta nên áp dụng đầu tiên đó chính là tải lại trang. Hãy nhấn vào biểu tượng mũi tên cong trên màn hình hoặc nhấn vào phím F5. Lúc này, trang web sẽ tự tải lại và việc của chúng ta đó là chờ xem lỗi có được khắc phục hay không. Nếu vẫn chưa được thì chuyển ngay sang cách 2 nhé.

[caption id="attachment_15664" align="aligncenter" width="771"] Nhấn vào biểu tượng mũi tên cong trên màn hình để tải lại trang[/caption]

2.2 Kiểm tra kết nối Internet

Err connection timed out có thể nguyên nhân là do kết nối internet của chúng ta không ổn định. Áp dụng cách 1 không thành công hãy kiểm tra xem đường truyền mạng của bạn có ổn định không nhé. Sau khi đã xác định internet của chúng ta không vấn đề thì thực hiện tải lại trang.

Đây cũng là cách khắc phục lỗi err_connection_timed_out trên điện thoại đơn giản nhất mà bạn có thể áp dụng. Tắt internet rồi bật lại và tải lại web xem sao nhé.

[caption id="attachment_15668" align="aligncenter" width="771"] Kiểm tra lại kết nối internet của máy[/caption]

2.3 Xóa bộ nhớ đệm Cache

Trong một vài trường hợp do Google Chrome đã lưu trữ thông tin về lý do vì sao chúng ta không tải được trang. Bạn nên kiểu tra bộ nhớ cache và xóa chúng theo hướng dẫn dưới đây để có thể tải được trang mà mình mong muốn.

Bước 1: Đầu tiên, hãy bấm vào biểu tượng dấu ba chấm nằm ở góc trên cùng bên phải của màn hình. Sau đó chọn đến Công cụ khác. Cuối cùng là Xóa dữ liệu duyệt web.

[caption id="attachment_15676" align="aligncenter" width="771"] Thực hiện Xóa dữ liệu duyệt web[/caption]

Bước 2: Lúc này, hộp thoại mới sẽ hiện ra, bạn chọn tiếp vào Từ trước đến nay. Sau đấy tích chọn vào 3 mục như hình bên dưới. Cuối cùng là Bấm Xóa dữ liệu để kết thúc quá trình thực hiện. Việc xóa bộ nhớ cache đã hoàn tất. Bây giờ hãy tải lại trang web xem đã được hay chưa nhé.

[caption id="attachment_15680" align="aligncenter" width="771"] Chọn Xóa dữ liệu[/caption]

>>> Xem thêm: Lỗi DNS server isn’t responding là gì? Nguyên nhân & cách sửa lỗi

2.4 Tắt bớt các ứng dụng hay tab trên trình duyệt

Xảy ra lỗi err_connection_timed_out, bạn đã thực hiện đầy đủ các cách trên mà vẫn chưa khắc phục được? Vậy hãy thử cách đóng các ứng dụng hoặc tab khác xem sao nhé.

Khi bộ nhớ thiết bị của chúng ta đã hết thì cũng không thể tải lại trang web nếu như bạn mở cùng 1 lúc quá nhiều ứng dụng, chương trình và tiện ích khác nhau. Giải phóng bộ nhớ của chúng ta ngay lập tức theo các bước sau:

Bước 1: Thực hiện đóng lại tất cả các tab ngoại trừ tab đang bị lỗi.

Bước 2: Tiếp đó là tắt các ứng dụng hoặc chương trình mà chúng ta đang chạy và ngưng tải các dữ liệu.

Bước 3: Bấm chọn vào biểu tượng dấu ba chấm ở góc trên cùng bên phải của màn hình. Tiếp theo là Công cụ khác và chọn đến Tiện ích mở rộng.

[caption id="attachment_15684" align="aligncenter" width="771"] Chọn vào tiện ích mở rộng[/caption]

Bước 4: Lúc này, web sẽ hỏi bạn có muốn xóa các tiện ích mà bạn không sử dụng hay không. Hãy chọn vào Xóa. Lúc này, chỉ việc mở lại tab bị lỗi và thử xem đã kết nối được chưa.

[caption id="attachment_15688" align="aligncenter" width="771"] Xóa dữ liệu[/caption]

2.5 Khởi động lại máy tính

Trong một vài trường hợp, một chương trình hoặc ứng dụng nào đó ngăn cản việc tải trang của bạn. Cách đơn giản để khắc phục tình trạng này đó là khởi động lại máy tính của bạn để làm mới nó. Sau đó tải lại trang bị lỗi.

[caption id="attachment_15692" align="aligncenter" width="771"] Khởi động lại máy tính để khắc phục sự cố[/caption]

2.6 Cập nhật lại ứng dụng Chrome

Tiếp theo trong số những cách khắc phục lỗi err_connection_timed_out khi tải trang đó là thực hiện cập nhật lại ứng dụng Chrome trên máy tính của bạn. Cách thức này bao gồm 3 bước là:

Bước 1: Cũng chọn bấm vào biểu tượng dấu ba chấm nằm ở góc trên cùng phía bên phải của màn hình máy tính sau đó chọn Cài đặt.

[caption id="attachment_15698" align="aligncenter" width="771"] Chọn vào phần cài đặt của máy[/caption]

Bước 2: Phần cài đặt của máy tính sẽ hiện lên. Lúc này, chúng ta chọn vào Giới thiệu về Chrome. Máy tính sẽ cần vài phút để tiến hành cập nhật phiên bản Chrome mới về máy. Nếu như không thấy phần cập nhật chạy thì có nghĩa là Chrome của bạn đã được cập nhật mới trước đó rồi.

[caption id="attachment_15702" align="aligncenter" width="771"] Chọn giới thiệu về Chrome[/caption]

Bước 3: Đợi đến khi máy tính cập nhật Chrome xong, chỉ việc bấm vào Chạy lại và tiến hành tải lại trang web bị lỗi truy cập.

[caption id="attachment_15706" align="aligncenter" width="771"] Đợi chạy lại Chrome[/caption]

>>> Xem thêm: Sửa lỗi Mysql Server Has Gone Away Đơn Giản & Hiệu Quả

3. Cách sửa lỗi err_connection_timed_out trên Command Prompt

Cuối cùng là cách sửa lỗi err_connection_timed_out trên Command Prompt để bạn có thể áp dụng và khắc phục. Bắt đầu ngay thôi.

Bước 1: Trước hết, hãy nhập lệnh cmd vào trong ô tìm kiếm. Sau đó chọn Run as Administrator.

[caption id="attachment_15710" align="aligncenter" width="771"] Chọn Run as Administrator[/caption]

Bước 2: Tiếp theo, nhập lệnh ipconfig/release > Bấm Enter.

[caption id="attachment_15716" align="aligncenter" width="771"] Nhập lệnh ipconfig/release[/caption]

Bước 3: Tiếp tục nhập lệnh ipconfig/flushdns và nhấn Enter.

[caption id="attachment_15720" align="aligncenter" width="771"] Nhập lệnh ipconfig/flushdns[/caption]

Bước 4: Tiếp tục nhập lệnh ipconfig/renew > Bấm Enter.

[caption id="attachment_15724" align="aligncenter" width="771"] Nhập lệnh ipconfig/renew[/caption]

Bước 5: Tiếp tục nhập lệnh netsh in ip set dns > Bấm Enter.

[caption id="attachment_15728" align="aligncenter" width="771"] Nhập lệnh netsh in ip set dns[/caption]

Bước 6: Tiếp tục nhập lệnh netsh winsock reset > Bấm Enter.

[caption id="attachment_15732" align="aligncenter" width="771"] Nhập lệnh netsh winsock reset[/caption]

Những bài viết liên quan:

Cách sửa lỗi “Server Execution Failed” Đơn Giản & Hiệu Quả

503 Service Unavailable là lỗi gì? Nguyên nhân & cách khắc phục

Như vậy là những thông tin về err_connection_timed_out đã được FPT Cloud giới thiệu đầy đủ và chi tiết trong bài viết. Nếu bạn đang gặp phải sự cố này thì hãy thực hiện theo những cách trên để không ảnh hưởng đến công việc của mình nhé.

Hướng dẫn cách gửi Mail trên máy tính cùng các tùy chọn khác

14:21 13/08/2024

Cách gửi Mail thực hiện như thế nào để tận dụng hết mọi tính năng? Đây là câu hỏi không phải ai cũng trả lời được một cách toàn diện nhất. Nếu bạn là người chuyên trao đổi công việc qua thư điện tử, đừng bỏ qua bài viết này nhé! FPT Cloud sẽ hướng dẫn cách gửi Mail trên máy tính với từng trường hợp. Hãy đọc ngay để làm việc chuyên nghiệp và hiệu quả hơn.

>>> Xem thêm: Dịch vụ cho thuê VPS tốc độ cao giá rẻ, uy tín tại FPT Cloud

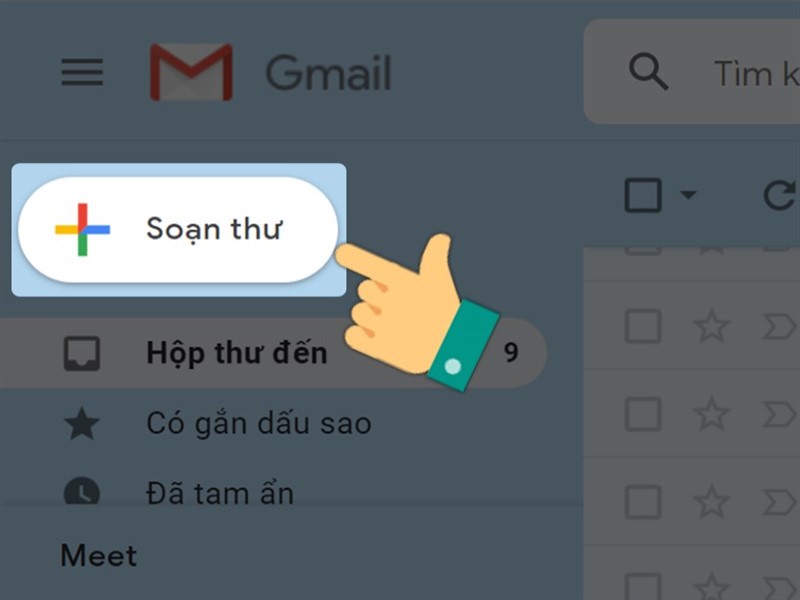

1. Hướng dẫn cách gửi Mail đơn giản nhất

Để bắt đầu, bạn nên học cách gửi Mail trên máy tính. Bởi lẽ, đây là thiết bị phục vụ thường trực cho mọi công việc. Đối với hình thức trao đổi thư điện tử trên Android, Iphone và Ipad cũng tương tự. Dưới đây là những bước căn bản nhất dành cho bạn:

Bước đầu tiên để học cách gửi Mail là truy cập vào Gmail.

Hướng mắt sang phía trên cùng ở bên trái, nhấp vào biểu tượng “Soạn thư”.

Trong trường “Tới”, bạn cần thêm địa chỉ Mail của người nhận. Để gửi cho một số đối tượng cùng lúc, bạn dùng chức năng “Cc” và “Bcc”. Từng loại có ý nghĩa như thế nào sẽ được giải thích trong phần bên dưới.

Thêm tiêu đề theo mục đích gửi thư của bạn. Phần này nên để ngắn gọn, dễ hiểu để kiểm soát tốt hơn.

Ngay bên dưới là khoảng trống để nhập văn bản, nội dung thư bạn muốn gửi đi.

Nhấp nút “Gửi” ở cuối trang là đã hoàn tất cơ bản cách gửi Mail.

Khi mới làm quen cách gửi Gmail trên máy tính, bạn nên làm theo từng bước hướng dẫn như trên. Nhiều người thường tập trung viết nội dung đầu tiên và sau đó quên đặt tiêu đề. Điều đó làm ảnh hưởng không nhỏ đến hiệu quả truyền tải thông tin.

[caption id="attachment_26366" align="aligncenter" width="800"] Bước đầu tiên trọng cách gửi Mail là nhấn vào mục “Soạn thư”[/caption]

>>> Xem thêm: Cách đổi mật khẩu Gmail chi tiết trên điện thoại PC

2. Cách gửi Mail trên máy tính bằng chế độ bảo mật

Trước khi đến với cách gửi Mail trên máy tính này, bạn cần xác định loại tài khoản mình đang sử dụng. Nếu đó là Acccount làm việc do công ty tạo hoặc được trường học cấp sẽ cần lưu tâm hơn.

Trong trường hợp này, bạn liên hệ với quản trị viên. Họ sẽ kiểm tra và phản hồi lại để đảm bảo có thể sử dụng chế độ bảo mật. Nếu đó là Gmail cá nhân thông thường không cần thiết làm như vậy. Người sử dụng trực tiếp khai thác tính năng bằng cách sau:

Với cách gửi Mail này, bạn cũng bắt đầu bằng việc truy cập website của Gmail.

Nhấp vào biểu tượng “Soạn thư” góc trên cùng phía bên tay trái, một cửa sổ sẽ hiện lên.

Ở dưới cùng bên phải cửa sổ này sẽ có biểu tượng của chế độ bảo mật. Chức năng được ký hiệu bằng một chiếc khóa đặt cạnh đồng hồ.

Tại đây bạn sẽ thiết lập ngày hết hạn cùng mật mã. Các tùy chọn này có tác động đến cả nội dung văn bản trong thư cũng như mọi tệp đính kèm.

Hướng dẫn cách gửi Mail cùng chế độ bảo mật chỉ đơn giản như vậy nhưng cần lưu ý thêm. Nếu bạn chọn “Không sử dụng mật mã qua SMS”, người nhận dùng ứng dụng Gmail mở được trực tiếp.

Trái lại, khi bạn chọn “Mật mã qua SMS” điều ngược lại sẽ xảy ra. Người kia sẽ nhận được mật mã qua tin nhắn văn bản. Tuy nhiên, bạn cần đảm bảo nhập đúng số điện thoại người nhận chứ không phải số của mình. Sau đó, hãy nhấn “Save” để hoàn tất.

[caption id="attachment_26372" align="aligncenter" width="800"] Chế độ bảo mật giúp giữ kín nội dung Gmail[/caption]

3. Sử dụng tính năng hoàn tác

Trong nhiều trường hợp bạn sẽ phát sinh những điều cần chỉnh sửa nhưng đã lỡ ấn “Gửi”. Nếu vậy cũng đừng lo lắng vì sẽ có khoảng thời gian ngắn sau khi gửi để hủy Email. Thao tác này được gọi là hoàn tác với bước thực hiện như sau:

Sau khi ấn gửi thư sẽ thấy phía dưới cùng bên trái xuất hiện thông báo. Trong đó bao gồm “Đã gửi thư” và tùy chọn “Hoàn tác” hoặc “Xem thư”.

Bạn chỉ cần nhấp vào “Hoàn tác” là hoàn thành. Như vậy, người chỉ định ở trong Mail sẽ không nhận được nữa.

Bên cạnh đó bạn còn có thể chọn khoảng thời gian để lấy lại thư. Nó được tính từ khi nhấn nút “Gửi” tới khi thực sự gửi đi. Khi chưa chắc chắn về quyết định bạn nên tăng số giây lên. Các bước như sau:

Truy cập Gmail.

Bạn sẽ nhìn thấy biểu tượng cài đặt phía trên cùng, bên phải.

Bên cạnh mục “Hoàn tác gửi”, hãy chọn khoảng thời gian hủy là 5, 10, 20 hoặc 30 giây.

Học cách gửi Mail này sẽ giúp bạn chắc chắn truyền tải đến người nhận nội dung chính xác nhất. Điều này càng quan trọng hơn khi thông tin liên quan tới công việc, giao dịch,…

[caption id="attachment_26376" align="aligncenter" width="800"] Bạn có thể điều chỉnh thời gian hủy gửi[/caption]

4. Phân biệt các tùy chọn thêm người nhận

Khi học cách gửi Mail, nhiều người cảm thấy khá lúng túng vì có nhiều tùy chọn thêm người nhận. Vì thế, phần dưới đây sẽ giúp bạn so sánh và nhận ra bản chất của từng loại. Hãy tham khảo và gửi thư theo cách thông minh nhất nhé!

Tùy chọn

Chức năng

✅Cc

- Bạn có thể thêm địa chỉ Mail của nhiều người nhận vào trường “Cc”.- Đối với kiểu này, người được thêm vào luồng Mail nhằm mục đích nắm được tiến trình công việc. Họ không nhất thiết phải phản hồi lại.- Những người trong mục “Cc” đều nhìn thấy địa chỉ Email của nhau.

✅Bcc

- Cách gửi Mail này cũng áp dụng để nhiều người cùng nhận thư một lúc.- Tuy nhiên, mỗi cá nhân sẽ không biết được danh sách những người cùng nhận chung với mình.- Cuộc hội thoại giữa người nhận trong Bcc và người gửi là độc lập. Những người khác trong danh sách Bcc sẽ không nhìn thấy cũng như không tham gia vào được.

Để gửi cho nhiều người cùng lúc, bạn dùng dấu phẩy để tách biệt tên hoặc địa chỉ Email. Nếu có một nhóm cố định thường xuyên liên lạc có thể tạo group để tiện lợi hơn.

[caption id="attachment_26380" align="aligncenter" width="800"] Người sử dụng cần phân biệt được đặc điểm, chức năng của Cc và Bcc[/caption]

>>> Xem thêm: Theme Wordpress là gì? Hướng dẫn cách add theme Wordpress chi tiết

5. Cách gửi mail trên máy tính thông qua Outlook

Đối với những người thường xuyên làm việc qua Email, công ty yêu cầu thực hiện trên Outlook. Đây là phần mềm quản lý thông tin các nhân của Microsoft. Trao đổi Email là một trong những chức năng chính của công cụ này.

Qua đó, bạn dễ dàng quản lý danh bạ người nhận cùng nhiều tính năng ổn định hơn. Vì thế, học cách gửi Mail qua Outlook cũng rất quan trọng. Các bước gần như tương tự với việc sử dụng Gmail. Cụ thể như sau:

Chọn “Email mới”.

Thêm người nhận, chủ đề và thông điệp trong mục “Đến”.

Nếu muốn Cc hoặc Bcc ai hãy nhấp ô ngay bên dưới.

Khi gửi kèm tệp, nhấn vào chức năng “Attached File”.

Chọn “Gửi”.

[caption id="attachment_26384" align="aligncenter" width="800"] Công cụ Outlook rất thông dụng trong trao đổi thông tin[/caption]

Chỉ với những bước đơn giản như vậy là bạn đã hoàn thành cách gửi Mail trên Outlook. Hãy trải nghiệm để thấy sự nhanh chóng, sắp xếp khoa học đến từ công cụ này.

Những bài viết liên quan:

Hướng dẫn khắc phục lỗi “Outlook data file cannot be accessed”

Hướng dẫn cách cài Mail công ty vào Outlook 2019

Email Hosting là gì? Cách sử dụng dịch vụ Email Hosting hiệu quả

Cách thu hồi Email đã gửi trên Gmail và Outlook chi tiết

Trên đây là những kỹ năng văn phòng cơ bản nhưng rất quan trọng, ai cũng nên thành thạo. Bạn sẽ thấy việc tiếp cận và thực hành dễ hiểu, đơn giản ngay từ lần trải nghiệm đầu tiên. FPT Cloud tin rằng quý bạn đọc đã nắm vững cách gửi Mail hiệu quả nhất.

Subnet Mask là gì? Tìm hiểu về cách chia Subnet Mask từ A – Z

11:53 13/08/2024

Subnet Mask là gì là vấn đề được rất nhiều người quan tâm. Khi truy cập internet, các thiết bị sẽ đều có địa chỉ IP gồm 2 phần, đó là host/client address và network address. Trong đó, 2 thành phần host address và network address sẽ được phân chia bởi Subnet Mask. Vậy subnet mask là gì? Cách chia subnet mask thế nào? Hãy cùng FPT Cloud tìm hiểu chi tiết từ A - Z về Subnet qua bài viết dưới đây.

>>> Xem thêm: Cloud Server là gì? Hoạt động của hệ thống máy chủ đám mây

1. Subnet là gì?

Subnet là một số dạng 32 bit. Để tạo ra Subnet mask, người ta sẽ đặt host bit dưới dạng số 0 và network bit dạng số 1. Từ đó tạo ra các dãy số có dạng nhị phân là 0 và 1 để phân chia địa chỉ IP thành 2 phần, tương ứng với địa chỉ mạng và địa chỉ host.

Địa chỉ mạng thường có số 0 và địa chỉ broadcast thường có số 255. Ngoài ra, địa chỉ IP, Subnet Mask và router sẽ có các cấu trúc riêng. Tùy từng khu vực, từng địa chỉ mà địa chỉ thể hiện sẽ có sự khác biệt. Người dùng có thể dựa vào các số này để xác định chính xác IP và route của mình.

[caption id="attachment_16060" align="aligncenter" width="771"] Giải đáp: subnet là gì?[/caption]

Khi các đơn vị bổ sung subnetworking, đơn vị cần sử dụng subnetting, sau đó chia host thành một subnet. Chính vì thế, khi tìm hiểu subnet là gì, bạn cần lưu ý, mục tiêu chính của subnet mask đó là kích hoạt quá trình subnetting. Trong đó, subnet mask sẽ có tác dụng che địa chỉ IP của bạn dưới dạng các số 32 bit. Đây cũng là lý do vì sao Subnet Mask có từ “mask” - mặt nạ ở trong tên gọi.

2. Cách thức hoạt động của Subnet mask

Sau khi đã tìm hiểu Subnet là gì, chắc chắn bạn sẽ không thể bỏ qua cách thức hoạt động của dạng số này. Như đã giải thích ở trên, Subnet mask chia mạng thành nhiều phần, dưới dạng sub-network hoặc subnet.

Người dùng có thể giảm lưu lượng mạng bằng Subnet mà không cần cài đặt, lắp bổ sung một mạng mới. Điều này giúp việc sử dụng internet dễ dàng hơn. Giờ đây, chỉ cần một mạng tổng, các đơn vị đã có thể chia thành nhiều mạng con để sử dụng mà không lo quá tải hệ thống.

Đặc biệt, với các đơn vị chỉ sử dụng một mạng cục bộ LAN duy nhất và phải chia thành nhiều phân đoạn, việc sử dụng Subnetting sẽ vô cùng quan trọng và cần thiết. Sử dụng subnetting sẽ giúp bạn:

Giảm được lưu lượng tải mạng do giảm khối lượng broadcast

Giúp người dùng có thể làm việc tại nhà nhưng vẫn sử dụng được mạng cục bộ.

Tổ chức có thể vượt qua các ràng buộc của mạng LAN, vượt qua số lượng host tối đa theo quy định.

[caption id="attachment_16080" align="aligncenter" width="771"] Subnet mask chia mạng thành nhiều phần, dưới dạng sub-network hoặc subnet[/caption]

>>> Xem thêm: PING là gì? Đánh giá chỉ số Ping khi kiểm tra tốc độ mạng

3. Cách tính và xác định lớp IP

Để việc sử dụng Subnet mask hiệu quả, người dùng cần lưu ý cách tính và xác định lớp IP. Để xác định, bạn có thể dựa vào các bit bậc cao hoặc bit ở ngoài cùng, bên trái của địa chỉ IP. Bất cứ địa chỉ IP nào cũng có thể được xác định bằng cách làm này. Một địa chỉ IP sẽ có 5 lớp mạng, được chia thành các lớp, đánh ký hiệu từ A - E và địa chỉ IP sẽ nằm trong các lớp này.

Trong đó:

Mạng A thể hiện phần mạng đầu tiên. Người dùng có thể phân chia các host thành octet 2, 3, 4 khi cần thiết. Các mạng có hơn 65.534 host nên sử dụng subnet mask A.

Subnet mask B thể hiện 2 phần octet 1 và 2. Người dùng có thể dùng octet 3 và 4 để phân chia các phần host. Octet 3 và 4 có dạng 16 bit. Các mạng có số lượng host từ 256 - 65.534 host thích hợp để sử dụng Subnet mask class B.

Subnet mask C thể hiện 3 octet 1, 2 và 3. Vì thế, người dùng chỉ có thể phân chia host ở octet 4 và sử dụng trong 8 bit còn lại. Subnet mask C phù hợp với các mạng có số lượng host nhỏ hơn 256.

Subnet mask D dành riêng cho multicast

Subnet mask E không được dùng trong internet thông thường mà thường được sử dụng khi nghiên cứu.

Các lớp mạng A, B, C có thể có subnet mask tự nhiên hoặc mặc định:

Class A: 255.0.0.0

Class B: 255.255.0.0

Class C: 255.255.255.0

Từ đó, người dùng có thể dựa trên subnet mask mặc định để xác định được số lượng Host. Đồng thời, xác định được địa chỉ IP mà mạng cục bộ đang sở hữu.

4. Vì sao cần tính và chia Subnet mask?

Khi tìm hiểu Subnet là gì, nhiều người sẽ thường thắc mắc tại sao cần tính và chia công cụ này. Trên thực tế, hiện nay, hầu hết các công ty, doanh nghiệp, tổ chức đều có nhu cầu truy cập vào mạng LAN cực kỳ lớn. Các đơn vị thường sử dụng nhiều thiết bị như laptop/PC.

Mỗi máy tính sẽ có một dây mạng riêng. Điều này khiến cấu trúc mạng bị ảnh hưởng, tốc độ truy cập chậm đi, bị giới hạn do việc kết nối quá nhiều. Điều này dẫn tới việc khi kết nối sẽ tạo ra các con số khác nhau, không đúng chuẩn.

[caption id="attachment_16064" align="aligncenter" width="771"] Người dùng sẽ sử dụng các lớp từ A – E để phân chia host trong mạng nội bộ[/caption]

Ngoài ra, việc kết nối thiết bị, quản lý thiết bị cũng gặp nhiều khó khăn. Đặc biệt là trong việc tính các chỉ số và số lượng băng thông. Vì thế, subnet mask đã được tạo ra để giúp người dùng giải quyết khó khăn này.

Khi tìm hiểu Subnet là gì, chúng ta đã biết, Subnet mask sẽ phân chia địa chỉ IP. Subnet mask hoạt động thông qua việc hạn chế phạm vi hoạt động, giúp hạn chế, giảm thiểu tối đa tình trạng tắc nghẽn mạng khi sử dụng đồng thời nhiều thiết bị.

Trong quá trình sử dụng, nếu người dùng gặp trục trặc, Subnet mask cũng sẽ bị động khắc phục ở phạm vi cục bộ, không làm ảnh hưởng tới hệ thống mạng chung. Hệ thống mạng lớn sẽ được bảo vệ toàn diện hơn, hiệu quả hơn khi sử dụng Subnet mask.

5. Cách chia Subnet như thế nào?

Subnet mask chia thành các lớp từ A - E. Người dùng sẽ sử dụng các lớp này để phân chia host. Mỗi lớp sẽ tương ứng với 1 số lượng host. Chẳng hạn như lớp C là 256 Host. Để chia subnet, bạn chỉ cần lấy số lượng host này, chia cho tổng số mạng con. Lúc này, số địa chỉ ban đầu vẫn được giữ nguyên. Tuy nhiên, chúng ta đã chia mạng tổng thành các mạng con và mỗi mạng con sẽ có số địa chỉ ít hơn.

[caption id="attachment_16076" align="aligncenter" width="771"] Subnet có vai trò quan trọng trong việc phân chia và quản lý các mạng nội bộ[/caption]

Chẳng hạn như bạn lấy 256 host của lớp C chia cho 8 mạng con. Do trong số 256 Host đã có 2 host được sử dụng để xác định địa chỉ mạng và địa chỉ Broadcast nên chúng ta còn 254 host. Sau khi chia đều cho 8 mạng con, chúng ta có 32 địa chỉ trong mỗi mạng.

Lúc này, các subnet trong mỗi mạng con sẽ cung cấp 2 địa chỉ subnet và broadcast, tức là mỗi mạng con còn sẵn 30 host. Như vậy, số lượng host đã được giảm và việc sử dụng sẽ hiệu quả hơn, việc quản lý cũng dễ dàng hơn.

Tương tự, bạn có thể áp dụng để tính đối với các lớp khác. Đây là một nội dung cực kỳ quan trọng khi bạn tìm hiểu subnet là gì.

>>> Xem thêm: Web server là gì? Tìm hiểu cơ chế hoạt động của web server

6. Hướng dẫn cách tính Subnet Mask chi tiết

Để tính đúng và chính xác subnet mask, bạn cần thực hiện 4 bước sau:

Chuyển đổi sang hệ nhị phân

Tính địa chỉ Subnet

Tìm phạm vi của Host

Tính tổng số Subnet và host trên mỗi mạng riêng.

Trong quá trình tìm hiểu subnet là gì, chắc chắn không thể bỏ qua cách tính kiểu số này. Để giúp người dùng hiểu rõ hơn các tính subnet, chúng ta sẽ cùng tìm hiểu một ví dụ cụ thể với lớp C.

6.1 Bước 1: Chuyển đội sang hệ nhị phân

Trước tiên, tại Class C, người dùng lấy 5 bit để chia cho các mạng con, sau đó để lại 3 bit dùng cho máy chủ. Như vậy, chúng ta có thể có tối đa 32 bit cho 1 mạng con. Sau đó, tiến hành chuyển đổi địa chỉ IP bạn đang có sang hệ nhị phân.

Chẳng hạn, địa chỉ IP có bạn có dạng: 192.168.10.44. Vậy khi đổi sang hệ nhị phân sẽ có dạng:

192

168

10

44

11000000

10101000

00001010

00101100

[caption id="attachment_16084" align="aligncenter" width="771"] Trước tiên, người dùng cần chuyển đổi sang dạng nhị phân[/caption]

6.2 Bước 2: Tính địa chỉ Subnet

Sau khi chuyển sang hệ nhị phân, bạn có thể dễ dàng tính được địa chỉ IP Subnet bằng cách thực hiện theo tác AND theo quy tắc:

1 + 1 = 1

1 + 0 = 0

0 + 1 = 0

0 + 0 = 0

Hãy tính dựa trên IP Host và subnet mask để tìm được địa chỉ subnet chứa host.

6.3 Bước 3: Tìm phạm vi của Host

Trước khi chuyển đổi sang hệ nhị phân, chúng ta đã dùng 5 bit ở Class C. 5 Bit này được sử dụng trong việc xác định subnet. 3 bit còn lại dùng để xác định host trong một mạng con cụ thể. Để xác định địa chỉ subnet, bạn cần xác định tất cả các bit 0 trong host. Địa chỉ broadcast sẽ là tất cả các bit 1.

Hãy lưu ý, host đầu tiên sẽ được xác định bởi các số 0 và 1. Ngược lại, host cuối cùng được xác định bởi số 1 và 0. Bạn cần tránh nhầm lẫn giữa các thứ tự này để không tính nhầm phạm vi của host.

[caption id="attachment_16068" align="aligncenter" width="771"] Sơ đồ hướng dẫn tìm phạm vi của host[/caption]

6.4 Bước 4: Tính tổng số subnet và host trên mỗi subnet

Bước tính tổng subset là bước cuối cùng và cũng là bước bạn không thể bỏ qua khi tìm hiểu subnet là gì. Sau khi đã có được chính xác số lượng subnet và host của mạng LAN, bạn có thể tính cho từng mạng riêng lẻ. Bạn cũng sẽ sử dụng hệ nhị phân để tính tổng subnet và host trên từng mạng lẻ. Cụ thể giả định các số là 0 và các mạng con là số 1.

Những bài viết liên quan:

Host là gì? Toàn tập kiến thức về Host từ A đến Z

XMLRPC là gì? Ứng dụng & cách vô hiệu hóa XMLRPC khi cần

Có thể thấy, cách tính subnet mask không hề đơn giản. Bạn cần lưu ý các quy tắc đổi sang hệ nhị phân và cách chia subnet để việc tính toán chính xác và hiệu quả nhất. Hy vọng qua bài viết trên đây của FPT Cloud, bạn đã hiểu subnet là gì và biết về cách thức hoạt động, cách chia subnet mask để giảm tải áp lực cho mạng tổng khi sử dụng cho nhiều thiết bị. Để việc sử dụng, lưu trữ hiệu quả, bạn có thể xem thêm bảng giá thuê cloud server và dịch vụ máy chủ.

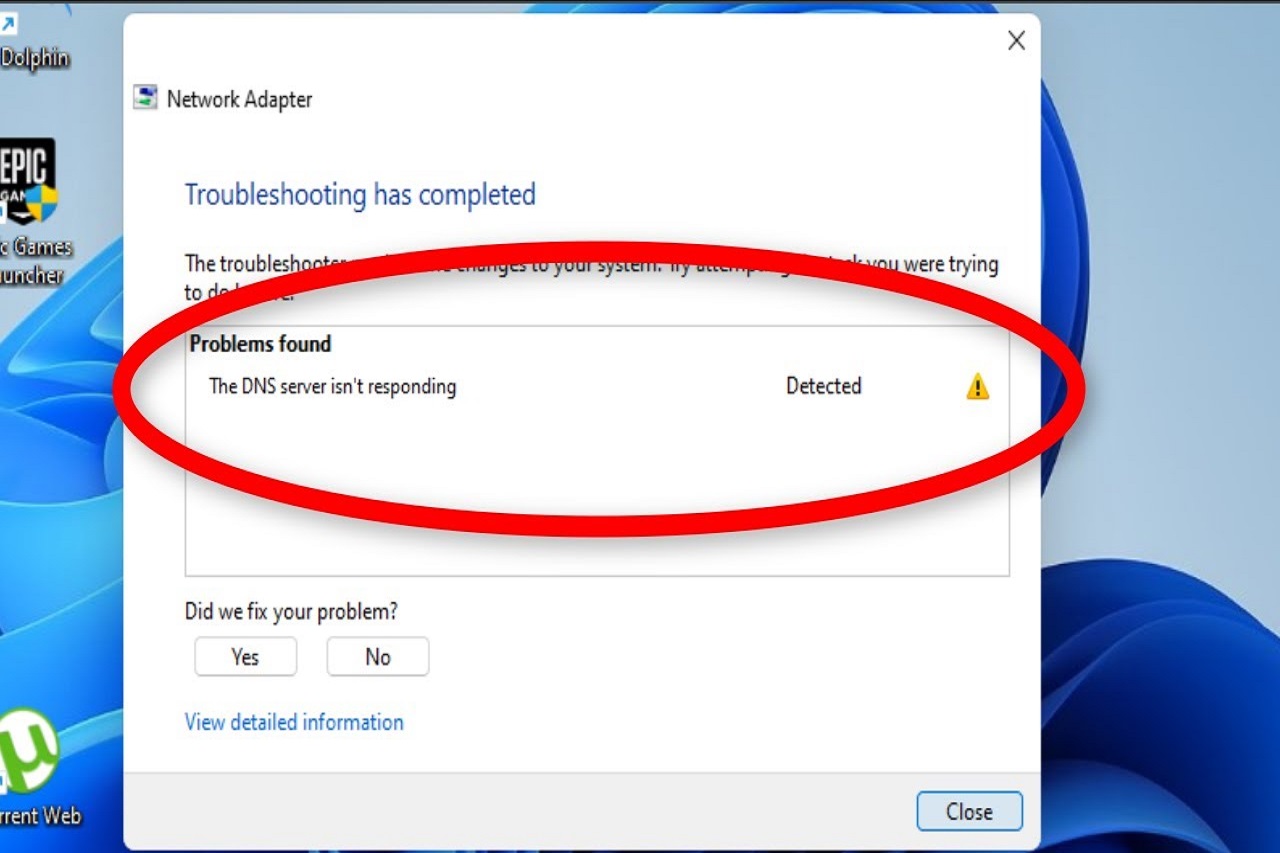

Lỗi DNS server isn’t responding là gì? Nguyên nhân & cách sửa lỗi

10:41 13/08/2024

Lỗi DNS server isn’t responding rất hay gặp trên thiết bị chạy Windows. Khi màn hình máy tính xuất hiện dòng chữ "DNS server isn’t responding", người dùng gần như không thể truy cập được vào mạng internet. Trong bài chia sẻ sau đây, FPT Cloud sẽ tiến hành phân tích nguyên nhân và cách sửa lỗi DNS server isn’t responding hiệu quả nhất.

>>> Xem thêm: Top 16 dịch vụ lưu trữ dữ liệu đám mây tốt phổ biến nhất 2024

1. Lỗi DNS server isn’t responding là gì?

DNS server isn’t responding là lỗi kết nối thường gặp trên thiết bị chạy Windows. Theo đó, khi xảy xuất hiện lỗi này, bạn không thể kết nối tạo kết nối với DNS Server, thiết bị không thể truy cập internet.

[caption id="attachment_18492" align="aligncenter" width="771"] Lỗi DNS server isn’t responding rất hay xuất hiện trên thiết bị chạy Windows[/caption]

Lỗi DNS server isn’t responding có thể xuất hiện bất cứ khi nào. Nó gây không ít khó chịu cho người dùng. Vậy nguyên nhân và cách khắc phục sự cố DNS server isn’t responding là gì? Bạn hãy theo dõi mục tiếp theo để cập nhanh chóng cách xử trí.

2. Nguyên nhân gây ra lỗi DNS server isn’t responding

Có nhiều nguyên nhân dẫn đến lỗi DNS server isn’t responding. Phổ biến nhất là tình trạng card hoặc router xuất hiện lỗi, dịch vụ DNS trên thiết bị tập gián đoạn. Ngoài ra chương trình diệt virus hoặc tường lửa cũng có thể chặn thiết bị kết nối internet.